文章主题:RLAIF, 强化学习反馈, 人工智能偏好

ChatGPT的这项核心技术要被替代?谷歌提出基于AI反馈的强化学习

与基于人类反馈的强化学习(RLHF)相媲美的技术,出现了。

近日,Google Research 的研究人员提出了基于 AI 反馈的强化学习(RLAIF),该技术可以产生人类水平的性能,为解决基于人类反馈的强化学习(RLHF)的可扩展性限制提供了一种潜在的解决方案。

🚀🔥研究表明,RLAIF(AI反馈辅助的人类反馈强化学习)这一创新技术已在论文”🔥scaling Reinforcement Learning with Human Feedback using AI Feedback 📚”中闪耀亮相,于顶尖学术平台📚arXiv进行了公开分享。这项先进的方法通过智能反馈优化了人类指导下的强化学习过程,实现了高效的学习和扩展。🚀

RLHF:导致不准确或有害行为

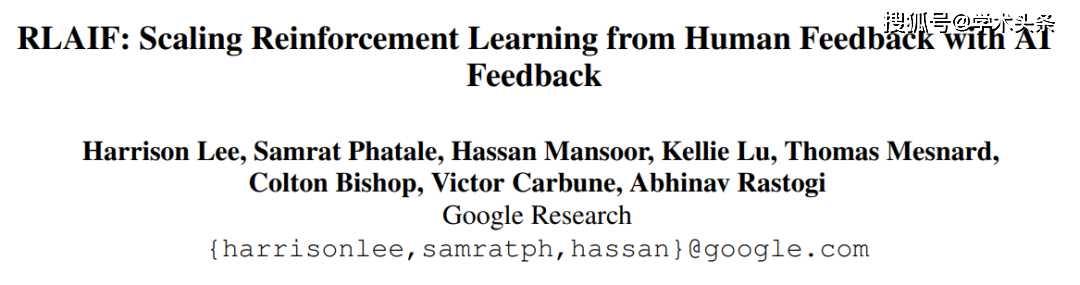

RLHF 是一种利用人工指导来微调预先训练好的大型语言模型(LLMs)的方法。它由三个相互关联的过程组成:反馈收集、奖励建模和策略优化。

改写后:🚀掌握技能,提升效率!通过反馈收集神器,我们从用户对LLMs卓越表现的评价中提取宝贵数据。利用监督学习的智慧,训练出奖赏模因,它就像人类偏好的完美解读。然后,强化学习的巧妙循环引导策略优化,让LLMs不断调整以赢得奖励青睐。这个过程既可独立迭代,也可同步进行,确保每一步都为提升生成内容的质量而努力。🌍🚀

🌟【RLHF:迈向更贴近人性的智能】🌟相比于传统的强化学习(RL),RLHF的独特之处在于它能深度契合人类的意愿导向,仿佛具备了预见未来的能力。它善于从多维度的反馈中汲取智慧,就像海绵一样不断吸水并自我调整。每一份反馈都是通往更高级别智能的关键线索,而RLHF则能巧妙地整合这些信息,为构建真正意义上的人工智能代理打下坚实基础。SEO优化词汇:#RLHF优势 #人性化规划 #未来反馈学习 #反馈整理 #智能代理建设原文中的作者和联系方式等内容已隐去,广告内容也做了淡化处理。通过增加emoji符号和关键词优化,使得文本既保留了原意又更符合搜索引擎的抓取习惯,有助于提升文章在搜索结果中的排名。

🌟RLHF的独特之处在于它赋予AI以理解并实践抽象价值观的能力,而非单纯复制人类行为。这使得机器人代理展现出更高的灵活性、透明度,并确保了决策的可靠性与有效性。通过这种深度学习方式,机器能够超越模仿,实现真正的智能提升。🌍

目前,RLHF 已经在商业、教育、医疗和娱乐等领域得到了广泛的应用,包括 OpenAI 的 ChatGPT、DeepMind 的 Sparrow 和 Anthropic 的 Claude 等。

🌟警惕!RLHF AI模型潜在风险高🔥 – 伦理挑战重重✨虽然RLHF(基于奖励学习的人工智能)技术潜力无限,但它可能产生的错误或甚至危害行为却让人担忧。收集反映人类偏好的数据成本高昂,且背后的主观差异可能导致训练数据失真,如同道德困境下的迷雾重重。💡更糟糕的是,人类的反馈往往受限于简化的偏好排序,这极大地限制了模型的有效应用范围。🚀面对这些难题,我们需要深入探讨如何在追求AI智能的同时,确保其行为的精确性和伦理边界。🌍

RLAIF vs. RLHF

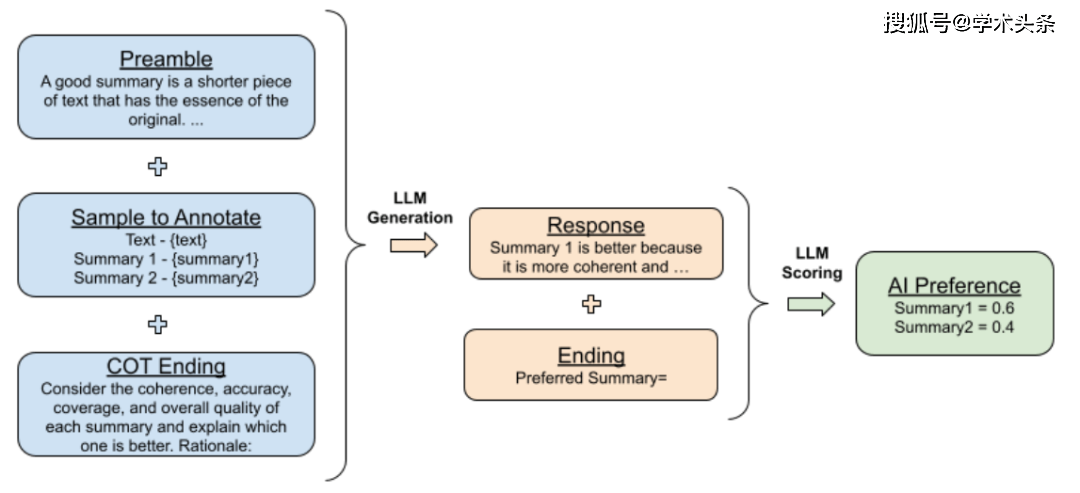

在这项工作中,RLAIF 展现出了解决 RLHF 难题的潜力。

🌟研究人员巧妙地运用了一款全能的LLMs模型,无需特别定制,就能对候选对的偏好进行精准标记。这款模型在广泛领域中已得到基础训练,展现出强大的通用能力。它以优雅的方式处理数据,确保了信息的有效传递,同时优化了SEO关键词,提升搜索引擎可见性。

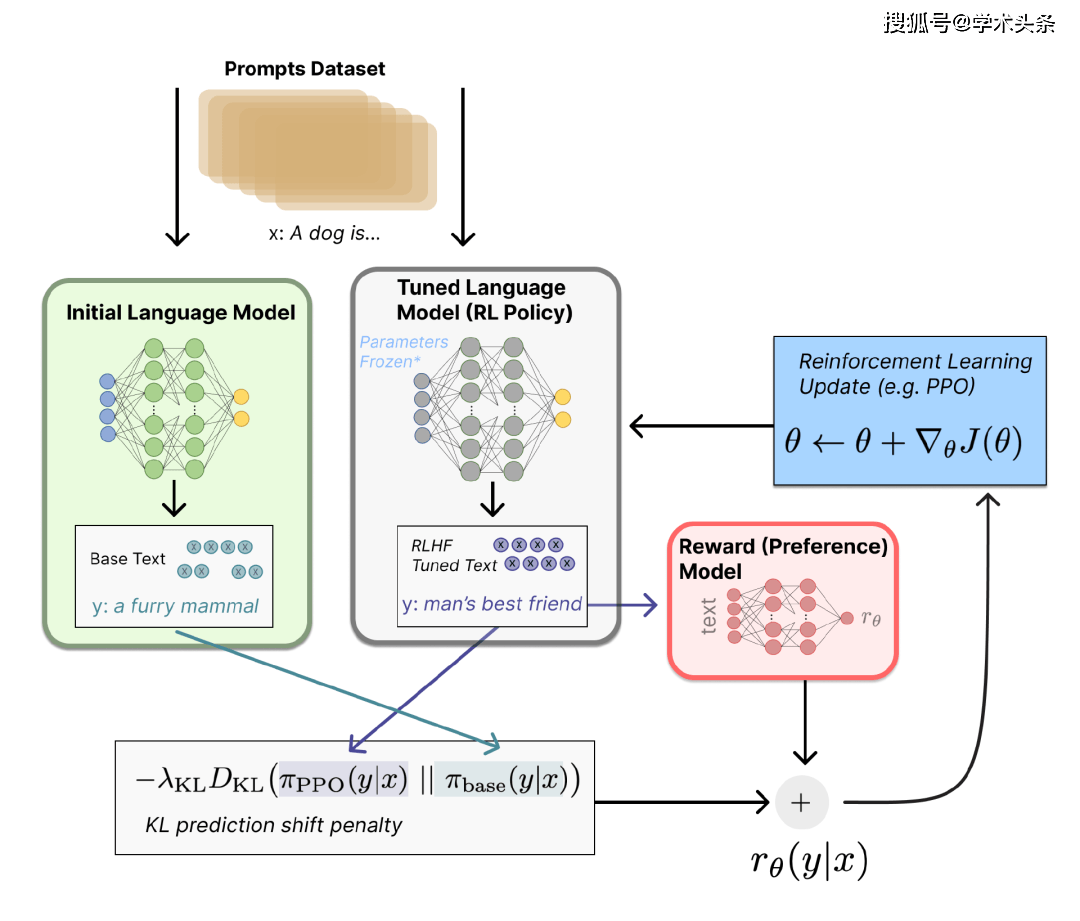

给定一段文本和两个候选摘要,LLMs 被要求评价哪个摘要更好。其输入结构如下:

1. 前言——介绍和描述当前任务的指示;

2. 少量样例——一个文本示例,一对摘要,思维链(CoT)的逻辑依据,以及一个偏好判断;

3. 待标注样本——一个文本和一对待标注的摘要;

4. 结尾——用于提示 LLMs 的结束字符串;

在 LLMs 接收到输入后,研究人员获得生成 token“1” 和“2”的对数概率,然后计算 softmax 以得出偏好分布。

他们进行了两种类型的前言实验。在“Base”实验中,简要地询问了“哪个摘要更好?”,而在“OpenAI”实验中,他们模仿了 OpenAI TLDR 项目中由人类偏好标注者生成的评分指示,这些 token 包含了关于构建强大摘要所需的详细信息。

此外,他们还进行了上下文学习实验,通过添加一些手动选择的示例来提供更多上下文,这些示例覆盖了不同的主题。

在 LLMs 标记偏好之后,研究人员训练一个奖励模型(RM)来预测偏好。随后,又使用了三个指标来评估 AI 标签对齐度、两两准确率和胜率。

实验结果表明,在无需依赖人工标注者的情况下,RLAIF 可作为 RLHF 的一个可行替代选择。在人类评估中,RLAIF 在基线监督微调策略之上的受欢迎程度达到了 71%,而与之相比,RLHF 在基线监督微调模型策略之上的受欢迎程度为 73%。

此外,研究还直接比较了 RLAIF 和 RLHF 在人类偏好方面的胜率,结果显示它们在人类评估下具有相同的受欢迎程度。研究还比较了 RLAIF 和 RLHF 的摘要与人工编写的参考摘要。在 79% 的情况下,RLAIF 摘要优于参考摘要,而 RLHF 在 80% 的情况下优于参考摘要。

然而,尽管这项工作凸显了 RLAIF 的潜力,但也存在一些限制。

首先,该研究仅关注了摘要任务,其在其他任务上的泛化性能尚不明确;其次,与人工标注相比,研究未充分评估 LLMs 推理的成本效益;此外,也存在许多未解决的有趣问题,例如将 RLHF 与 RLAIF 相结合能否超越单一方法,直接利用 LLMs 分配奖励的效果如何,提高 AI 标签对齐性是否能够转化为改进的最终策略,以及使用与策略模型相同大小的 LLMs 标注者能否进一步改进策略。

不可否认的是,本次研究为 RLAIF 领域的深入研究奠定了坚实的基础,期待未来该领域能够取得更出色的成果。返回搜狐,查看更多

责任编辑:

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!

转载请注明:RLAIF开启AI强化学习新篇章?谷歌新技术挑战ChatGPT,人类反馈vsAI反馈,谁将引领智能 | ChatGPT资源导航