文章主题:

OpenAI发布GPT-4

凤凰网科技讯 北京时间3月15日消息,美国人工智能研究实验室OpenAI周二为其爆红聊天机器人ChatGPT发布了最新GPT-4语言模型,这距离ChatGPT的上线仅仅过去了4个月时间。

外媒称,和ChatGPT最初使用的GPT-3.5模型相比,GPT-4带来十大变化,在提升了准确率等功能的同时依旧存在错误、“幻觉”等不足。

以下是外媒汇总的GPT-4主要改进和不足:

更精确

人工智能专家、风险投资公司Page One Ventures合伙人克里斯·尼克尔森(Chris Nicholson)告诉GPT-4,自己的母语是英语,不懂西班牙语。他希望GPT-4给他一份可以教他西班牙基础知识的教学大纲。结果,GPT-4提供了一份详细而有条理的教学大纲。它甚至为学习和记忆西班牙语单词提供了广泛的技巧,尽管并不是所有建议都中肯。

准确性提高

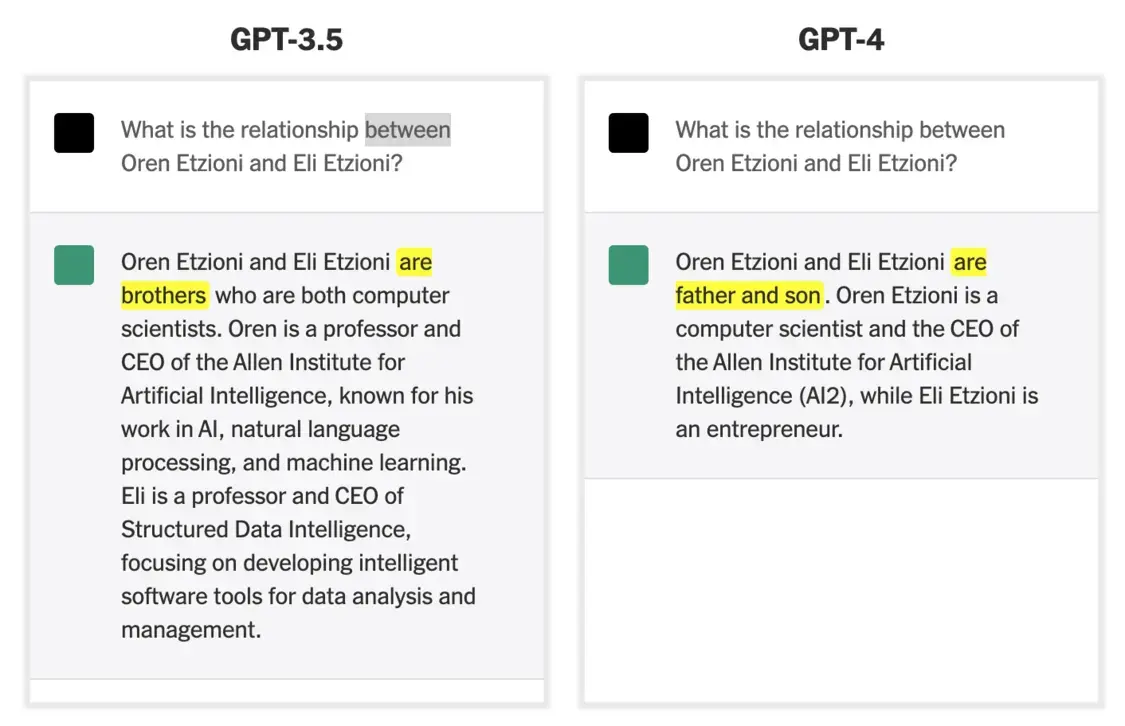

GPT-4比GPT-3.5更准确

它还提高了准确性。当人工智能研究员兼教授奥伦·埃齐奥尼(Oren Etzioni)第一次尝试使用GPT-4时,他问了一个直截了当的问题:“奥伦·埃齐奥尼和伊莱·埃齐奥尼(Eli Etzioni)之间是什么关系?”机器人的反应是正确的,称两人是父子关系。相比之下,GPT-3.5的回答则是错误的,称他们两人是兄弟关系。但是,GPT-4也存在错误。它说,奥伦是奥伦人工智能研究所的CEO,但实际上奥伦已经卸任了这一职位。

更详细地描述图像

能详细描述图像

GPT-4能够对图像和文本做出惊人的详细描述。OpenAI总裁兼联合创始人格雷格·布罗克曼(Greg Brockman)演示了该系统如何细致地描述来自哈勃太空望远镜的图像。它还可以回答有关图像的问题。如果给出一张冰箱内部的照片,它就能建议你用手边的东西做几顿饭。

更专业

北卡罗来纳大学教堂山分校的医学副教授兼心脏病专家阿尼尔·盖希(Anil Gehi)向GPT-4描述了他一天前看过的一位病人的病史,包括这位病人入院后经历的并发症,描述中包含了几个外行不懂的医学术语。当盖希医生问机器人询问他该如何治疗病人时,GPT-4给了一个他完美的答案。“这正是我们对待病人的方式。”他说。不过,这种知识不太可能在每次使用机器人时都展示出来。它仍然需要像盖希这样的专家来判断它的反应并执行医疗程序。但它可以在从计算机编程到会计在内的许多领域展示这种专业知识。

要抢编辑饭碗

当被给出一篇来自《纽约时报》的文章时,这个新的聊天机器人几乎每次都能给出精确而准确的故事摘要。如果你在摘要中添加了一个随机的句子,并询问机器人摘要是否不准确,它就会指向被添加的句子。埃齐奥尼博士称,这是一项非凡的技能,“要做高质量的摘要和高质量的比较,它必须对文本有一定程度的理解,并能够清楚地表达这种理解。这是一种高级形式的智能”。

越来越幽默

埃齐奥尼博士要求新机器人“讲一个关于歌手麦当娜的新笑话”,后者的回答给他留下了深刻的印象,也让他笑了。机器人讲的笑话是:“麦当娜为什么学习几何?因为她想学习如何在各个角度摆造型!”

擅长标准化考试

OpenAI表示,新系统可以在美国41个州和地区的统一律师资格考试(UBE)中获得前10%左右的成绩。 根据该公司的测试,它还可以在SAT考试中获得1300分(满分1600分),在高中生参加的大学生物、微积分、宏观经济学、心理学、统计学和历史先修课程考试中获得5分(满分5分)。

推理能力下降

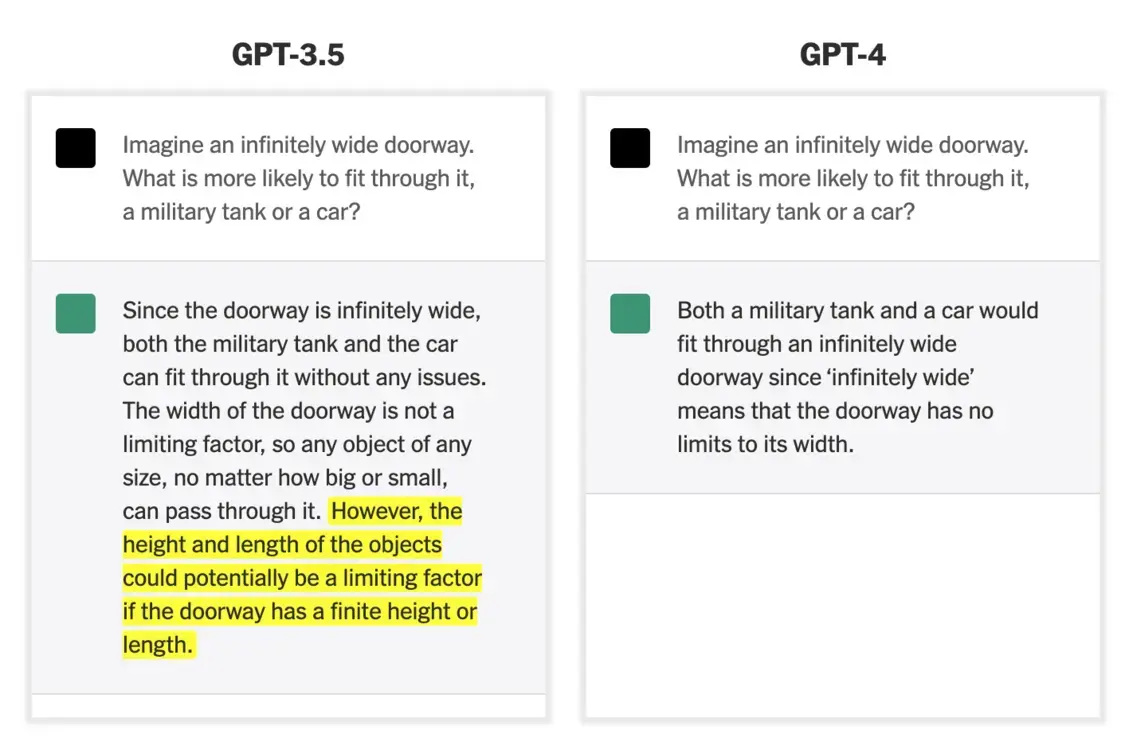

GPT-4推理能力不如GPT-3.5

埃齐奥尼博士给GPT-4出了一个难题,“想象一个无限宽的门口。哪个更有可能通过它,军用坦克还是汽车?”GPT-4似乎做出了适当的反应,但是给出的答案没有考虑到门口的高度,因为门口的高度可能会阻止坦克或汽车通过,这一点不如GPT-3.5。OpenAI CEO萨姆·阿尔特曼(Sam Altman)表示,这款新机器人可能会“一点点”推理,但它的推理能力在很多情况下都失灵了。以前版本的ChatGPT处理这个问题稍微好一点,因为它认识到高度和宽度的重要性。

不擅长讨论未来

尽管这个新的机器人似乎能对已经发生的事情进行推理,但当被要求对未来进行假设时,它就不那么擅长了。它似乎是在借鉴别人的说法,而不是创造新的猜测。

仍会产生幻觉

新的机器人还是会瞎编。这个问题被称为人工智能“幻觉”,困扰着所有领先的聊天机器人。由于系统不知道什么是真的,什么是假的,它们可能会生成完全错误的文本。当被要求提供描述最新癌症研究的网站地址时,它有时会生成不存在的互联网地址。

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!