文章主题:ChatGPT, InstructGPT, AI, 指令学习

🎓🎨ChatGPT:AI界的潮流引领者,从零到精通只需一针一线!🔍作为AI领域的探索者,我们不妨以谦逊学者的姿态,跟随ChatGPT的脚步,领略其创新的魅力。它就像一位技艺高超的导师,用简洁明了的语言为我们编织技术的故事。👩🏫ChatGPT以其强大的能力,轻松驾驭复杂概念,像缝纫机一样缝合知识的碎片,让我们这些学术界的小裁缝得以一窥学术造纸的奥秘。💡但深入理解科技的内核,还需仰望那些真正的学术泰斗。他们犹如造纸大师,用严谨的理论和实践为我们铺就通向真理的道路。📚如果你对ChatGPT的好奇心不减,不妨在探索的旅程中,适时转向那些权威的声音,那里有最纯粹、最深入的技术解析。👇#ChatGPT学习指南 #学术探索之路 #技术巨头解读

全文阅读时长:15min

背景介绍

ChatGPT太牛批引起了全球关注,不光卷AI圈内人,还连带卷了圈外人。

发展现状

🌟ChatGPT与InstructGPT,两位备受瞩目的AI姐妹,悄无声息地在技术的海洋中激起层层涟漪。💡作为GPT-4的前奏曲,它们曾以GPT-3.5之名悄然登场,预热着未来的科技盛宴。🔍据坊间传言,即将面世的GPT-4将打破传统,成为一个全能型多模态模型,让对话更加丰富多彩,仿佛置身于一个互动的多媒体世界。ChatGPT的独特之处在于它能理解并回应多种媒介内容,从文字到视频、图片,乃至语音,为用户提供更为鲜活和生动的交流体验。💬这不仅意味着交互方式的革新,更预示着AI技术在人机交互领域的深度拓展,让智能化服务更加贴近生活,触手可及。让我们期待ChatGPT的未来表现,它将以怎样的创新引领这场智能革命?💡SEO优化提示:ChatGPT、InstructGPT、GPT-4、多模态、AI交流、多媒体世界、交互革新、智能化服务。

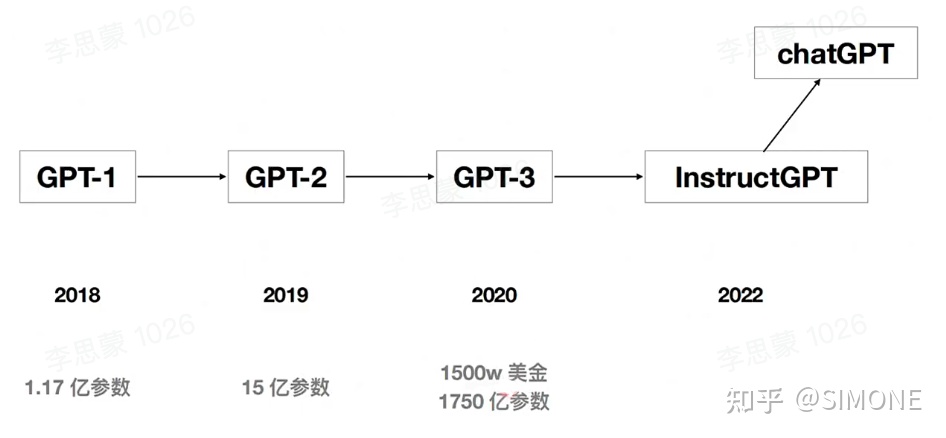

GPT进化史

模型架构

🌟ChatGPT与InstructGPT虽架构相似,皆采用指令学习(📚InstrL)和RLHF训练法,两者间的差异主要体现在数据采集路径上。遗憾的是,ChatGPT的内部运作和研发细节至今保密,不过我们可以通过深入研究InstructGPT来洞察其卓越功能背后的训练原理。💡欲探索ChatGPT的核心秘密,虽然官方暂未公开论文与代码,但其技术实力不容忽视。借助InstructGPT这一窗口,我们可以揣测ChatGPT是如何通过指令学习和RLHF优化模型的。📚🔍对于对AI感兴趣的小伙伴们,这无疑是一次绝佳的学习机会,让我们一起期待ChatGPT未来能带来更多创新和突破。🚀

核心技术

指令学习(Instruct learning):其实就是prompt learningRLHF(Reinforcement Learning from Human Feedback):基于人工反馈的强化学习

训练步骤

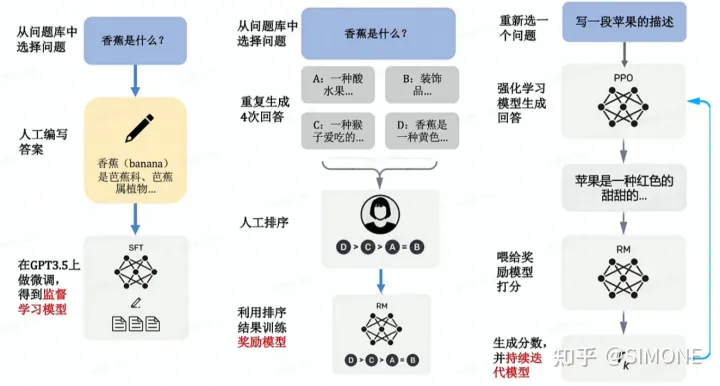

🏆练就超能助手,只需三步魔法!🚀1️⃣ **SFT大揭秘** 🧬 – 首先,我们用强大的数据科学魔法(SFT)唤醒模型的智慧,让知识如泉涌般流淌。2️⃣ **RM深度炼成** 💻 – 紧接着,通过深层强化学习(RM),模型逐步掌握语言的精髓和灵活性。3️⃣ **PPO策略升华** 🎮 – 最后,用优化的路径梯度策略(PPO),确保每一次迭代都迈向卓越。每一步都是通往超凡技能的关键,ChatGPT与InstructGPT在这些步骤中茁壮成长。🚀欲了解更多训练细节或寻求专业帮助?请随时咨询,我们是知识海洋中的导航者!👩🏫navigator@yourdomain.com 🌊

InstructGPT/ChatGPT模型架构

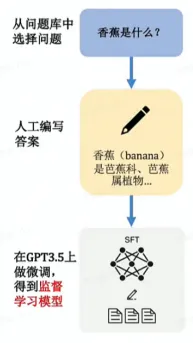

1.SFT

ChatGPT,一款备受瞩目的对话模型,其背后的工作原理确实令人好奇。首先,它的智能源于SFT,即Supervised FineTune的简称,这是一种通过有监督微调的方式对GPT-3进行深度定制的过程。简而言之,就是通过对特定数据集的训练,让模型学会以人类喜欢的方式回应。这项技术的核心目标是提升内容质量,确保生成的答案更贴近我们的期望。通过这样的方式,ChatGPT得以在互动中展现出卓越的自然语言处理能力,仿佛具备了理解与创造的能力。

GPT原本是使用互联网海量语料库训练的大模型,但互联网上的语料非常杂乱,不一定是人类想要的答案,GPT依靠此数据生成的答案正确性和有用性不能保证。在此基础上,对数据集优化,把人们喜欢的答案喂给已经训练好的GPT再次微调,这样模型可以对齐人的思考模式得到提升。可以理解成升级后的模型只订阅人们喜欢的内容。对话机器人的雏形已经生成,它可以根据问题生成一系列的答案,但是缺陷是它不具备人的判断能力。机器生成了答案A,B,C,D,但哪个是想要的呢的答案呢?由此,引入RM奖励模型。

SFT工作流

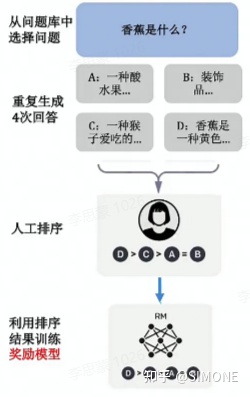

2.RM

🎨📚强化学习RM:智能内容生成的创新之旅🔍🔍 引领未来,RM(Reinforcement Learning)揭开深度学习的新篇章!它以独特的方式,让机器学会如何创造,而非仅仅模仿。不再受限于指导路径,RM赋予模型无尽可能的探索自由,从而训练出更具通用性的解决方案。🚀👩💻 实践步骤,解锁智能生成的秘密密码:1️⃣ **环境设定**:构建一个反馈丰富的世界,让模型在互动中学习。2️⃣ **奖励系统**:对好的内容给予正面强化,推动模型优化。3️⃣ **迭代探索**:通过试错和调整,逐步提升生成质量。4️⃣ **泛化能力训练**:确保模型在新情境下也能表现出色。🔍 SEO优化提示:- “RM强化学习:内容生成的智能策略”- “深度学习与RM:打破传统,塑造未来”- “探索自由:RM如何提升模型泛化能力”记住,每一次创新都源于对知识的热爱和对未来的洞察。让我们一起见证RM引领的这场内容革命!💪🌟

首先,模型根据问题生成多个答案。人工对给定的答案进行排序和打分。机器通过人工打分的数据训练奖励模型,可以预测用户更喜欢哪个模型输出。

RM工作流

一个更通俗的例子,讲解SFT和RM的工作方式和区别:

SFT用「人工标注」的问题回答数据,并用监督性学习技术训练的自动回答问题的模型。RM用「人工打分」的问题回答数据,并用强化学习技术训练的自动给回答打分的模型,SFT是通过「人工标注」解决答案「有没有」的问题,RM则通过「人工打分」来解决答案「好不好」的问题。

SFT和RM的工作方式和区别

3.PPO

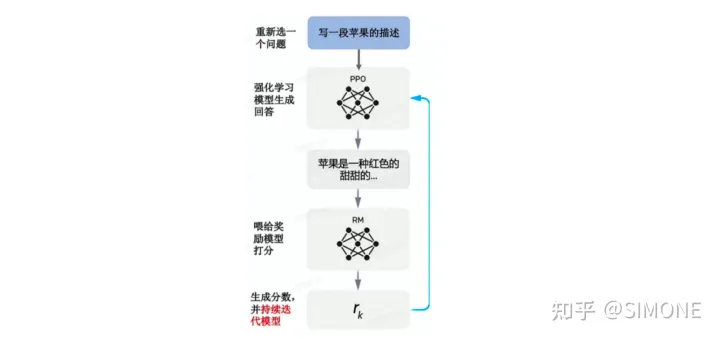

该阶段将前面训练好的SFT和RM两个模型结合起来,利用PPO(Proximal Policy Optimization)算法微调SFT训练出来的生成模型,再把生成出来的答案喂给RM打分模型,基于RM的loss持续迭代生成模型。具体步骤如下:

由第一步fine-tune后的SFT模型来初始化PPO策略模型,由第二部生成的RM模型初始化价值函数。从PPO数据集中随机采样一个prompt,并通过第一步的PPO策略模型生成输出结果answer。对prompt和answer,带入RM模型计算奖励值reward。利用reward来更新PPO策略模型参数。重复2~4步,直至PPO策略模型收敛。

强化学习和预训练模型是最近两年最为火热的AI研究方向,之前不少科研工作者说强化学习并不是非常适合应用到预训练模型中,因为很难通过模型的输出内容建立奖励机制。而InstructGPT/ChatGPT反直觉的做到了这点,它通过结合人工标注,将强化学习引入到预训练语言模型中是这个算法最大的创新点。

PPO工作流

参考文献

https://arxiv.org/pdf/2203.02155.pdf

https://zhuanlan.zhihu.com/p/590311003

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!