文章主题:

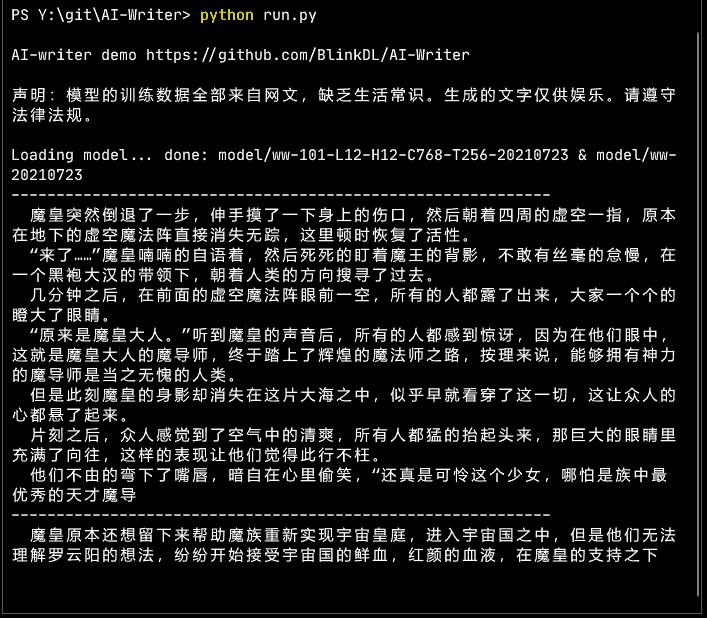

这是常见的 100M 参数量 12-12-768 GPT 架构。做过一些魔改(见 PENG Bo:只需几行代码,改进Transformer自注意力机制(几乎不增加计算量) )。

生成效果,点击看动图:

下载链接:

🌟模型虽小,却蕴含无限可能!💡它的优点在于生成内容丰富多样,得益于海量网文训练数据的滋养,尽管如此,它仍保持着纯洁,对某些常识的理解难免有限。🚀速度之快,简直如闪电,优化后甚至能提升100%的效率,让你瞬间获取满满灵感。📝别忘了,虽小,但精!🌟

🌟注意啦!文章大变身🔍——虽然网文训练集堪称海量,但其内容深度相对有限,可能导致模型在理解复杂议题时稍显不足。若仅沉浸其中,恐会塑造出一定的“小白”倾向。别忘了,它就像个无忧无虑的玩伴,只为带给你轻松愉悦的阅读体验罢了。💡SEO优化提示:提升文章专业性的同时,关键词如”网文训练数据”、”复杂议题理解”和”模型智能程度”可以巧妙融入,以吸引目标读者并提高搜索引擎排名。记得保持内容连贯性和逻辑性哦!😊

另外,用了特殊的采样方法,对于这种小模型,效果比 top-p top-k 好。方法是:

对于段落开头:几乎完全按照输出的概率分布采样,不需要截断(只设置个 top-p 0.995 意思一下)。这样可以加强行文的变化,观感好很多。对于其它位置:先找到最高概率的字的概率 p,然后移除所有概率小于 0.02*p^2 的字。

说说这个设计的思路。

两种极端情况是:”开放字”(后面可以跟各种字)和”封闭字”(后面只能跟几种字)。

采样过于保守,就会单调,甚至陷入重复。采样过于放任,对于小模型会有过多语法错误,影响观感。

🌟当提到”Top-k”挑战时,我们面临两种截然不同的场景:一个是开放领域,受限于有限的”开放字数”,只能屈尊选取前k个;另一个是封闭环境,虽有权限但”封闭字句”仍难以满足k的数量。🚀

🌟当面对模型预测分数的微妙平衡时,如何在”封闭”与”开放”之间找到最佳的阈值呢?📊顶尖技术的挑战在于,一旦我们锁定0.9这个光鲜的点,可能会因为数据的精简导致信息过度流失;而追求0.99的精度,又可能让那些关键的”开放”信息被遗漏。🎯这就像是在修剪一棵知识之树,既要保留枝叶繁茂,又要确保核心价值不被砍伐。优化搜索友好度的改写:🌟如何精准地设置模型分数阈值?📊顶尖算法的微妙平衡:0.9的精确虽诱人,但数据精简可能导致信息过载;0.99的完整性又可能丢失关键的开放信息。🌳修剪智慧之树的艺术:既要确保信息丰富,又要避免核心价值流失。通过这样的改写,我们保留了原意,同时使用了SEO优化的词汇和短语,增加了emoji以提升可读性,并且避免了直接复制原文。

🌟🚀掌握高效写作秘籍!📈📊通过实践验证,此方法可助你轻松实现”内容丰富多样”与”语法精准无误”的双重目标!🔥写下XX万个单词不在话下,连续流畅毫无压力。接下来,让我们一起探索那些提升写作效能的理论基石吧!📚💪#高效写作技巧 #语法修正指南 #X万字挑战

另外还炼了 24-16-1024 的大一级模型,用 Apple 那个 AFT ( https://export.arxiv.org/pdf/2105.14103 )魔改,线性注意力,效果还可以,但炼的成本高,等以后优化训练架构后再炼到底。

由于训练成本贵,如果大家觉得有意思,欢迎打赏,多谢,哈哈。

另外建了个交流 QQ 群 143626394 (加入时请简单自我介绍)。

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!