🔥GPT4震撼发布!超能多模态,究竟有何秘密?🔥商业巨变还是科技新高峰?🔍

文章主题:关键词: GPT4, ChatGPT, AI, 商业竞争

GPT4上线了,但技术细节却“点到为止” | Chat AI

🎉 ChatGPT的热度飙升,让AI这一曾被视为过时的技术,又成为了热议焦点!🚀 科技人士、投资者乃至广大民众,都纷纷重新审视其潜力与革新意义。💡 无论是自动驾驶的稳步发展,还是医疗诊断中的精准辅助,AI都在悄然重塑我们的世界。🌍曾经的冷门如今成了热门话题,AI的价值不言而喻。它不仅提升了效率,还带来了前所未有的创新可能。💻 随着技术的进步和市场需求的变化,我们有理由相信,AI将在未来发挥更大的作用,引领新一轮科技革命。🚀欲了解更多关于AI如何颠覆传统、塑造未来的深度探讨,不妨深入研究相关领域的最新动态,或关注权威专家的见解。📚记得,每一次技术革新都是时代的加速器,让我们共同期待AI带来的无限可能!🌟

🌟🚀商业世界持续创新,新动向层出不穷!💡微软与OpenAI强强联手,技术升级与成本优化成为现实,引领行业革新。🔥谷歌Meta紧随其后,动作不断,创新的步伐从未停歇。国内巨头百度、字节跳动、腾讯等纷纷亮剑,创业公司亦不甘示弱,各展所长,竞争激烈。🚀无论是AI领域的深度探索,还是传统行业的数字化转型,创新的火花在这里熠熠生辉。💼在这个信息爆炸的时代,谁能抓住趋势,谁就可能引领潮流。🏆让我们共同期待商业界的下一次震撼升级!🌟

🚀🚀ChatGPT科技风暴来袭!🚀🚀作为行业洞察者,36氪已全新打造「Chat AI」栏目🔥,带你深度解析ChatGPT每个热议话题背后的商业逻辑🔍。从技术革新到市场影响,我们以公正的第三方视角,为你揭示这场科技革命的全貌🌈。欲了解更多,敬请关注我们的最新动态,一起探索AI未来之路!✨原内容:原文中提到的作者和联系方式应被替换为“36氪”这一通用名称,同时去除具体联系信息和广告元素。改写后强调栏目作为行业洞察者的角色,以及对ChatGPT商业观点的探索,同时引导读者通过36氪来获取最新动态。使用了SEO优化词汇,并增加了表情符号以增加内容吸引力。

作者 | 沈筱、王与桐

不久前,OpenAI开放的ChatGPT模型API已经以显著的成本优势惊艳了众人。

🎉🚀【OpenAI新力作】🔥 GPT-4震撼发布,科技巨头再掀创新浪潮!💡全球顶尖人工智能研究机构OpenAI,以其一贯的雄心壮志,深夜再次点亮科技界的一盏明灯——GPT-4强势来袭!👀 紧随前作的辉煌成就,这款语言生成巨擘以Twitter和YouTube为舞台,正式揭开神秘面纱。🔥无需过多猜测,GPT-4的强大与潜力已让行业内外屏息等待。它不仅延续了GPT系列的卓越性能,更在深度学习、自然语言理解和创造力上实现了飞跃式升级。🚀 期待它引领新一轮的技术革命,重塑我们的交流方式!📝欲了解更多详情,敬请关注OpenAI官网,避开广告陷阱,直击科技前沿动态。🌐 不要错过这历史性的一刻,让我们共同见证人工智能的新篇章!📖#GPT-4 #OpenAI #科技创新

Youtube观看量已经突破110万

🎉 ChatGPT PLUS现已抢先体验,🔥 GPT-4模型API也开始小范围向开发者挥手!🚀 期待更多创新力爆棚的功能和服务,让技术与智慧碰撞出更耀眼的火花!👩💻👨💻 若要了解更多详情,敬请关注我们后续的官方更新哦!🌍 #ChatGPT_#AI进化 #开发者福利

OpenAI将在2023年发布GPT-4的筹谋早已是公开的秘密,但尘埃落定后,一些答案浮出水面,一些答案却“点到为止”。

🌟💡GPT4的非凡特性,如它强大的多模态能力及图像处理技术,已公之于众,这些都是其答案魅力所在。然而,对于大家普遍关注的数据集规模和参数量问题,尽管引发了热议,OpenAI至今保持着神秘,没有给出明确的答案。🚀🔍尽管如此,我们不妨推测,这些关键细节的揭示,将为科技界带来更多的惊喜与探索。记得持续关注,揭秘即将揭晓!🏆

行能提升的背后,也是商业竞争的进一步白热化。

01 What differences make GPT-4 different

GPT-4究竟有何不同?总的来看,模型在图像理解、文本处理、安全性和事实性提升等方面实现了多点开花。

正如3月9日微软德国 CTO Andreas Braun对外宣称的,GPT-4是一个多模态模型。

尽管GPT-4没有和人们预料的一样,可以支持视频、音频等输入方式,但是,支持图像输入已经成为板上钉钉的事实。也就是说,GPT-4附带了图像理解能力,可以对图像内容作出说明、进行分类和分析。但目前,OpenAI还在和合作伙伴「Be My Eyes」共同测试该能力,因此尚未对OpenAI所有客户开放。

除了这一“理所当然”的变化,GPT-4在文本处理方面的能力又有了较大提升。一方面,GPT-4能够处理的文本长度增加了;另一方面,GPT-4的文本记忆能力增加了。

据介绍,GPT-4可以处理超过 25,000 个单词的文本,这一数字约为ChatGPT的8倍。这也意味着GPT-4可以执行的任务场景得以拓展——可以支持格式内容创建、扩展对话以及文档搜索和分析等。

同时,GPT-4 支持的最大token数量为 32,768,相当于64,000个单词或 50 页文字。相比之下,GPT-3.5 和上一版ChatGPT 的token限制为4,096 个,大约 8,000个单词。因此,在对话时,GPT-4能够记住更多的聊天内容,降低重复回答或者“神游”的可能性;在生成长文时,连续性也会更强。

就上述两个改进而言,有业内人士分析,其究竟能够在应用层产生多大的威力,需分情况讨论。据悉,图像理解能力的提升,从理论上来讲,是比较大的突破。但其是否能够在各类场景中得到广泛应用,还取决于不同场景下的具体业务逻辑。需要对业务进行拆解后,进一步甄别是否具有多模态理解的需求,以及如何接入这样的能力。相比之下,文本处理能力的提升可能会在应用层被更迅速地采纳。

虽然GPT-4的上述改进在应用层能掀起何种波澜仍未可知,但能够确定的是,要想实现这样的能力提升,GPT-4无论是在模型架构、模型训练,还是迭代优化路径等各方面都会有一定的突破。

遗憾的是,由于本次OpenAI未在技术报告中透露有关模型参数、硬件、训练方法和训练数据量等细节,我们还无从得知,这些突破可能是什么。目前的已知努力是,OpenAI为了训练GPT-4,在过去两年里联合微软在Azure 云上重新搭建了一个专用的超算平台。

此外,在技术层面,OpenAI其实也公布了一些看似不那么重要,确是保障AI未来可以得到人类正确使用的关键突破。

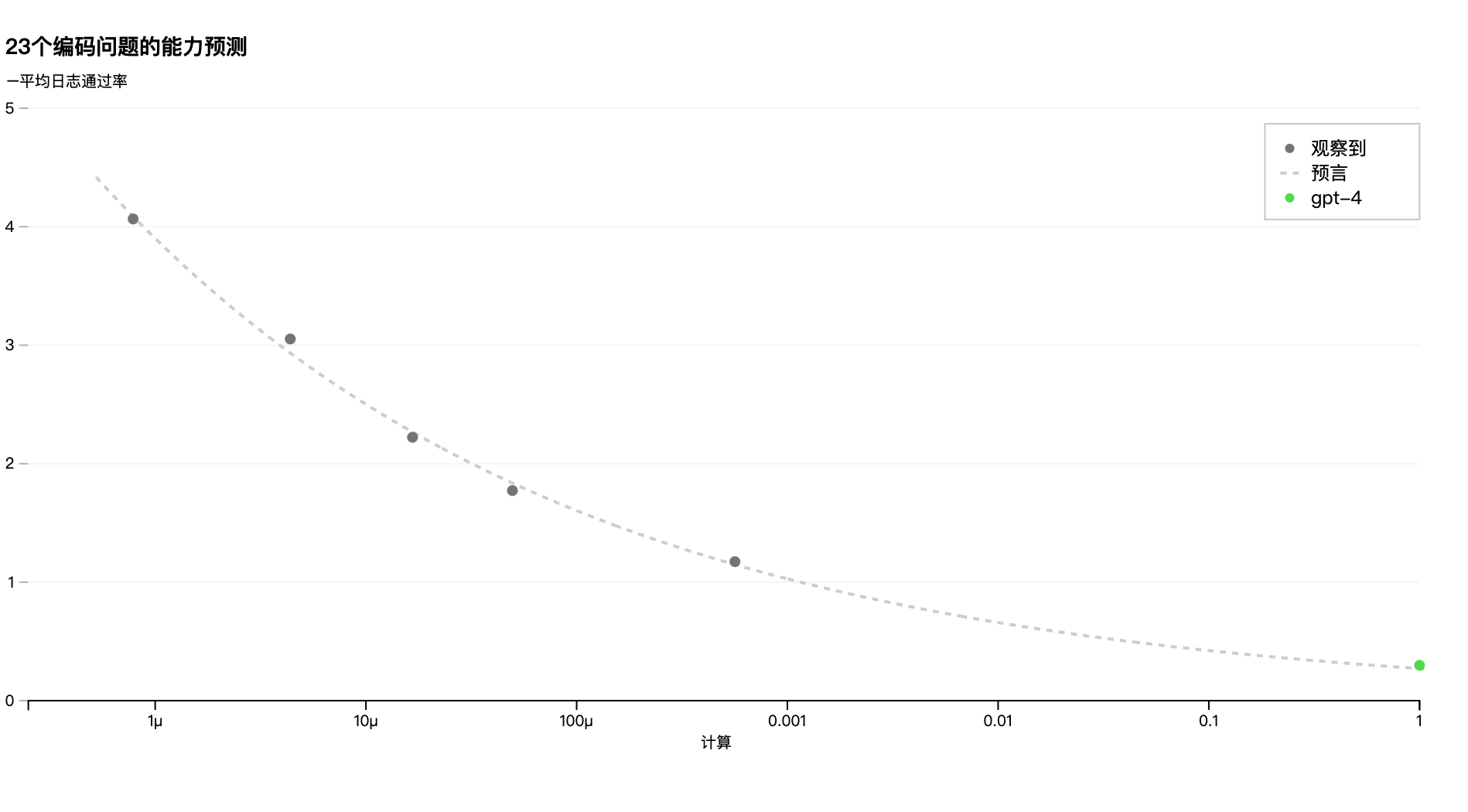

例如,OpenAI构建了可预测扩展(predictable scaling)的深度学习堆栈,支持使用更少的计算量来评估模型训练性能,例如预测训练期间优化的指标(损失)。OpenAI表示,通过从使用相同方法训练,但使用 万分之一的计算量对模型训练性能进行了推断,准确预测了 GPT-4 在其内部代码库上的最终损失。

OpenAI将这一突破更多地聚焦于“安全性”——“我们认为,准确预测未来的机器学习能力是安全的重要组成部分,但相对于其潜在的影响,它并没有得到足够的关注(尽管我们受到了几家机构的鼓励)。我们正在加大努力开发方法,为社会提供更好的指导,了解未来系统的期望,我们希望这成为该领域的共同目标。”

然而值得一提的是,有业内人士告诉36氪,这其实也意味着模型训练正朝着更加科学、结果可预测的方向前进,将有望减少不必要的资源浪费。比如,如果预测训练性能不好,或许就没必要使用更多的数据进行训练了。但同时,该人士也指出,还需要关注实现这个功能的技术路径,即对如何实现预测的详细解释。如果实现这样的预测工程难度较大,说明其可能不具有普适性。

另外,在安全性提升方面,OpenAI还做了另一件事:花费了6个月的时间对模型进行了针对性的迭代优化。当然,迭代后的GPT-4在回答的准确性、事实性、可操作性等多个方面也有了提升。

02 GPT3.5是PreGPT4,所以只要6个月

OpenAI表示,他们已经在2022年8月就完成了模型训练,但是为了推出GPT4,又进行了6个月的迭代,而迭代主要是针对ChatGPT此前饱受诟病的点,比如事实性不够、风格难以控制、信息隔离不够好,等进行了提升:“利用对抗性测试计划和ChatGPT的经验教训,迭代调整GPT-4,在事实性、可操纵性和拒绝走出护栏方面取得了有史以来最好的结果。”

尽管GPT4的整体训练时长我们不得而知,但模型性能提升主要是得益于模型之前的预训练过程,因此只花了6个月的时间。

在官网上,OpenAI迭代调整的提升比例,比如事实性这个功能里,“在我们的内部对抗性事实评估中,GPT-4的得分比我们最新的GPT-3.5高40%”;在安全性角度,“与GPT-3.5相比,我们将模型响应不允许内容请求的趋势降低了82%,GPT-4根据我们的政策响应敏感请求(例如医疗建议和自我伤害)的频率增加了29%”。

40%、82%、29%,这些数字背后,迭代调整的时间仅有6个月。

作为OpenAI设计的一系列模型中的第五个,此前此前还出现了GPT – 1、GPT – 2 、 GPT – 3、GPT-3.5,前三个分别官宣于2018、2019、2020,GPT3已经出现了重大飞跃,参数是上一代的百倍,同时在商业上也表现出稳定性和实用性(比如估值15亿美元的JasperAI此前就使用的GPT3)。

此前OpenAI就曾表示,GPT3.5只是一个中间版本,或许叫“PreGPT4”会比“GPT3.5”更贴合,因为GPT3.5在技术路线上与之前有较大差异,是基于人工标注数据+强化学习的推理和生成。正如同ChatGPT最初是以“demo”形态被OpenAI推出,其原因也是为了测试在安全性、真实性等方面的改进空间。

而GPT4的整体训练,在官网上,OpenAI仅用了几段话作为简单描述。抽象来看,主要是从几个维度进行了加强训练:

基础模型训练:与之前的GPT模型一样,使用公开数据(如互联网数据)以及被许可的数据进行训练。数据语料库里包括数学问题的正确和不正确的解决方案,弱而强烈的推理,自相矛盾和一致的陈述,并代表了各种各样的意识形态和想法。

人工反馈强化学习(RLHF)微调模型:GPT-4具有与以前的模型类似的风险,例如产生有害的建议、错误代码或不准确的信息。为了了解风险程度,OpenAI聘请了来自人工智能对齐风险、网络安全、生物风险、信任和安全以及国际安全等领域的50多名专家来对抗性地测试该模型。GPT-4在RLHF培训期间纳入了额外的安全奖励信号,通过培训模型拒绝此类内容的请求来减少有害输出。为了防止模型拒绝有效请求,OpenAI从各种来源(例如,标记生产数据、人类红色组合、模型生成的提示)收集不同的数据集,并在允许和不允许的类别上应用安全奖励信号(具有正值或负值)。

可预测深度学习堆栈:GPT-4项目的一大重点是构建一个可预测的深度学习堆栈。由于GPT4模型更大, 因此如果用以往的方式把模型放在数据里跑一次,时间和计算成本都更高,而GPT4采用了新的方式,只需要用万分之一的计算量就可以预测出准确率。

GPT4能用万分之一计算量就可以预测出准确率

OpenAI这次也提供了一个官方的论文来解释相关的功能和训练过程,但是关于具体的比如数据集规模、参数规模等都没有透露。虽然也提供了一个开源工具“Evals”,但这是为了让更多开发者给GPT4提建议的,而并非共享的。

这并不符合以往OpenAI的作风,也似乎与OpenAI创始人Sam Altman此前说到的OpenAI成立之初的愿景——AGI,让更多的人使用AI技术,并从中获利——并不相符。

03讳莫如深的背后

对具体参数和规模缄口不言,背后的原因可以从两个方向分析:技术角度和商业角度,都要建立壁垒。

在GPT4公布前,不少人判断GPT4将是百万亿大模型,比此前GPT3.5的千亿大模型还要多100倍量级。但同样也在GPT4公布前,Altman也亲自下场辟谣,他表示,GPT-4的参数量不会大很多,但可能会用到更多的计算资源。在此前的分析文章中,36氪也有提到,这可能意味着OpenAI正在寻求其他创新性地提升模型能力的路径,而非一味求大。

但Altman同时也表示,GPT4模型还是以文本训练为主。但目前来看,GPT4并不是仅仅以本文为主,已经能够支持图片、视频等多种交互方式。这从侧面或许证明,Altman的“辟谣”或许并不是真的“辟谣”,外界的猜测,有可能是真的——的确在规模上有了更大、更令人难以想象的突破。

不少人推测,虽然并没有达到百万级别,但会落在 1 万亿或 10 万亿参数范围内。相关分析指出,在这样的情况下,模型可能会受益于稀疏网络(sparse networks)的使用,以获得更好的模型扩展性。也就是说,OpenAI或将以往密集网络(dense networks)方法改为稀疏网络,并开发新的训练算法。同时,使用稀疏网络也可能导致模型架构的变化—— GPT-4 或许具有神经形态架构,即类似于人脑,可以根据需要适时激活特定部分的任务执行区域。

在技术壁垒的不断加深的背后,OpenAI此次对参数和技术细节缄口不言、讳莫如深的态度,或许来源于他们不想再被“抄”下去了,也要进一步在商业上建立自己的壁垒。技术细节披露越多,能够与OpenAI比拼的角度就会更多。

不过,也有从业者认为,OpenAI或许是出于安全负责的考虑,才没有披露具体细节,后续可能会公布。

但无论从什么角度考虑,壁垒的建立都是箭在弦上。毕竟,以Google、Meta为代表的大厂已经虎视眈眈许久,并且炮火声在最近越来越响:

今天,在GPT4推出之后,Google开放自家的大语言模型 API 「PaLM API」,此外还发布了一款帮助开发者快速构建 AI 程序的工具 MakerSuite。

Google开放其API接口

3月,Google推出PaLM-E,其拥有5620亿参数,是GPT-3的三倍多,号称史上最大规模视觉语言模型。

2月底,Meta突然公布了一款全新的AI大型语言模型LLaMA,宣称可帮助研究人员降低生成式AI工具可能带来的“偏见、有毒评论、产生错误信息的可能性”等问题。并且仅用约1/10的参数规模,实现了匹敌OpenAI GPT-3、DeepMind Chinchilla、谷歌PaLM等主流大模型的性能表现。

此前,百度高调官宣会在3月16日上线文心一言。

开放API接口、用更低的参数、用更高的参数……参与者们都在寻找更适合的角度,想要与OpenAI及其“爸爸”微软,正面竞争。

或许这也是OpenAI着急将GPT4推出的重要原因——你们还在围绕我的3.5比拼,而我已经跳到下一阶段了。这无疑能够帮助OpenAI依旧当仁不让成为“AI引领者”。

当下,由ChatGPT引发的系列讨论热度在持续升高,其中比较主流的讨论,集中在成本和模型规模两个维度。

一方面,在3月初,OpenAI以每1000个tokens0.002美元的价格开放了API接口,是原本价格的十分之一。如此低廉的价格,或许会将吸引绝大多数应用层伙伴,OpenAI得以建立自己的生态。而生态不仅是未来商业变现的根据地,更是反复强化训练的数据来源,因此,当GPT系列成本足够低时,将挤占其他互联网大厂的生态。

对于全球所有模型层的公司来说,都在思考还要不要继续做、怎么做才能让自己成本更低;对于所有应用层的公司来说,都希望可以以如此低的接入成本,成为不同领域的“Jaseper”。

另一方面,到底需不需要如此大的模型,也成为业内讨论的话题之一。不少人认为,如果能够实现相同的效果,用更大的模型训练就是浪费资源。

但此刻看来,必要不充分条件依旧成立:虽然模型不是越大越好,但是更好地效果实现,还是必须得有更大的模型。

此刻,OpenAI的GPT4再次甩开了自以为能够与其竞争的“竞争者们”。未来,OpenAI一定会以更低的价格继续开放更好的模型,那时AI格局或许已经不会再出现变化了。

明天,百度文心一言会上线,36氪也将继续关注。

相关链接:

5月,36氪将举办“颠覆AIGC”主题峰会返回搜狐,查看更多

责任编辑:

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!