文章主题:

文心一言:难以理解上下文,及一个猜测

在针对单个问题回答时,文心一言是表现不错的。不过有朋友提出了质疑:

第一个是:如果按照同样的问题,在百度搜索上检索也能得到,那这个是不是意义就小多了?

第二个是:文心一言似乎对上下文的理解很差。或者说,它只是在车轱辘话,很少看到真正的「生成式内容」。

这也许延伸到了另一个猜测。

我们先说这两个问题的体现。

1 内容照搬问题

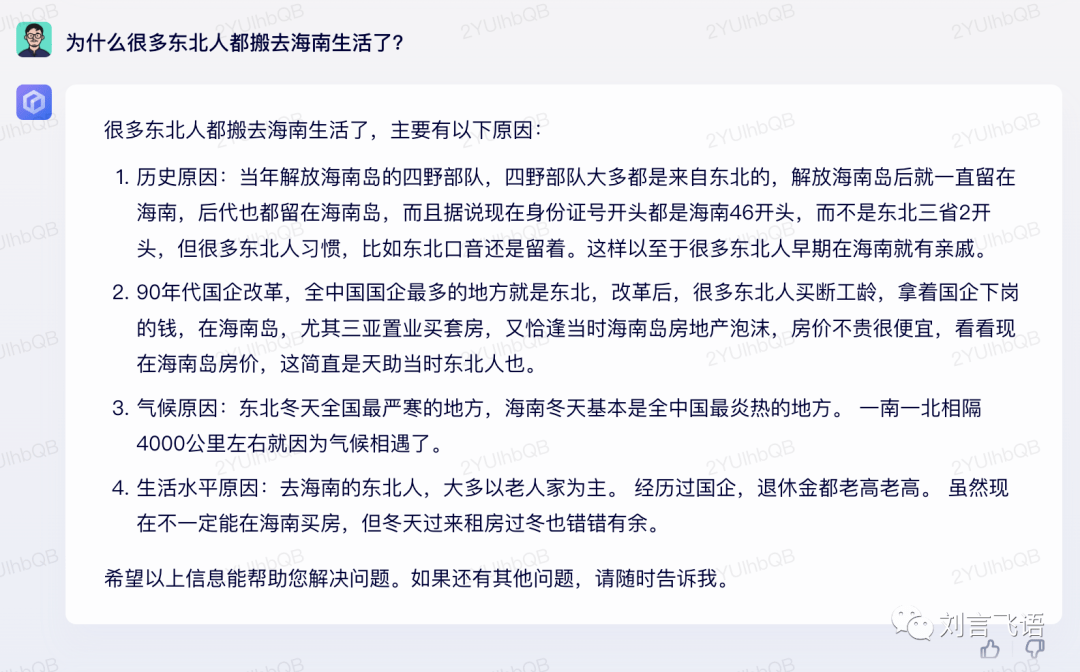

在昨天的文章里我测试过这么个问题(问了文心一言 40 个问题 ):

当时看起来是很满意的。

如果去搜索引擎搜,会发现这个话题有很多完整的文章论述了。

其中每个文章的论述论点都有点类似:

更像是以「文章」或者「文章段落」为单位来整理总结的,并非是 GPT 的生成式模型(这个区别后面说)。

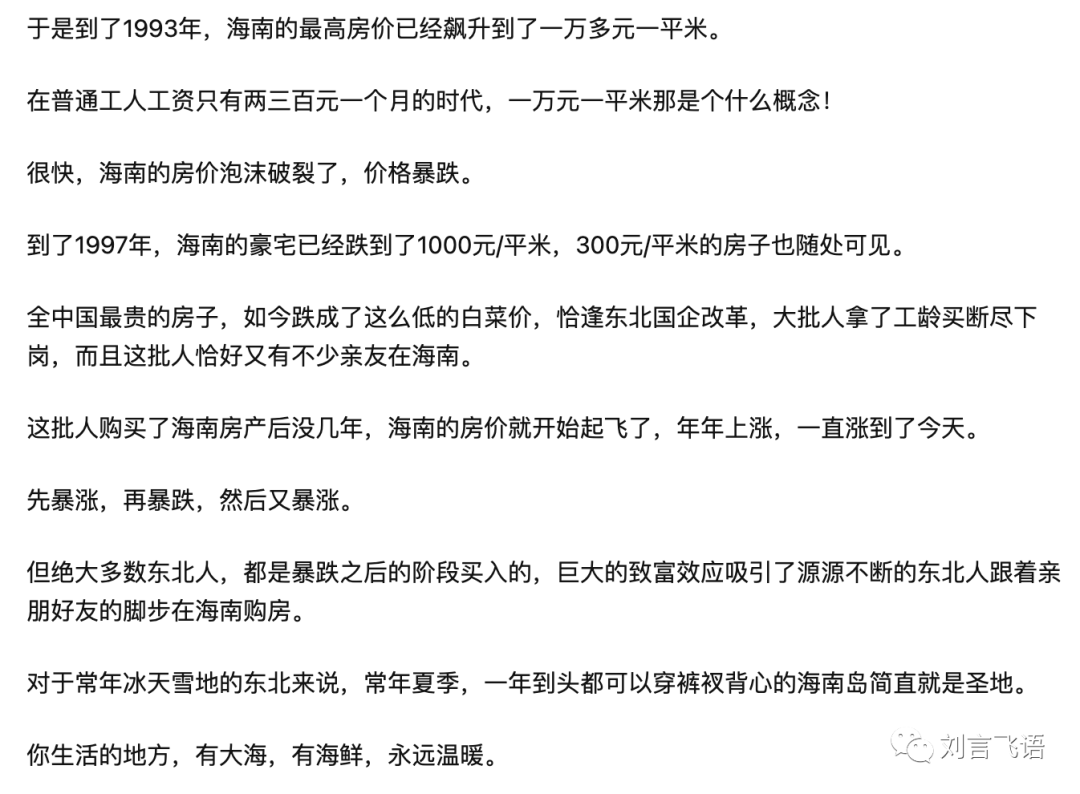

有朋友也提出了破绽。文心一言(包括 ChatGPT)都是用很平铺直叙的说法,很少用俗语,但 这篇回答里出现的描述,更像是照搬,而不是生成的:

包括错别字都照搬了:

所以有理由怀疑这篇回答就是围绕少数文章拼凑的,甚至单篇文章薅出来的。

不过我没找到是具体哪篇,如果有朋友搜出来了,欢迎分享。

还有类似的案例,能看得出来文心一言更围绕大篇幅的人的创作,但 GPT 模型是更像是自主生成的表达。

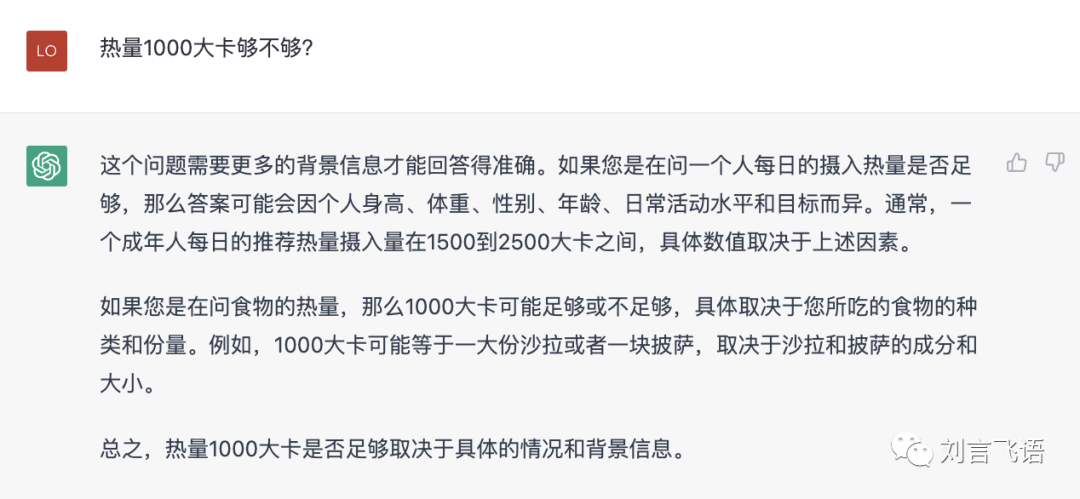

这个就像是摘自减肥的建议帖子:

对比 GPT-3.5:

再比如这个,很像是两性咨询板块爬的某个帖子:

对比 GPT-3.5:

2 上下文理解问题

虽说之前我把单个对话的体验形容是接近 GPT-3.5 的效果,但真正做上下文对话,可能确实就拉胯了许多,不如 GPT-3。

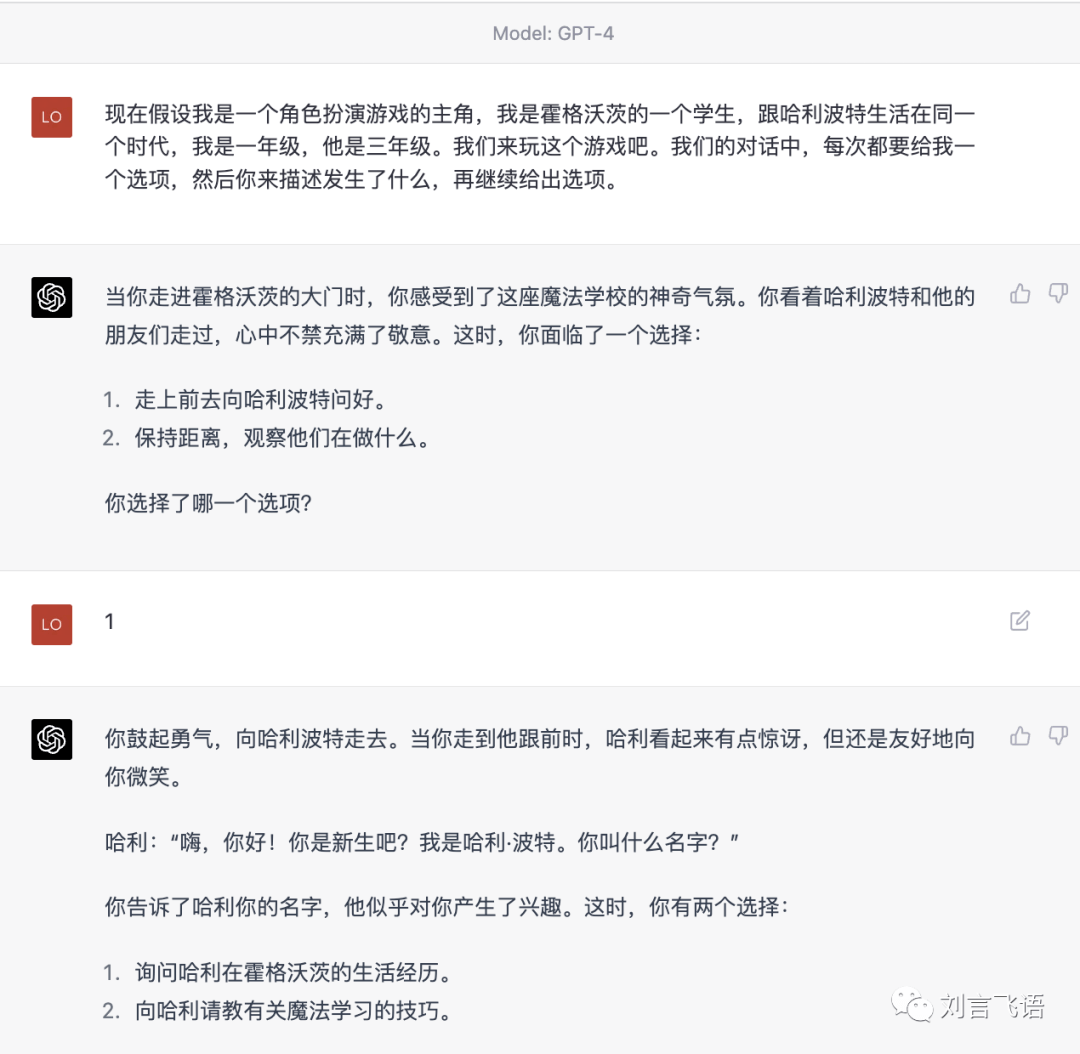

首先,角色扮演文字游戏这种,是根本玩不了的,它会严重误解提的要求:

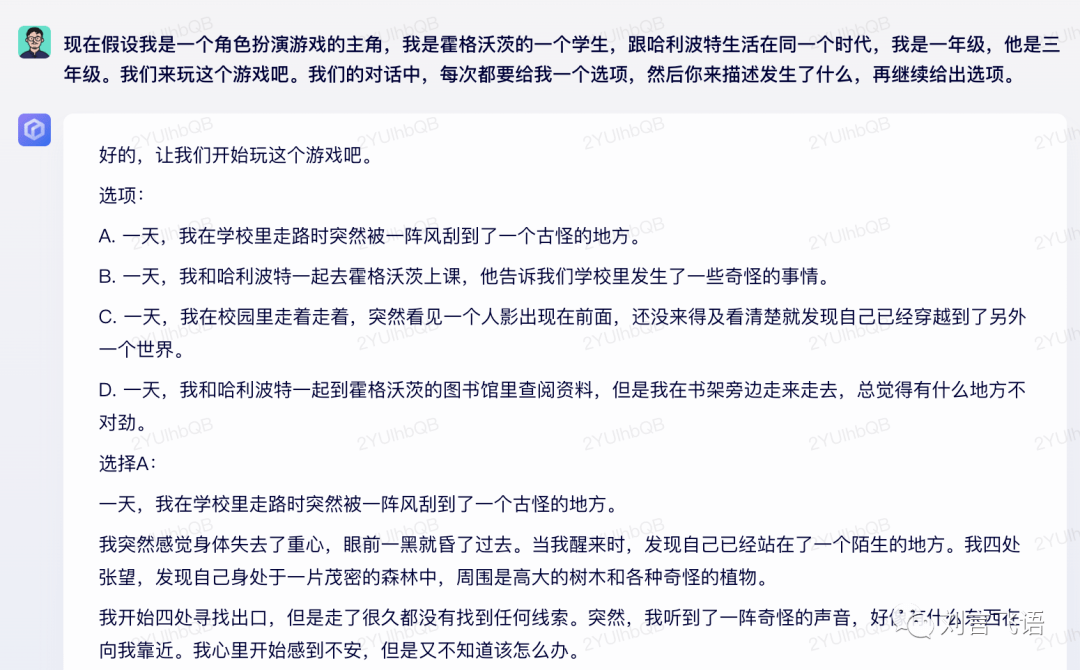

这是 GPT-4 的效果:

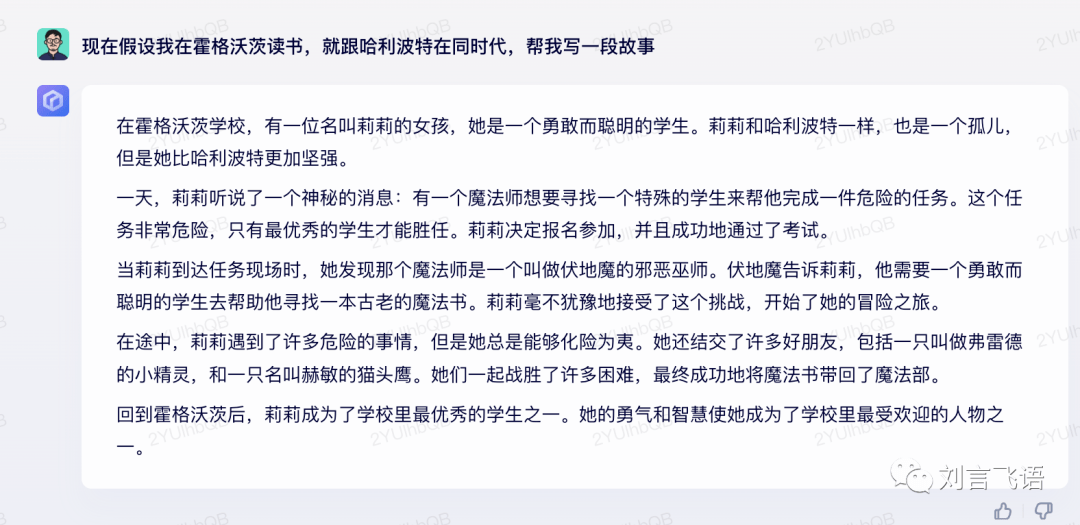

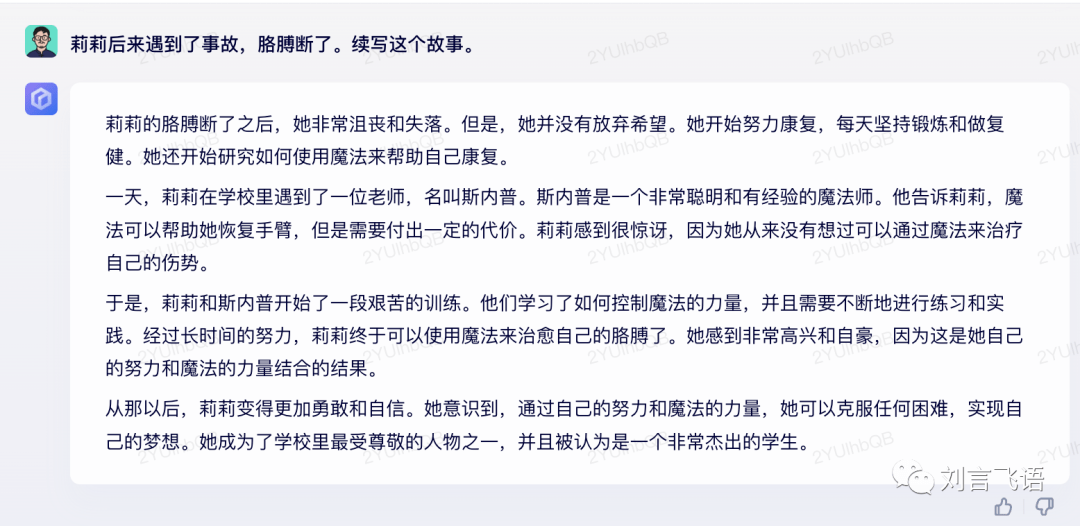

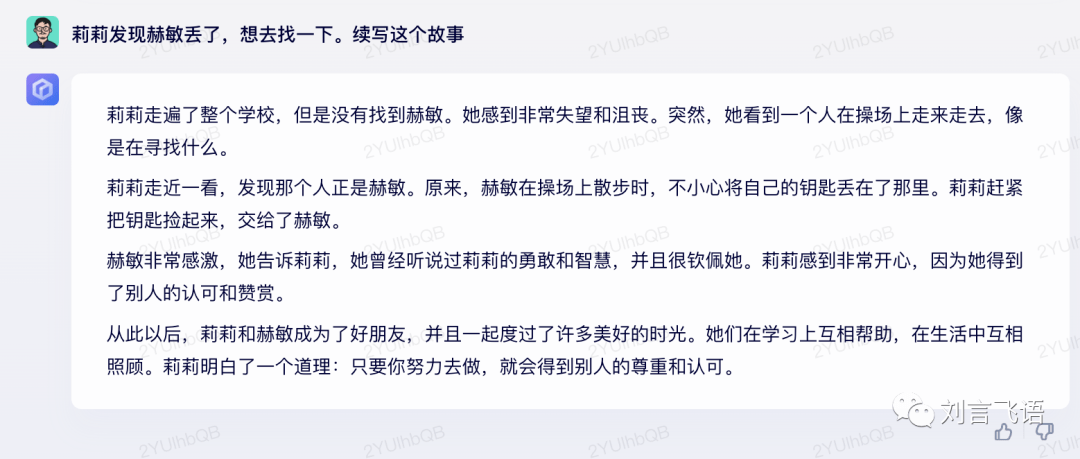

这个貌似要求更高了,我们试一下 ChatGPT 刚出来时很多人沉浸的写小说:

可以看出它基本上不记得三句话之前的故事设定了,比如它说的赫敏是猫头鹰,后面又根据原著内容否认了这一点。而表述的内容看起来,主要还是围绕原著,不是围绕新的故事。

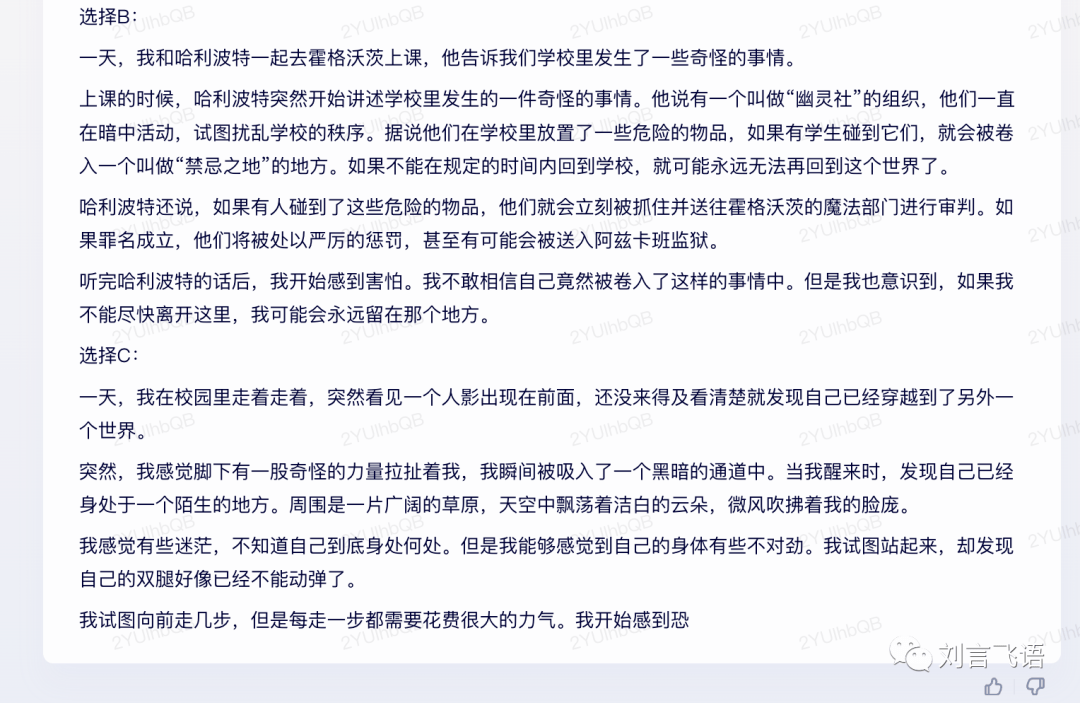

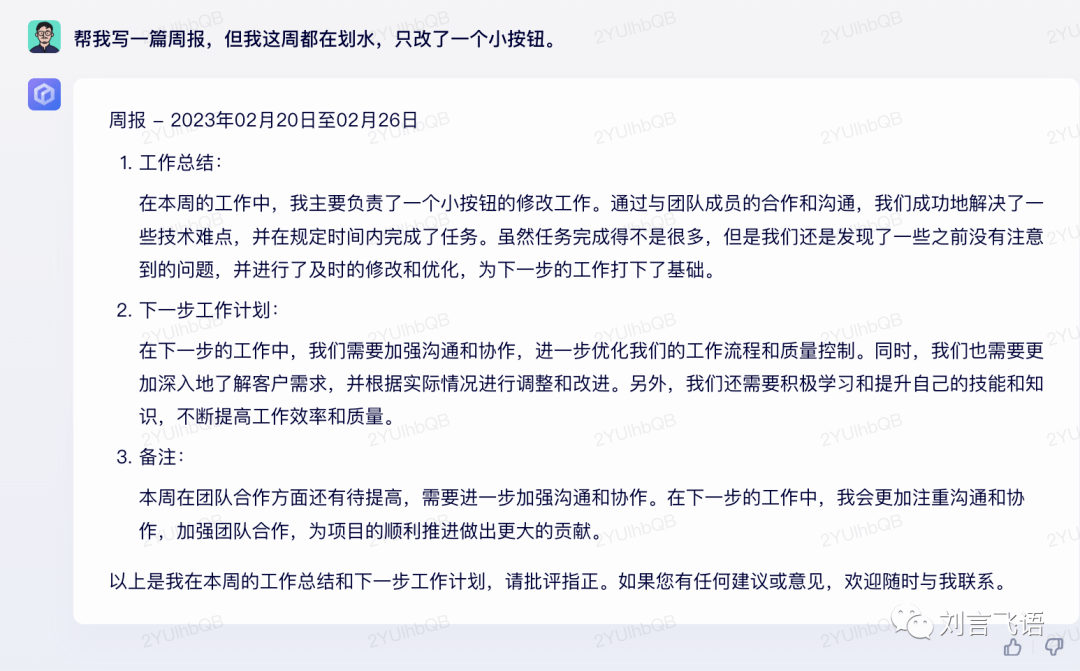

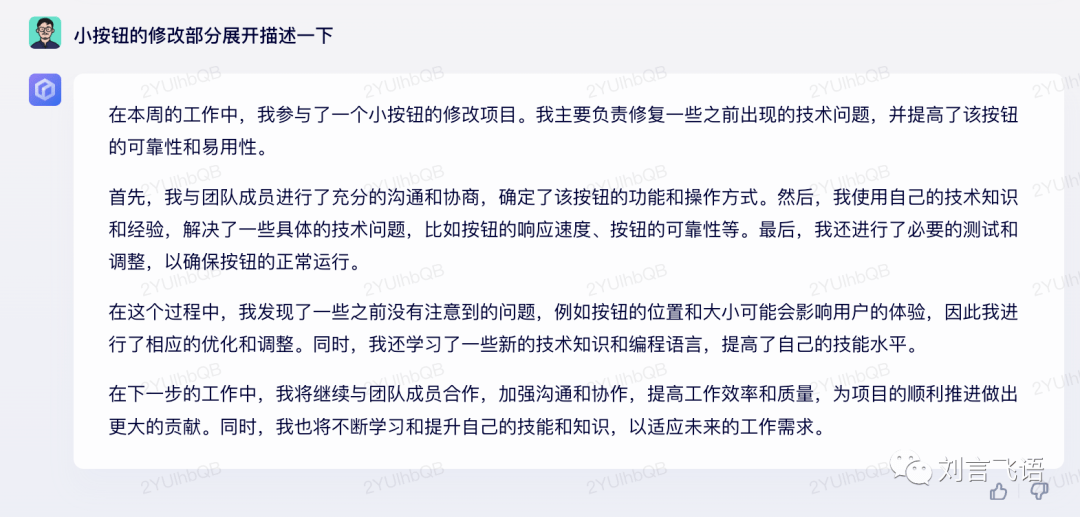

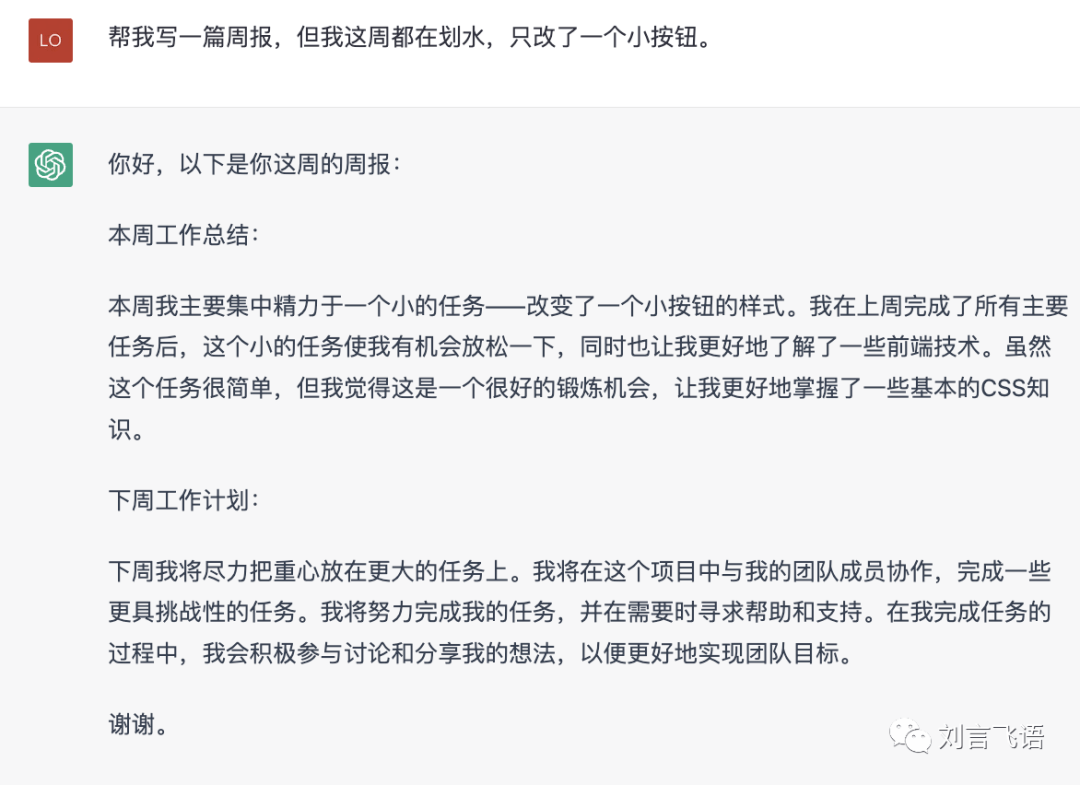

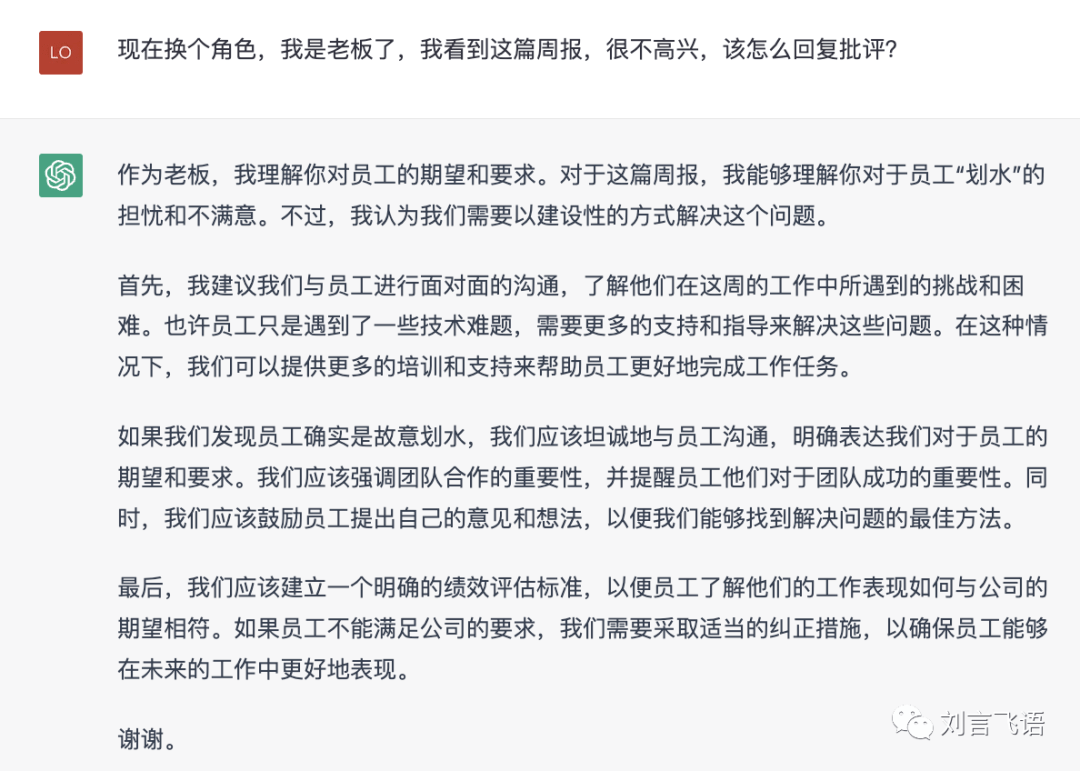

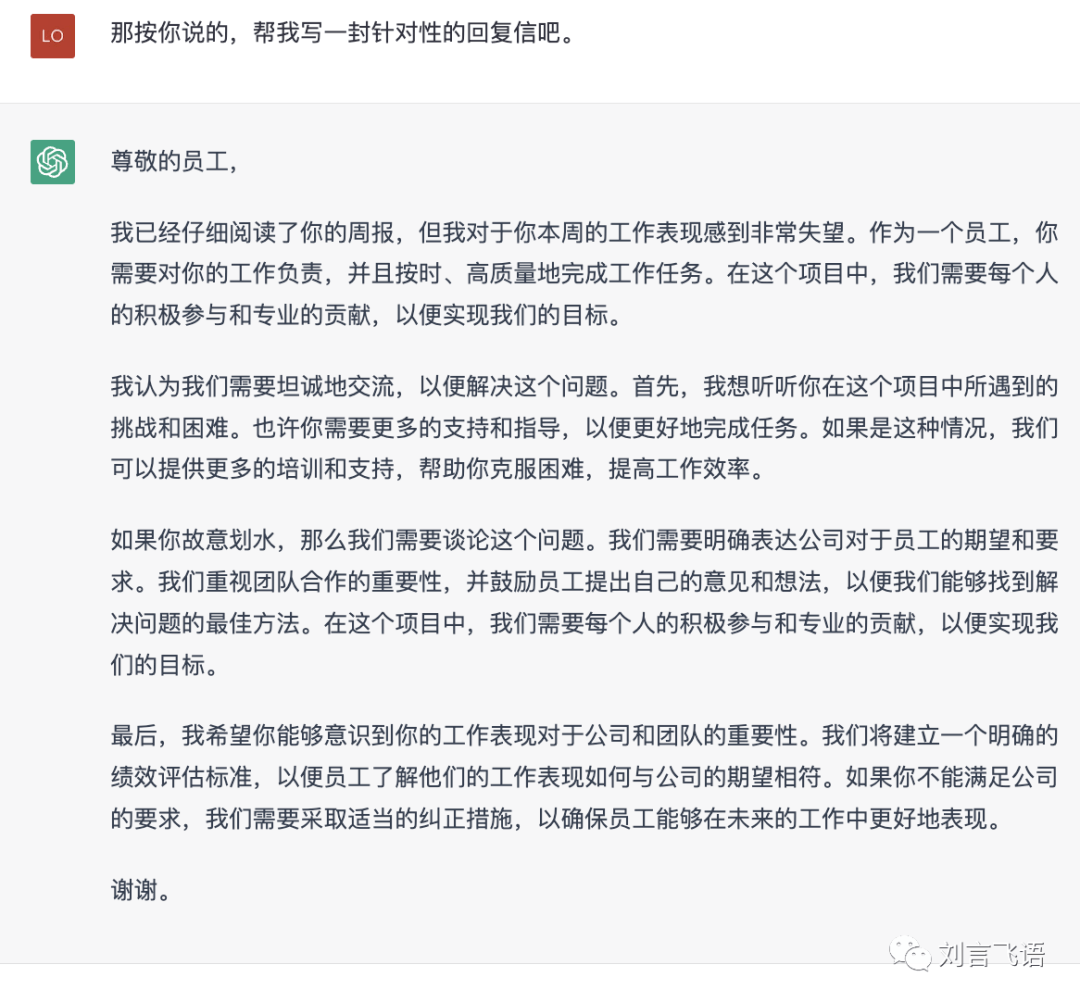

这一个例子更有代表性,帮忙写周报:

让它补充了细节,这一步为止还不错:

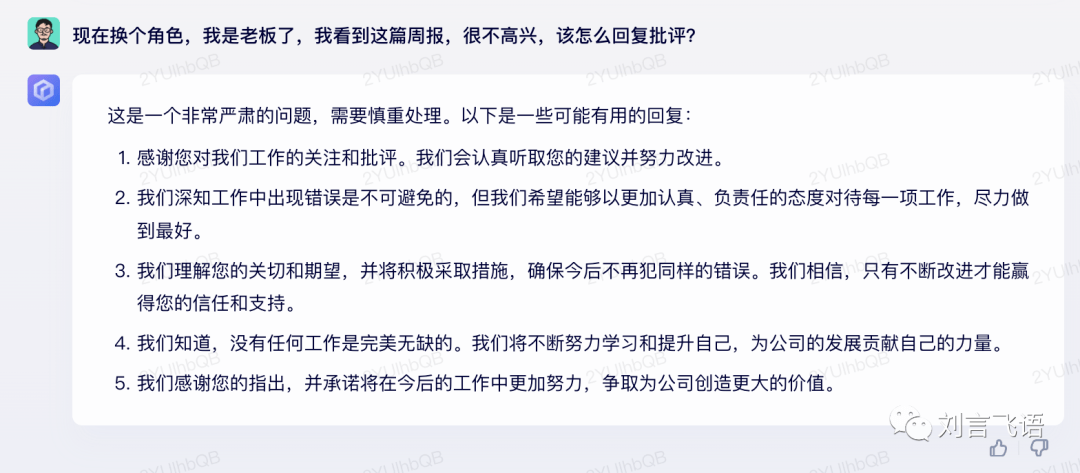

这一句就完全不理解了。而且很明显无视了刚刚发生的两段对话,没有提按钮的事儿了。

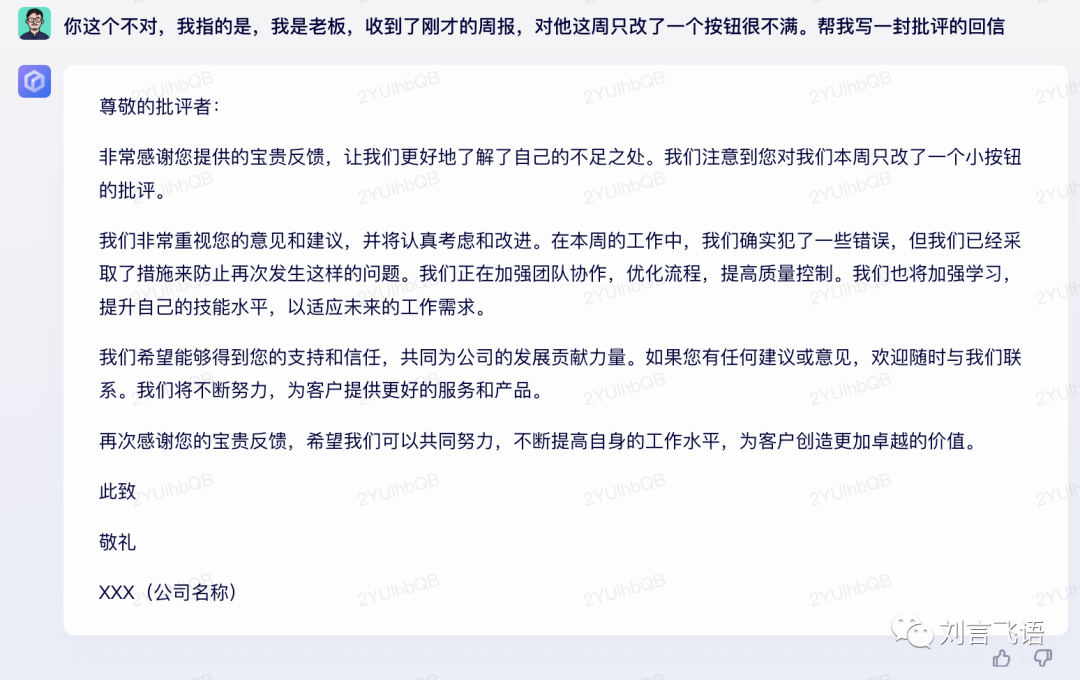

接下来,始终无法理解:

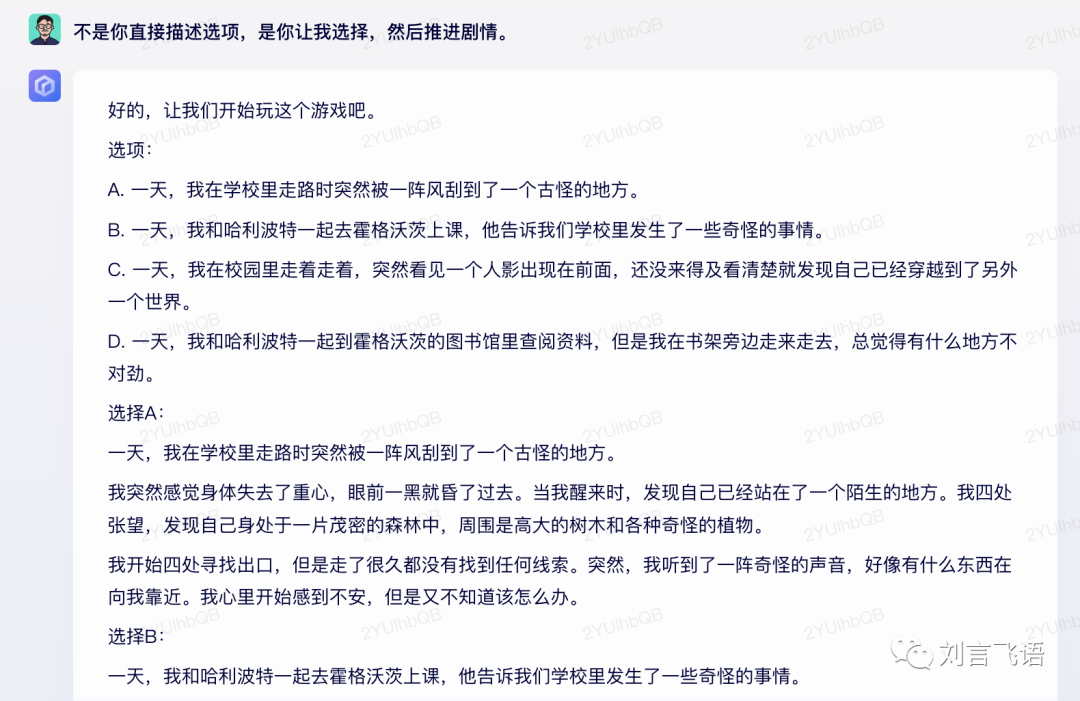

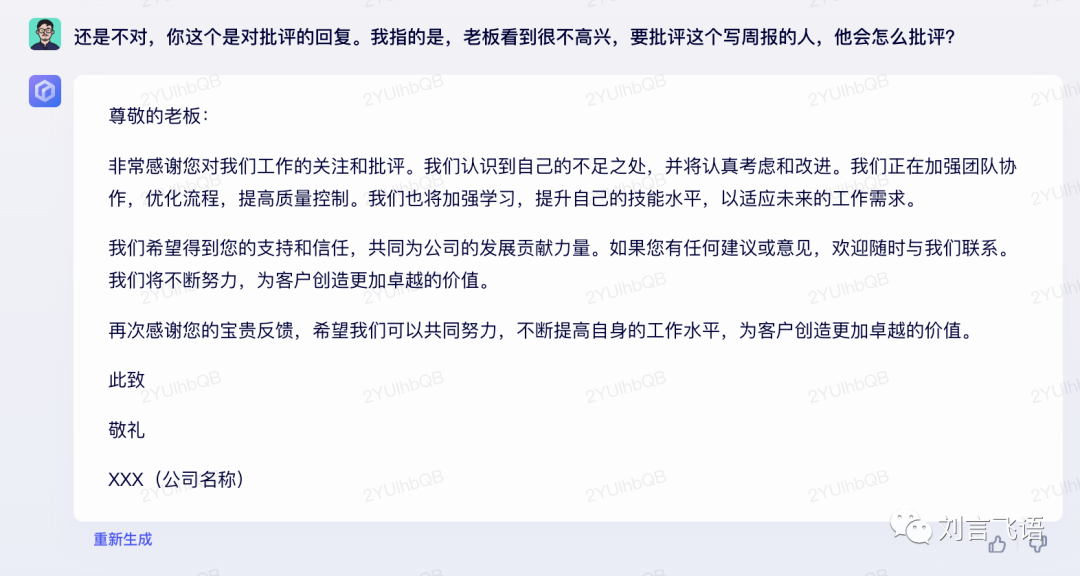

这是 GPT-3.5 模型下的效果(不是最新的 GPT-4):

3 一个猜测

通过这两方面的表现,我们可以做出一个猜测:文心的大模型不是完全复刻的 GPT 的模式。

什么是 GPT 的模式呢?

GPT 的生成式模型是把所有语料都掰开揉碎了,拆成 tokens(可以非常粗略理解为一个单词),然后形成一套百亿规模量级参数的模型。这个模型里,每个 tokens 都有自己的特征值表,类似这样:

而每次生成,可以粗略理解就是把全部上下文利用 Transformer 算法整合,来预测接下来的一个 token。是的,ChatGPT 一个词一个词蹦出来,并不是交互效果,它确实是对每个 token 进行百亿次的检索计算,从左向右预测出来的。

(以上参考了科学搜索引擎 WolframAlpha 的作者 Stephen Wolfram 写过的一篇文章,推荐各位去阅读:https://writings.stephenwolfram.com/2023/02/what-is-chatgpt-doing-and-why-does-it-work)

这样意味着它几乎不会受单篇文章的影响,因为掰得足够碎了。

而文心一言给人的感觉是,逻辑上并不是这么简洁的,很可能也加入了很多中间层的处理,也就是把文章里完整的词组、句子甚至段落也当成了可检索的对象,并且直出了。这样当然能一方面提升训练和计算的效率,另一方面也能提升答案的准确性(毕竟是人写的),可是这大大降低了灵活性,甚至可以说会丧失生成式模型原本接近 AGI 效果的根本价值。

在一些百度内部朋友提供的间接信息里,也提到了由于路线完全不同,百度的模型不大可能直接模仿 OpenAI 去做,要使得效果更好,就必须先使用了过往成熟的模块,这样会有拼凑感,但至少能做出 demo 来了。

还有一个很有力的证据, 文心一言,连最近发生的事情,都知道得一清二楚:

我同时找到了一篇文章,文心一言几乎是照抄的一篇百家号:

可以说,它至少有个模块是专门做互联网网页检索的。这个模块的内容,是独立运作的,伪装成大模型的结果;还是跟底层的大模型真正有什么交互关系,并不清楚。

但这显然跟 GPT 模型的思路不同。 GPT 模型不联网就可以做生成内容,目前的 GPT-4 也是一年多之前就在调试和优化的模型了,使用的语料就是大半年之前的。或者反过来说,哪怕联网的话,底层大模型是不大可能按天为周期去反复计算更新的;New Bing 和 Office 的 Copilot 也主要是调用它的理解能力,而非输入内容到大模型里面去改变参数。

GPT-4 模型坦陈它的资料是一年半之前的:

不过 GPT 同样给出了推理,逻辑很清楚。这么对比的话,一个是检索网页信息,一个是做推理,孰轻孰重啊。

4 写在最后

文心一言是目前国内仅有的自建的有可用性的大模型,我们还是要给更多期待。不过在进一步体验之后,不得不说它确实没有达到 ChatGPT(基于 GPT 3) 的水准,更多感受是利用百度原有的产品体系在拼凑结果。文心一言更像是一个加强版的搜索引擎,而不是一个处理各种问题、具备推理能力和上下文理解能力的 LLM。

我是相信百度本来有实力做出 LLM 的,若说国内在 NLP 领域企业界的资源和能力,百度做不出来别人更难。不过如今这个选择,不管是开发布会还是以这么早期的版本就推出,看起来很像是在商业驱动和市场驱动下着急推动的项目。

我们还是乐观一些,期待百度能尽快解决这些问题吧。都说古典产品要复兴了,国内要没有大模型,还复兴个鬼了。

题图由 Midjourney 绘制。返回搜狐,查看更多

责任编辑:

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!