文章主题:

整理 | 苏宓

ChatGPT这类大型模型的研发确实堪称行业巨头间的较量,背后所蕴含的技术与资源投入不容小觑。它不仅依赖于庞大的计算能力,更是对雄厚财力的考验。这不仅是技术实力的比拼,也是创新和市场战略的竞赛。

那么,加入这场战局,究竟要花费多少钱?

🌟【揭秘ChatGPT背后】💡技术巨头的携手与巨额开销的秘密🔍ChatGPT的热度飙升,背后的运营成本却让人咋舌——每天高达数十万美元的巨额开支!每月仅此一项费用就接近300万金元,这样的数字对于科技界来说无疑是天文级别。👀据Techcrunch透露的细节,这笔高昂的成本并非偶然,而是OpenAI在探索人工智能道路上的不凡决心和创新追求所付出的代价。💡他们与微软的合作,正是在这种经济压力下寻求突破的关键一步。.capitalize这样的合作模式揭示了科技巨头对AI研发的重视程度,以及为了推动行业进步愿意承担的经济责任。💰同时,这也提醒我们,每项技术革新背后都伴随着巨大的投入和挑战。ChatGPT的成功,无疑是对人工智能未来潜力的最佳注解,而其背后的巨额成本,更彰显了科技进步的艰辛与辉煌。🚀#ChatGPT成本揭秘 #科技巨头合作 #人工智能探索

🎉【揭秘AI大模型背后的巨额成本】🚀你是否好奇,那些无所不能的大模型背后隐藏着怎样的经济秘密?🔍 一直以来,关于AI大模型的高额运营费用,坊间虽流传颇广,但却鲜有确凿数据来证实。💡 然而,真相往往藏在细节中——它们的成本究竟高到何种地步呢?想象一下,每一台强大的智能引擎背后,都是一场无声的经济战役。💰 数以亿计的算力资源、复杂的数据处理流程和高昂的研发投入,共同铸就了这些技术巨头的巨额开销。💻尽管AI领域的透明度相对较低,但我们可以推测,这种高成本并非偶然,而是科技进步与市场需求双重驱动的结果。📈 随着技术的进步和社会对智能化服务的依赖加深,这个数字只会继续攀升。对于那些对AI感兴趣,却又担心成本的企业和个人来说,了解这些背后的真相,无疑是一次深入行业理解的好机会。🎓让我们一起期待,未来AI大模型能以更亲民的价格,为更多用户提供高效、智能的服务。🌍记得关注我们,获取更多关于AI领域的深度解析和最新动态!👇#AI成本揭秘 #技术经济战 #智能化未来

Microsoft recently made headlines with a pair of blog posts, shedding light on its ambitious investment in Azure and the groundbreaking journey it’s embarked on to revolutionize AI. The tech giant revealed the complexities involved in building infrastructure for OpenAI’s ChatGPT, while simultaneously highlighting the significant strides made. By connecting thousands of NVIDIA A100 GPUs and revamping their service architecture, Microsoft has enabled OpenAI to train increasingly powerful AI models, fostering innovation in the process.Notably, this ambitious project has come at a substantial cost, with estimates suggesting billions of dollars invested by the company. This move not only bolsters OpenAI’s capabilities but also paves the way for enhanced AI features in Bing and Edge, further solidifying Microsoft’s position as a leader in the tech landscape. 🚀💻💰

01

投资数亿,微软回忆与 OpenAI 合作往事

🎉五年光阴荏苒,OpenAI曾向🌟微软抛出震撼设想——引领一场翻天覆地的人机交互革命!💡彼时,他们构想了一款卓越的AI,旨在打破传统,重塑未来互动模式。🌍这一创新理念,犹如一股清流,冲击着科技界的认知边界。

🌟Microsoft and many others were clueless back then, unaware that the advent of AI would revolutionize 📡communication with a chatbot capable of crafting sentences,起草 emails, and even 🗨️planning itineraries and menus using minimal cues. This groundbreaking development was a game-changer in the realm of digital assistance. 💻✨

为了实现它,OpenAI 需要真正大规模的计算能力的支持。

但是在 OpenAI 向微软提出想法时,微软也迷茫了,甚至发出“微软能做到吗?”的疑问。

虽说微软过去多年以来一直在努力开发人工智能模型,使用更强大的 GPU 来处理更复杂的人工智能工作负载,也发现大模型的潜力,但在这过程中,他们也清楚的明白大型模型备受现有计算资源限制的困扰。

微软 Azure 高性能计算和人工智能产品负责人 Nidhi Chappell 对此表示:”我们从研究中了解到的一件事是,模型越大,你拥有的数据越多,你能训练的时间越长,模型的准确性就越好。”

所以,想要大力推动让更大的模型训练更长的时间,这意味着你不仅需要拥有强大的基础设施,你还必须能够长期可靠地运行它。

可以说,这是 OpenAI 对 AI 模型的一次巨大尝试,也是微软对自家 Azure 服务的一次勇敢押注。

在 2019 年,微软和 OpenAI 开始建立了合作关系。”我们建立了一个系统架构,可以在非常大的规模下运行和可靠。这就是 ChatGPT 成为可能的原因,”微软 Azure AI 基础设施总经理 Nidhi Chappell 分享道,”这就是其中的一个模型。将会有很多很多其他的模式。”

当时,微软开发了一套新的 Azure 人工智能超级计算技术,也在 Azure 中建立超级计算资源,这些资源的设计和专用性使 OpenAI 能够训练一套日益强大的 AI 模型。

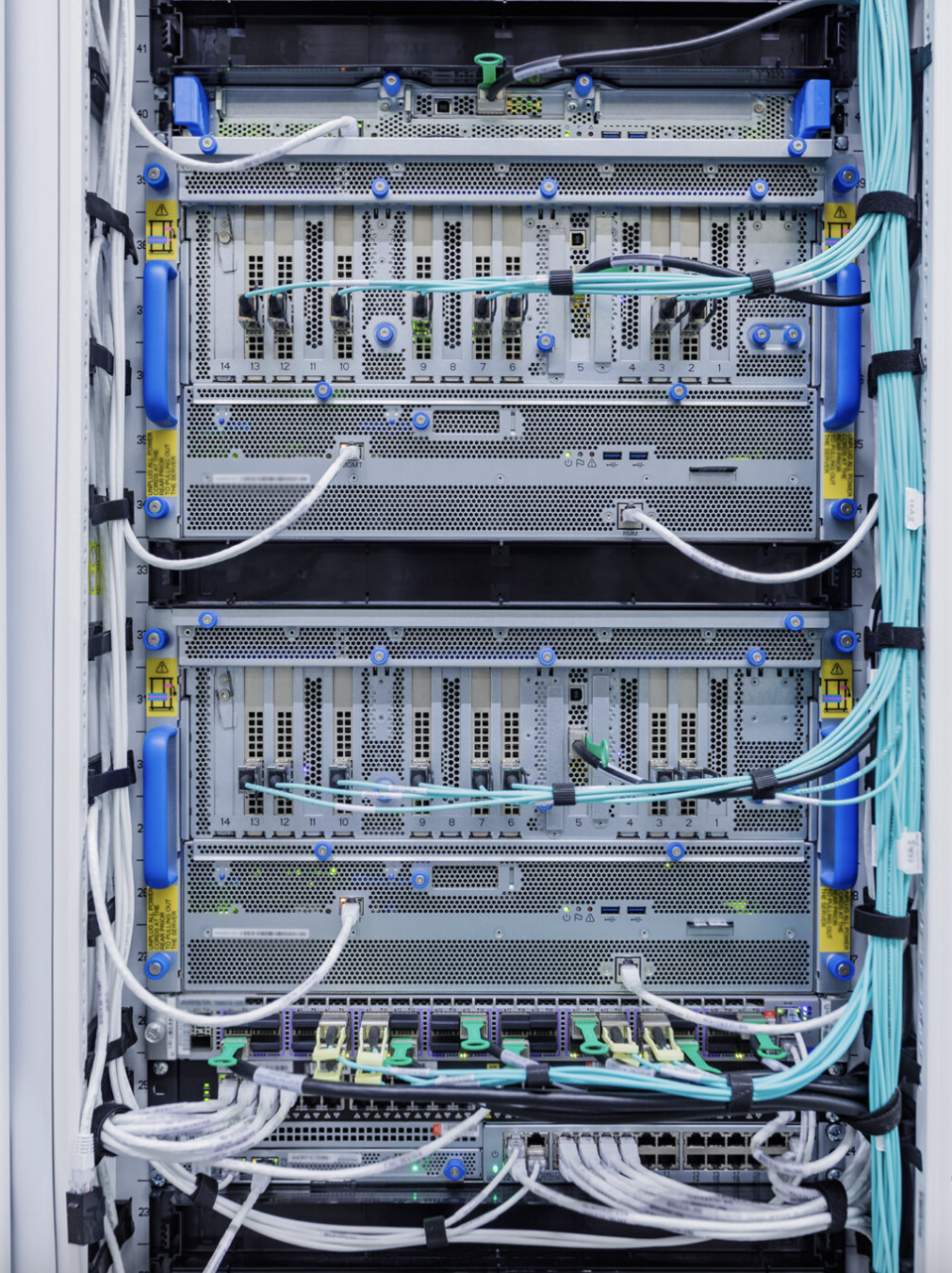

为了训练出这套模型,微软在基础设施中使用了数以千计的英伟达人工智能优化 GPU,它们被连接在一个高吞吐量、低延迟的网络中,该网络基于英伟达量子 InfiniBand 通信,用于高性能计算。

对此,促成微软和 OpenAI 合作的关键人物——负责战略合作伙伴关系的微软高级主管 Phil Waymouth 表示,OpenAI 训练其模型所需的云计算基础设施的规模是前所未有的,比业内任何人试图建立的网络 GPU 集群都要大得多。

据彭博社报道,微软在该项目上已经花费了数亿美元。

要问这个钱花得值不得,现在无论是微软,还是业界同行,给出的答案必然是肯定的。因为去年 11 月 ChatGPT 上线仅 5 天用户量就突破了 100 万;微软上线 ChatGPT 版本 Bing 短短一段时间后日活跃用户首次破亿;微软逐步将蕴藏着巨大的商业价值 ChatGPT 引入自家的服务线中,给亚马逊、Google 等公司也带来了巨大的压力。

02

大规模的 AI 训练

当然微软押宝成功这些都是后话了,对于当时的微软而言,是一场摸着石头过河的未知探索之旅。相比现在可能看到的商业价值,那时的他们可谓是眼前一抹黑。

彼时的微软没有 OpenAI 所需要的东西,也不完全确定是否能在其 Azure 云服务中建造这么大的东西而不至于崩溃。

微软 Azure 高性能计算和人工智能产品负责人 Nidhi Chappell 称,这些突破的关键是学习如何在高吞吐量、低延迟的 InfiniBand 网络上构建、运行和维护数以万计共处一地的 GPU,并相互连接。

她解释说,这种规模甚至超过了 GPU 和网络设备供应商曾经测试过的规模。这是一个未知的领域。没有人确定硬件是否可以在这么大规模下运行,而不损坏。

为了训练一个大型语言模型,计算工作负载被划分到一个集群中的数千个 GPU 上。在这个计算的某些阶段(称之为 Allreduce),GPU 交换它们所做工作的信息。一个 InfiniBand 网络加速了这一阶段,在 GPU 开始下一块计算之前必须完成。

“由于这些工作跨越了数千个 GPU,你需要确保你有可靠的基础设施,然后也需要在后端拥有网络,这样你就可以更快地进行通信,并能够连续数周这样做”,Chappell 说道,“这不是你买了一大堆 GPU,把它们连在一起,就可以开始工作的。为了获得最佳的性能,需要有很多系统级的优化,而这是经过许多代人的经验总结出来的。”

系统级优化也包括能够有效利用 GPU 和网络设备的软件。

在过去的几年里,微软已经开发了这样的软件技术,提高了使用数十万亿个参数训练模型的能力,同时降低了训练和在生产中提供这些模型的资源要求和时间。

“微软及其合作伙伴也一直在逐步增加 GPU 集群的容量,增加 InfiniBand 网络,并看看他们能把保持 GPU 集群运行所需的数据中心基础设施推到什么程度,包括冷却系统、不间断电源系统和备用发电机”,Waymouth 在官方博文中写道。

今天,这种为大型语言模型训练而优化的 Azure 基础设施可以通过 Azure AI 超级计算能力获得,微软公司负责 AI 平台的副总裁 Eric Boyd 分享道。该资源提供了 GPU、网络硬件和虚拟化软件的组合,以提供推动下一波 AI 创新所需的计算。

03

英伟达才是背后的赢家?

随着基础设施的到位,微软现在正向其他人开放其硬件。为此,微软在另一篇博文中宣布加强和英伟达的合作,推出了使用英伟达 H100 和 A100 Tensor Core GPU 以及 Quantum-2 InfiniBand 网络的新虚拟机,其中最新推出的 ND H100 v5 VM,它支持按需大小不等的 8 到数千个 NVIDIA H100 GPU,这些 GPU 通过 NVIDIA Quantum-2 InfiniBand 网络互连。

据微软透露,这应该允许 OpenAI 和其他依赖 Azure 的公司训练出更大、更复杂的 AI 模型。

至此,也有不少人发现并调侃道,英伟达似乎成为了这场 AI 浪潮中最大的赢家。因为过去微软与 OpenAI 的合作创立的基础设施所投入的资金,大部分都进入了英伟达的口袋。

话说如此,但他们也都为 AI 的发展做出了重要贡献。在 3 月 16 日,微软将分享其在人工智能方面的下一步最新进展,而英伟达也即将在 GTC 大会期间透露更多关于未来 AI 产品的信息。(作者:苏宓 ,CSDN)

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!