大模型之战:参数爆炸背后的效率之争,谁能在AI竞赛中快一步?

文章主题:网络, 高铁, 快速

文|MetaPost

“人类永远不会嫌网络太快,就像永远不会嫌高铁太快,你只会嫌它慢,希望它更快些。”

🎉🚀中国AI巨轮加速!国内大厂集体发力,从百度到阿里,腾讯、商汤、讯飞、360等一众巨头纷纷推出自家的”GPT”版本,瞬间点燃了AI领域的战火🔥。尽管ChatGPT已成行业标杆,但我们的国产模型并未止步,创新的步伐持续迈进。虽然短期内差距明显,但这股热情和紧迫感已经不容忽视。\nalready!企业们开始意识到,错过AI这班车,后果将不堪设想。每个人都期待,中国版的”GPT”能早日崭露头角,引领行业发展,为未来的科技竞赛注入强劲动力💪。SEO优化提示:使用行业术语如”AI巨轮”、”GPT版本”、”创新步伐”、”科技竞赛”等,同时融入相关技术关键词如”自然语言处理”、”人工智能”以提升搜索引擎排名。

以 GPT 系列模型为代表的大语言模型成为近来最受关注的技术之一。

图 | OpenAI-ChatGPT

ChatGPT 凭什么落别人那么远?

🌟🚀AI进步的显著标志在于模型规模的不断膨胀!从OpenAI的GPT-1的50亿参数起步,飞跃至GPT-3.5的1750亿,直至引人瞩目的GPT-4预计超T级参数,参数量的增长速度简直令人惊叹。这种指数级的扩张,对计算资源的要求直线上升——海量数据训练、高效数据处理,以及数据中心的超强算力与GPU/CPU协同,都是不可或缺的挑战。网络带宽更是关键,它决定了大语言模型卓越性能的实现。🚀🌟

🌟整体效能是大模型行动与学习的关键要素,它直接影响着模型的运行速度和训练周期。就像一场马拉松,耗时6个月的大模型可能仅能进行两次强化训练,而那些2-3月就能快速跑完的,一年内可反复训练多次。这直接决定了AI进步的步伐,🚀每个迭代周期的成果都会产生显著差异。

图 | NVIDIA

🌟随着AI技术的飞速发展,越来越多的企业认识到它在优化业务流程及提升客户服务方面的潜力,纷纷投身于自家产品创新的浪潮中。然而,随之而来的是一个不容忽视的问题——如何在众多模型的竞争中脱颖而出,避免陷入吞吐量与性能的瓶颈?🚀训练如此规模庞大的语言模型,所需的资源投入是巨大的,这已成为许多企业的挑战。💡要想在这个AI竞技场中保持领先地位,企业不仅需要创新思维,更需精准策略,以实现技术与成本的有效平衡。🎯值得注意的是,市场竞争并非零和游戏,而是推动大家共同进步的催化剂。通过合作与共享,企业可以降低研发门槛,优化资源分配,从而在AI领域实现共赢。🤝在这个AI新时代,每个参与者都应审时度势,既要抓住机遇,也要明智应对挑战,以确保在AI浪潮中稳健前行。🚀

图 | NVIDIA

🌟大数据与绿色能源:AI数据中心的庞然大物与全球电力消耗的秘密🔍💡电力限制是制约大型模型训练的一大瓶颈——数据中心功耗堪称电力巨兽,且增长速度惊人!据统计,仅一年间,数据中心就消耗了惊人的200 TWh(相当于2000亿度电),占全球电力使用总量的2%。👀想象一下,三峡水电站两年的发电量才够这些数据中心一年用!🔍这样的电力消耗量不容小觑——它相当于三峡电站整整两年的产出!随着AI技术的发展和数据中心的扩张,预计到2030年,这一数字将飙升至全球电力使用预测的5%,对能源平衡、环保及碳排放构成严峻挑战。🌍🔥面对如此庞大的能源需求,绿色转型与技术创新成为关键。数据中心行业需寻求更高效能的解决方案,同时推动可再生能源的应用,以减轻对传统化石燃料的压力。让我们携手应对这一未来挑战,为可持续发展注入绿色动力!🌱

🏆在AI竞技场上,策略有两种路径:🌟一是豪华配置的”堆料模式”,就像赛车制造,后进者需耗费更多不菲的资金来抢占市场份额;🌍二是精明高效的”速度竞赛”,快速取胜的关键在于提升效能,而这正是DPU所助力的革新力量。🚀

微软此前发布的博客透露了 OpenAI 的 ChatGPT 采用的硬件是基于 NVIDIA 智能网卡和 InfiniBand 200G 网络所做的产品,未来也有意部署 DPU 。

图 | 微软官博

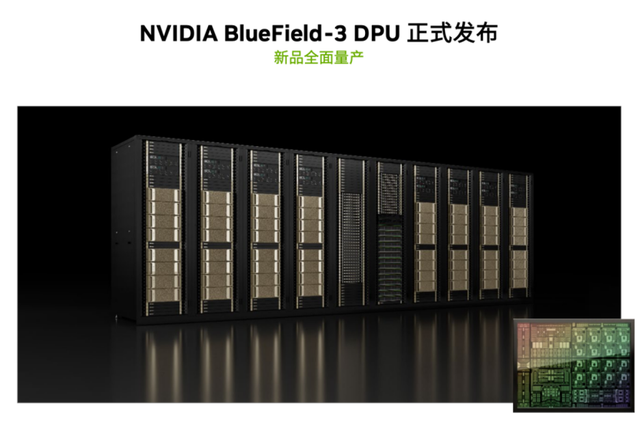

而为了应对 AI 模型训练、推理带来的需求和挑战, NVIDIA 近日发布了其最新一代数据处理器 BlueField-3 DPU ,并宣布全面量产。

图 | NVIDIA

NVIDIA 创始人兼首席执行官黄仁勋表示, AI 时代需要云数据中心基础设施来支持非凡的计算需求。“ NVIDIA BlueField-3 DPU 实现了这一进步,将传统的云计算环境转变为加速、节能和安全的基础设施,以处理生成 AI 的苛刻工作负载。”

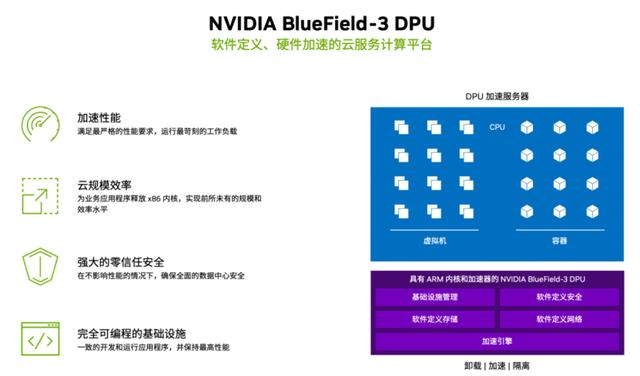

据 NVIDIA 介绍, BlueField-3 DPU 是一款专为数据中心设计的、软件定义、硬件加速的云服务计算平台。它集成了高达16个计算核心,可提供高达400Gbp/s的网络带宽,并且支持多种协议和功能,包括网络虚拟化、弹性负载均衡、数据中心互连等。 BlueField-3 DPU 还拥有世界领先的存储加速功能,可提供高达1.6Tbp/s的存储带宽,并支持 NVMe-over-Fabric 和 RDMA 等高性能存储协议。

大语言模型背后的硬件构成是怎样的?各家都不同。以 NVIDA DGX 为参照,支持大语言模型的服务器由8颗 NVIDIA 高性能 GPU 、4个 NVIDIA NVSWITCHES 、2颗x86 CPU、9块 NVIDIA BlueField-3 DPU 、2T DDR5内存、PCIe Gen5.0,以及服务器间的 NVIDIA Quantum-2 InfiniBand 网络构成。

其中 NVIDIA BlueField-3 DPU 发挥了怎样的作用?首先是加速性能:NVIDIA BlueField-3 DPU 具有丰富的硬件加速器,可以满足大语言模型严格的性能要求,并运行苛刻的工作负载;其次,云规模效率:NVIDIA BlueField-3 DPU 可以释放 CPU 核心,使大语言模型应用具有更好的性能和可扩展性,提升服务器的效率和能效,降本增效;第三是强大的零信任安全:安全的基础设施都可以运行在 NVIDIA BlueField-3 DPU 之上,并基于此构建零信任安全模型,在不影响性能的情况下,确保数据中心安全;第四是完全可编程的基础设施:NVIDIA DOCA 2.0 体现了 NVIDIA BlueField-3 DPU 的软件可编程性,借助 NVIDIA BlueField-3 DPU 可以获得完全可编程的加速数据中心平台。

图 | NVIDIA

简单地说,NVIDIA BlueField-3 DPU 可以提升整个网络性能,配合高算力 GPU ,可以支撑更大规模的大语言模型训练,从而缩短训练时间。根据模型需求动态调整部署以共享算力资源,并应对不同规模的模型训练;提升服务器能效、释放算力资源,用更少的服务器完成更多的任务,从而帮助企业实现节能环保、降本增效。

据 NVIDIA 介绍,大语言模型和生成式AI主要会构建在云基础设施之上,以云服务的方式服务于市场,因此,DPU 会主要应用于云服务提供商、AI 技术公司以及采用 AI 技术的企业。据悉,NVIDIA BlueField-3 DPU 已经在部分国内公有云服务提供商进行测试,后续会逐步开始采用。

在不久前的 GTC 2023 大会上,NVIDIA 创始人兼首席执行官黄仁勋先生坚定表示“ AI 迎来了‘ iPhone 时刻’”,回想当年苹果手机刚问世,当时的用户还都想着手机不就是用来打电话、发短信的?而今天,我们几乎已经遗忘了当时的想法和其他手机。同样,你会发现生活将慢慢被 AI 改变。

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!