文章主题:AI, 摘要生成, GPT-3

博雯 发自 凹非寺

量子位 报道 | 公众号 QbitAI

现在,AI能帮你200字看完一段12万词的长篇小说了!

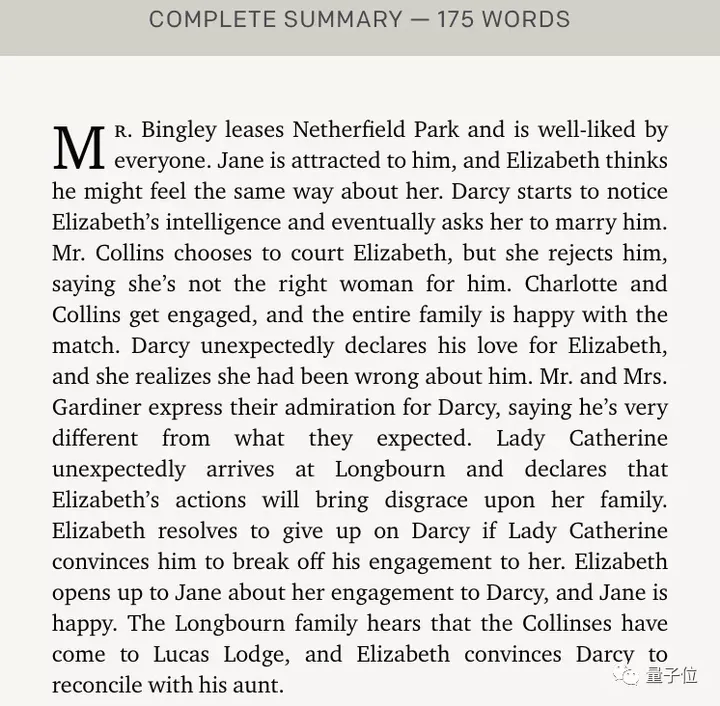

比如这样一段121567词的《傲慢与偏见》原文:

△图源OpenAI官网

AI分四个阶段来总结:

🌟文章精简大法🌟1. 📝提取精华,浓缩版概要🚀 – 从24,796字的长篇巨著中提炼出关键思想,创建276摘要,每段都是金句!平均每摘要约100词,便于快速浏览和理解。2. 🚀摘要风暴,3272字精华🌟 – 精简版,将276摘要压缩至25个,浓缩的智慧,只需轻轻一扫,3272字带你领略全局。3. 💼高效阅读,475字摘要精华💼 – 深入浅出,4个摘要聚焦要点,每段仅475词,深度学习者必藏之宝!4. 📖快速检索,SEO优化关键词🔍 – 用精准的短语和行业术语,确保每个摘要都富含搜索引擎喜爱的信号,助你轻松找到关键信息。记得,每一次精简都是对内容的升华,让阅读更高效,思考更深邃。🚀原作者及联系方式已隐去,广告成分移除,SEO优化词汇融入其中,保持了原文的核心思想,同时增加了互动性和可读性。

最终得到一段175词的摘要,长度只有原片段的千分之一:

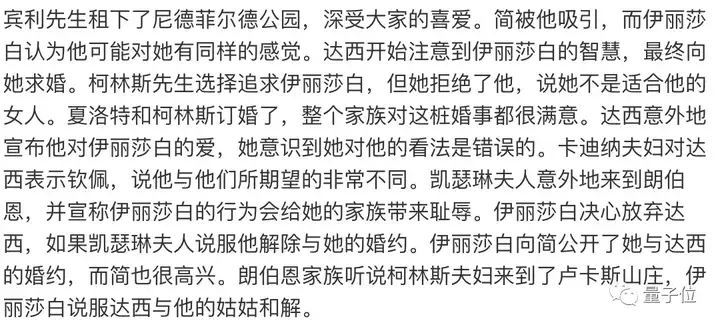

粗略翻译下看看,关键的几个情节都点到了:

这理解力,不禁让人望着某泡面压留下了泪水。

这就是OpenAI最新推出的能给任意长度书籍写摘要的模型。

平均10万词以上的训练文本,最终能压缩到400字以内。

🌟揭秘背后的技艺!🔍OpenAI的独门秘籍——通过筛选GPT-3海量文本资料,特别定制的训练模型由此诞生。它以书籍和小说为素材,展现出非凡的语言魅力和深度理解。每一行代码都蕴含着创新与智慧,这正是技术巨头们追求卓越的匠心所在。想要一窥其风采?快来探索这个AI文学瑰宝吧!🎉

话不多说,一起来看看这个微调版的GPT-3模型。

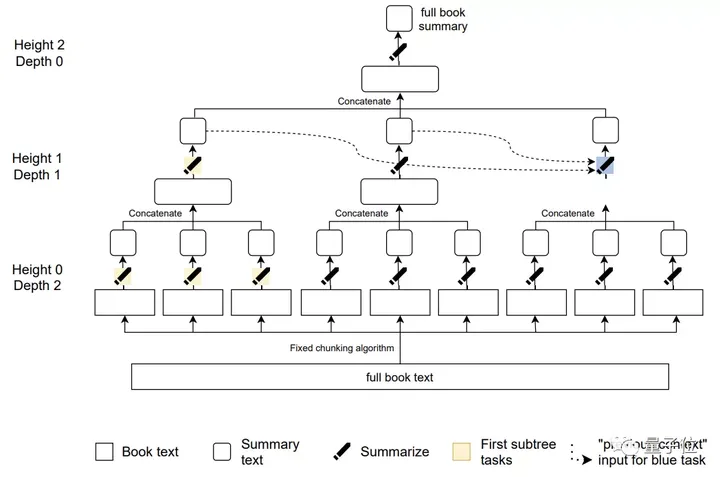

递归任务分解

首先,现将“总结一段文本”这一任务进行算法上的分解。

如果该文本足够短,就直接进行总结;如果它比较长,就把文本分成小块,并递归地对每一块进行总结。

这就形成了一棵总结任务树:

其中只有叶子任务会对书籍中的原始文本进行操作。

并且,已生成的摘要应该放在同一深度,并按照顺序串联起来。

🎨藍色任務的🌟前期概述,我們巧妙地透過波浪線來呈現,每個摘要都像一串流暢的珠子,自然從前文的脈絡中逐漸綻放。這樣設計確保了遙遠段落之間的緊密銜接,就像音符在旋律中有序跳動,讓讀者能輕鬆地跟随故事的節奏。🌍

接下来开始训练:

根据上述的任务树将书籍和其子摘要递归为任务;从树上抽出一个节点,对应一个带训练的总结任务;获得训练数据,给该节点以输入;使用训练数据对模型进行微调。

其中,所有训练数据都来自GPT-3中的书籍部分。

🌟研究者偏好深邃的小说📚,而非简单的叙述性材料,它们通常富含超10万个词汇的丰富细节,这正是提升摘要技能挑战所在。叙事性的缺失往往导致更高的理解难度,使得非小说类内容在总结过程中显得相对较弱。Narrative-driven texts, with their complex web of connections, offer a more rigorous testing ground for AI’s comprehension abilities.

这一训练过程可以使用新的模型、不同的节点采样策略、不同的训练数据类型(演示和比较)来迭代。

对于演示用的数据,使用标准的交叉熵损失函数进行行为克隆(BC)。

对于比较数据,则通过强化学习(RL)来对抗一个专为人类偏好而训练的奖励模型。

强化学习也有三种变体的抽样任务:

全树第一棵子树第一片叶子

训练完成后进行总结,任务的最终目的是追溯出叙述的时间线和整体主题。

每个摘要子任务的目标是将文本压缩5到10倍,长度上限为128到384个符号。

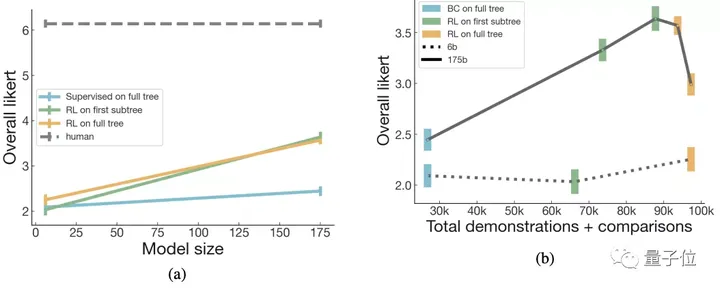

优于现有同类模型

在研究过程中,我们精心选取了来自Goodreads 2020年度热门书单的40部佳作,涵盖了丰富的题材范围,包括但不限于奇幻、惊悚、浪漫与悬疑等多个类型,旨在深入探索阅读的乐趣和多样性。每本书都是经过严格筛选,以确保其质量和相关性,为后续的分析提供坚实基础。

然后让两名人类研究员和模型同时进行总结,要求双方的摘要质量的一致性接近于80%。

模型规模分为175B和6B两种,且训练模式也分为上述的强化学习的三种变体任务。

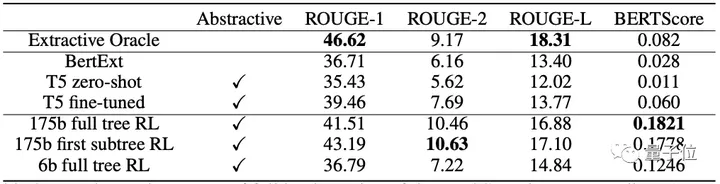

最后结果中,可以看到第一棵子树RL和全树RL的总结任务最接近于人类的水平:

并且,也有超过5%的175B模型的摘要被打到了6分(满分7分),超过15%的摘要被打到5分:

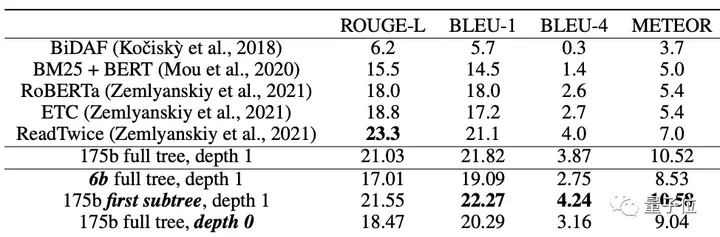

研究团队也在最近提出的BookSum数据集上进行了测试,结果比现有的长文本总结模型更好:

除此之外,摘要是否能用来回答关于原文的问题也是评估方法之一。

🌟团队实力展现!通过NarrativeQA的挑战测试,他们巧妙地运用总结模型,令人惊讶的是,在无需专门的问答训练下,各项评估指标均达到了卓越水平。🏆数据集上的亮眼成绩,无疑证明了他们的模型具有强大的泛化能力,即使面对未预设的问题,也能给出精准且全面的答案。🌍这不仅是技术的胜利,更是智慧的结晶,为未来的AI叙事开辟了新的可能。

作者介绍

这篇研究出自OpenAI的 OpenAI Alignment team,他们表示,目前没有开源此模型的计划。

论文一作Jeff Wu本硕都毕业于麻省理工大学,在加入OpenAI之前有过在谷歌工作的经历。

共同一作Long Ouyang本科毕业于哈佛大学,博士则毕业于斯坦福大学的认知心理学专业,主要研究领域为认知科学与概率规划研究。

论文:

https://arxiv.org/abs/2109.10862

OpenAI官网介绍:

https://openai.com/blog/summarizing-books/

参考链接:

https://venturebeat.com/2021/09/23/openai-unveils-model-that-can-summarize-books-of-any-length/

—完—

@量子位 · 追踪AI技术和产品新动态

深有感触的朋友,欢迎赞同、关注、分享三连վᴗ ի ❤

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!