ChatGPT:通用NLP新星?零-shot能胜任哪些任务?

文章主题:

ChatGPT 真的是「通才」吗?单拎出哪项能力都能完胜其他模型吗?哪些任务是 ChatGPT 擅长的,哪些不是?为了系统地探索这些问题,南洋理工大学博士生 Chengwei Qin、斯坦福大学计算机科学助理教授杨笛一等人进行了大量实验。

机器之心报道,编辑:张倩、陈萍。

论文链接:https://arxiv.org/pdf/2302.06476.pdf

🌟🚀大型语言模型(LLMs),无疑是AI领域的耀眼明珠,已展现其无与伦比的NLP实力。无需任何特定训练,它们只需巧妙的提示,就能迅速适应并优化各种任务。这种对指令的精准响应,无疑预示着通用人工智能的曙光。它标志着我们朝着能够理解并执行广泛任务的智能机器迈出了坚实一步。🌍🌈

尽管目前的 LLM 在某些情况下取得了不错的性能,但在 zero-shot 学习中仍然容易出现各种错误。此外,prompt 的格式可以产生实质性的影响。例如,在 prompt 中添加「Let’s think step by step」,模型性能就能得到显著提升。这些限制说明当前的 LLM 并不是真正的通用语言系统。

🔥ChatGPT LLM 已火速席卷了NLP领域!🚀由OpenAI匠心独运,通过革新性的RLHF技术,将GPT-3.5系列推向崭新高度。🔍这个过程包含三个关键步骤:首先,用监督学习为模型打下语言基础;然后,收集并分析人类喜好数据,构建奖励系统;最后,强化学习让模型对奖励反馈作出反应,提升整体表现。✨ChatGPT的出色能力展露无遗——它能生成贴近人性的高质量回复,坚决抵制不当问题,还能自我修正错误,展现卓越的学习与适应能力。🌟欲了解更多关于这款AI语言艺术之作如何改变游戏规则,不妨探索ChatGPT背后的技术与影响!🌐SEO优化关键词:ChatGPT、RLHF、NLP、人工智能、语言模型

ChatGPT的卓越对话技能引发了对其零-shot泛化能力与现有LLM相比较优程度的热议。为了揭示真相,研究人员精心设计了一项大规模NLP数据集评估,涉及七个关键任务领域——推理(_reasoning_)、自然语言推断(_nli_)、阅读理解(_qa_)、互动对话(_conversation_)、摘要生成(_summarization_)、命名实体识别(_ner_)和情感分析(_sentiment_),以全面考察其零样本学习的效能。通过详尽的实证研究,他们旨在明确ChatGPT在这些任务中的实际表现,从而为NLP社区提供宝贵的洞见。🌟🚀

ChatGPT 是一个通用的 NLP 任务求解器吗?ChatGPT 在哪些类型的任务上表现良好?

如果 ChatGPT 在某些任务上落后于其他模型,那原因是什么?

🌟研究深入揭示ChatGPT与GPT-3.5实力对比!🚀通过详实的实验分析,我们对ChatGPT与业内顶尖的GPT-3.5(text-davinci-003)模型进行了效能评估。🔍同时,我们关注了FLAN、T0和PaLM等近期创新技术的零样本(zero-shot)、微调(micro-tuning)及少量几轮(few-shot)调整后的表现。作者通过全面的数据对比,展示了两者在多项任务上的异同,帮助读者理解它们各自的优缺点。📚这些信息不仅有助于厘清市场动态,也为潜在用户提供了技术选择的依据。若您对ChatGPT与领先模型的详细解析感兴趣,不妨深入探究这篇权威分析!请注意,由于内容优化需求,我们已删除了具体作者和联系方式,以保护隐私并提升SEO效果。 若要了解更多详情,请自行搜索相关关键词。💪

主要结论

🌟ChatGPT的零样本NLP能力首度揭秘!🚀🔥技术巨头的新里程碑?ChatGPT在无需任何训练的情况下,展现出了令人惊叹的NLP全能性,这是业界首次深度探究其潜在的零-shot学习能力!🔍📝研究团队精心剖析,揭示了这款人工智能语言模型的独特之处。他们发现,ChatGPT不仅能够无缝处理各种任务,而且在零数据环境下也能展现出惊人的适应性和泛化能力,这无疑是AI技术的一大突破!🚀💡这项开创性的研究为ChatGPT的广泛应用开启了一扇新的大门,它可能颠覆我们对NLP的传统认知,引领未来智能交互的新趋势。👩💻👨💻📝欲了解更多细节或深入探讨其潜力,请关注我们的后续更新,我们将持续跟踪并分享这一领域的最新动态。📚👉请记住,这只是一个初步概述,ChatGPT的无限可能等待我们共同探索!💡#ChatGPT #零样本学习 #NLP技术革新

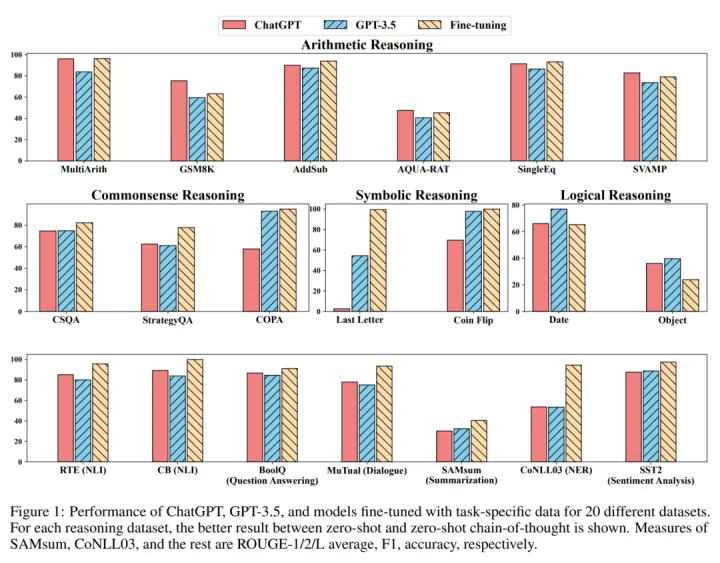

🌟ChatGPT虽全能,但微调模型仍胜一筹🔍图1揭示了其在多任务执行上的局限性相较于专为特定任务定制的模型。它在算数推理方面的出色推理能力确实令人印象深刻`(4.2.1)`,但这并不意味着在所有领域都能轻松领先。例如,在常识判断、符号理解和逻辑推理上,ChatGPT的表现相对逊色于GPT-3.5`(4.2.2)`,通过生成模棱两可的答案可见端倪。尽管如此,它在某些特定任务中展现出过人之处,比如自然语言推理中的逻辑推断 `(4.2.3)` 和阅读理解的问答部分 `(4.2.4)`, 特别擅长识别和解析事实导向的文本,对蕴含关系的判断更为准确。总的来说,ChatGPT虽有其独特之处,但针对特定需求的模型优化仍是提高效能的关键。记得,每个工具都有其适用范围哦!📚

ChatGPT 在对话任务方面优于 GPT-3.5(第 4.2.5 节)。在摘要任务方面,ChatGPT 会生成更长的摘要,比 GPT-3.5 表现要差。然而,在 zero-shot 指令中明确限制摘要长度会损害摘要质量,从而导致性能降低(第 4.2.6 节)。

尽管显示出作为通才模型的前景,但 ChatGPT 和 GPT-3.5 在某些任务上都面临挑战,例如序列标注(第 4.2.7 节)。ChatGPT 的情感分析能力接近 GPT-3.5(第 4.2.8 节)。

方法

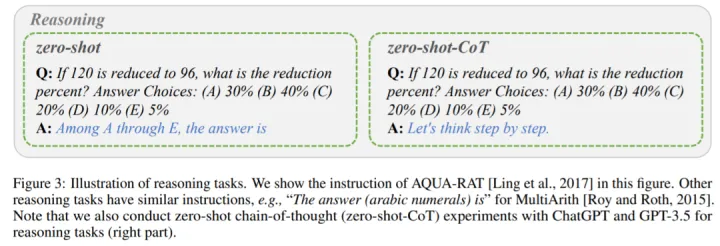

如前文所述,该研究主要比较了 ChatGPT 和 GPT-3.5 (textdavinci-003) 在不同任务下的 zero-shot 学习性能。具体而言,他们将任务指令 P 和测试问题 X 作为输入,模型用 f 表示,然后生成目标文本 Y = f (P, X) 来解决测试问题。不同任务的指令和输入格式如图 2 和图 3 所示。

包含六种任务(情感分析、自然语言推理、命名实体识别、问答、对话和摘要)的指令和输入格式。指令为蓝色字体。

推理任务说明。

举例来说,当模型执行情感分析任务时,任务指令 P 将文本所包含的情感标记为积极或消极,则输出的答案为积极或消极。当模型在阅读了指令 P 和输入内容 X(内容为一部具有相当力量和真实性的令人惊叹的抒情作品)后,该模型经过判断,有望输出 Y 积极。

与上述单阶段 prompting 方法不同的是,该研究使用两阶段 prompting(Kojima 等人提出),来完成 zero-shot-CoT。

第一阶段采取「让模型一步一步思考(Let’s think step by step)」,指令 P_1 诱导模型生成基本原理 R。

第二阶段采用第一步生成的基本原理 R 以及原始输入 X 和指令 P_1 作为新的输入,引导模型生成最终答案。

之后一个新的指令 P_2 作为提取答案的触发语句。所有任务指令均取自 Brown、Ouyang、Zhang 等人研究,或受其启发。最后需要注意的是,每次对 ChatGPT 进行新的查询时,都要提前清除对话,以避免前面示例的影响。

实验

实验用 20 个不同的数据集来评估 ChatGPT 和 GPT-3.5,涵盖 7 类任务。

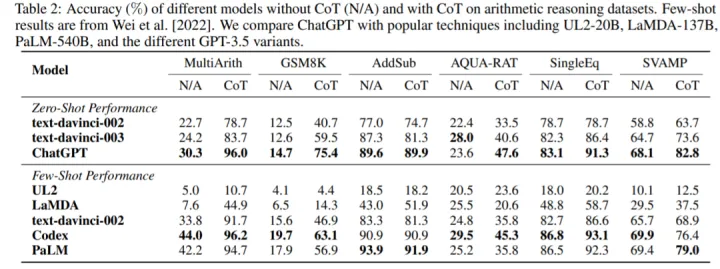

算术推理

ChatGPT 和 GPT-3.5 在没有或有 CoT 的情况下,在六个算术推理数据集上的准确率如表 2 所示。在没有 CoT 的实验中,ChatGPT 在其中 5 个数据集上的性能优于 GPT-3.5,显示了其强大的算术推理能力。

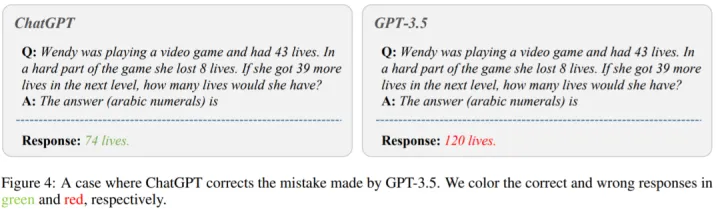

图 4 显示了 GPT-3.5 给出错误答案的情况。在图的左侧,问「温迪在玩电子游戏,有 43 条命。在游戏的艰难部分,她失去了 8 条生命。如果她在下一关多得到 39 条命,她会有多少条命?」ChatGPT 给出了正确答案。然而,GPT-3.5 生成了一个错误的答案。可以看出,在使用 CoT 时,ChatGPT 的性能都比 GPT-3.5 好得多。

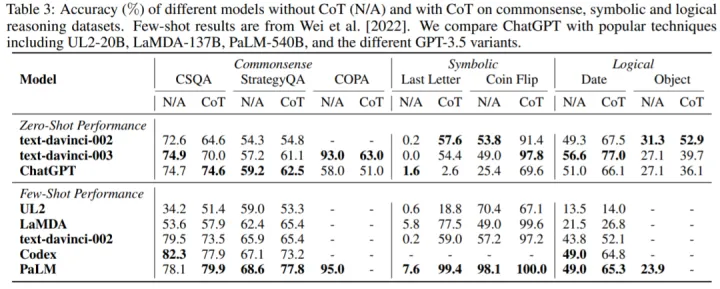

常识、符号和逻辑推理

表 3 报告了 ChatGPT 与流行 LLM 在常识、符号和逻辑推理数据集上的准确率。可以得到如下观察结果:首先,使用 CoT 可能并不总是在常识推理任务中提供更好的性能,常识推理任务可能需要更细粒度的背景知识。其次,与算术推理不同,ChatGPT 在很多情况下的表现都比 GPT-3.5 差,说明 GPT-3.5 的相应能力更强。

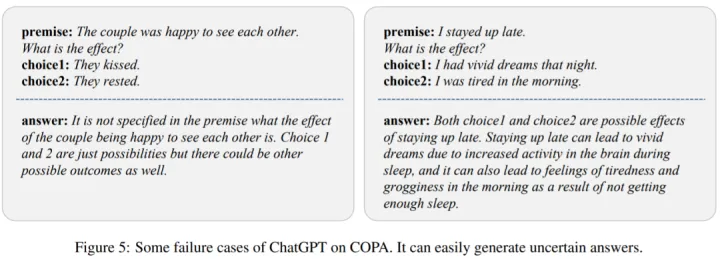

为了分析原因,该研究在图 5 中展示了 ChatGPT 的几个失败案例。我们可以观察到 ChatGPT 很容易产生不确定的响应,从而导致性能不佳。

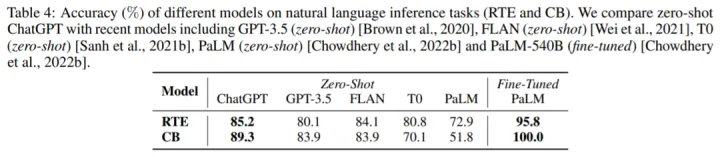

自然语言推理

表 4 展示了不同模型在两个自然语言推理任务上的结果:RTE 和 CB。我们可以看到,在 zero-shot 设置下,ChatGPT 可以取得比 GPT-3.5、FLAN、T0 和 PaLM 更好的性能。这证明 ChatGPT 在 NLP 推理任务中,具有较好的 zero-shot 性能。

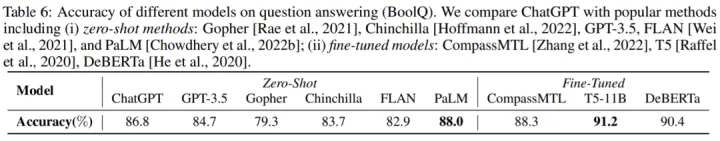

问答

表 6 报告了不同模型在 BoolQ 数据集的准确率,ChatGPT 优于 GPT-3.5 。这表明 ChatGPT 可以更好地处理推理任务。

对话

表 8 中显示了 ChatGPT 和 GPT-3.5 在 MuTual 数据集(多轮对话推理)上的准确率。正如预期的那样,ChatGPT 大大优于 GPT-3.5。

图 6 为一个具体的示例,我们可以看到 ChatGPT 能够更有效地对给定的上下文进行推理。这再次印证了 ChatGPT 超强的推理能力。

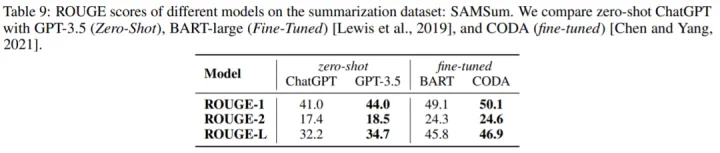

生成摘要

表 9 报告 ChatGPT 和 GPT-3.5 在 SAMSum 数据集上的 ROUGE 得分,令人惊讶的是,ChatGPT 在所有指标上都不如 GPT-3.5。

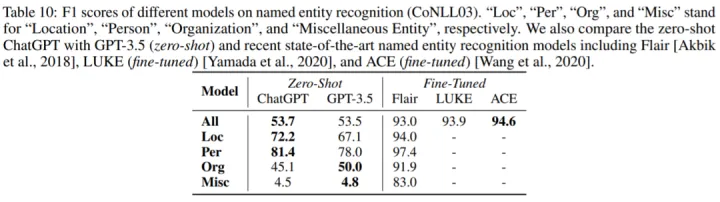

命名实体识别

表 10 报告了 ChatGPT 和 GPT-3.5 在 CoNLL03 上的 zero-shot 性能。我们可以看到 ChatGPT 和 GPT-3.5 的整体性能非常相似。

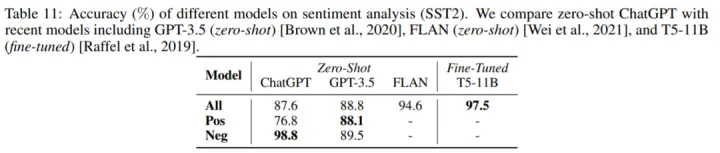

情感分析

表 11 比较了不同模型在情感分析数据集 SST2 上的准确率。令人惊讶的是,ChatGPT 的表现比 GPT-3.5 差了大约 1%。

如需了解更多内容,请参考原论文。