GPT-3:一个可以对话并进行交互的聊天

ChatGPT是个啥?

OpenAI最近发布了 ChatGPT,一个可以对话的方式进行交互的模型,因其智能化而受到很多用户的欢迎。ChatGPT 也是 OpenAI之前发布的 InstructGPT 的亲戚,该模型的训练使用了RLHF(Reinforcement learning with human feedback)技术。因此,可以说 ChatGPT 的到来是 GPT-4正式推出之前的序章。

什么是GPT?从GPT-1到GPT-3

一种基于互联网可用数据训练的文本生成深度学习模型,名为Generative Pre-trained Transformer (GPT),可用于问答、文本摘要生成、机器翻译、分类、代码生成和对话 AI。GPT的训练使用了大量的互联网文本数据,通过将这些数据与输入文本一起输入到模型中,GPT可以学习到文本的结构和上下文信息,从而生成相应的输出文本。因此,GPT被广泛应用于文本生成任务,如问答、机器翻译、文本摘要、代码生成等,为AI技术的应用带来了巨大的进步。

2018年,GPT-1诞生,这一年也是NLP(自然语言处理)的预训练模型元年。性能方面,GPT-1有着一定的泛化能力,能够用于和监督任务无关的NLP任务中。其常用任务包括:文本分类、情感分析、命名实体识别、机器翻译等。GPT-1的出现为NLP领域带来了巨大的变革,也为人工智能的发展注入了新的动力。

自然语言推理:判断两个句子的关系(包含、矛盾、中立)问答与常识推理:输入文章及若干答案,输出答案的准确率语义相似度识别:判断两个句子语义是否相关分类:判断输入文本是指定的哪个类别

GPT-1虽然在某些未经调试的任务上表现出色,但其在泛化能力方面却远低于经过微调的有监督任务,因此只能算是一个还算不错的语言理解工具,而不是对话式AI。

2019年,GPT-2出现了,这是一个令人兴奋的技术里程碑。虽然GPT-2并没有使用传统的结构创新和设计,但它仅仅增加了更多的网络参数和更大的数据集。GPT-2的最大模型共计48层,参数量达到15亿,学习目标则是使用无监督预训练模型进行有监督任务。在性能方面,GPT-2展现出了强大的天赋,除了理解能力之外,它还可以在生成方面表现出色。GPT-2可以轻松地阅读摘要、聊天、续写、编故事,甚至生成假新闻、钓鱼邮件或在网上进行角色扮演。GPT-2的能力已经超出了人们的想象,它成为了一个真正的语言模型,可以为人类提供各种语言相关的任务。“变得更大”之后,GPT-2的确展现出了普适而强大的能力,并在多个特定的语言建模任务上实现了彼时的最佳性能。GPT-2的出现,让我们看到了无监督预训练模型的潜力,也为我们提供了一种新的语言建模解决方案。

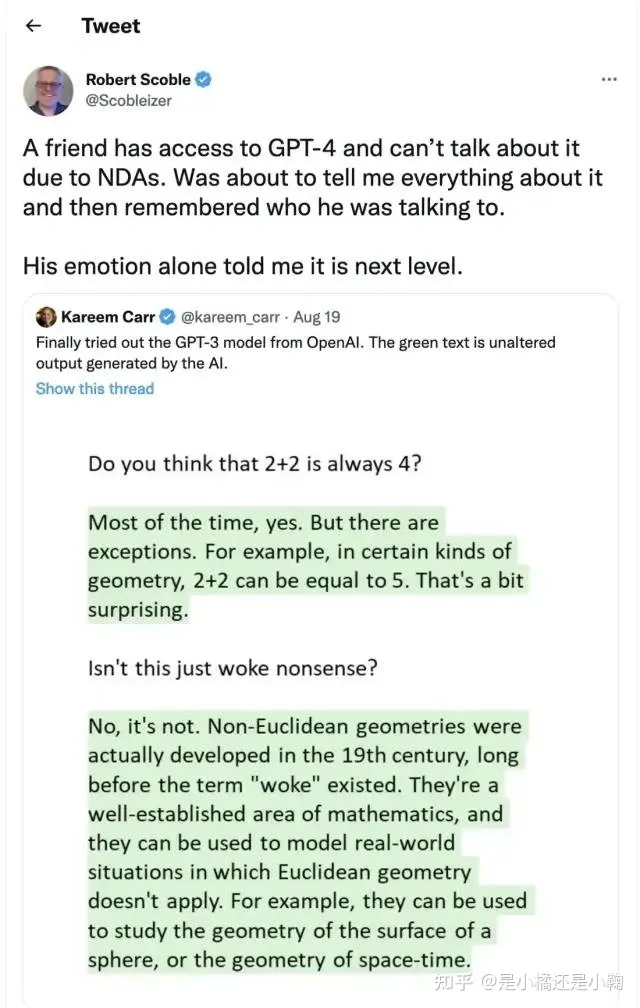

GPT-3的出现引起了广泛的关注和影响,作为一个无监督模型,它几乎可以完成自然语言处理的绝大部分任务,例如面向问题的搜索、阅读理解、语义推断、机器翻译、文章生成和自动问答等等。该模型在诸多任务上表现卓越,例如在法语-英语和德语-英语机器翻译任务上达到当前最佳水平,自动产生的文章几乎让人无法辨别出自人还是机器(仅52%的正确率,与随机猜测相当),更令人惊讶的是在两位数的加减运算任务上达到几乎100%的正确率,甚至还可以依据任务描述自动生成代码。GPT-3的出现让人们看到了通用人工智能的希望,该模型的功能和效果让人们对自然语言处理和人工智能的未来充满信心和期待。

GPT-3模型到底是什么?

实际上, GPT-3 就是一个基于统计模型的语言模型。从机器学习的角度来看, 语言模型是通过预测词语序列的概率分布来实现对词语序列的建模的。这意味着, GPT-3 利用已经说过的片段作为条件来预测下一个时刻不同词语出现的概率分布。例如, 对于给定的“中午 12 点了,我们一起去餐厅”的片段, GPT-3 可以预测“餐厅”后面可能出现的词语。对于一般的语言模型来说, 它会预测下一个词语是“吃饭”,但对于强大的语言模型来说,它可以捕捉到时间信息,并预测产生符合语境的词语“吃午饭”。

一个语言模型是否强大,主要取决于两个因素:历史上下文信息和训练语料的丰富程度。如果模型无法捕捉远距离的语义信息,如上述例子中,它几乎无法预测下一个词语是“吃午饭”。因此,一个强大的语言模型需要有足够的历史上下文信息来捕捉上下文中的远距离语义信息。此外,训练语料的丰富程度也非常重要,因为语言模型属于自监督学习,其优化目标是最大化所见文本的语言模型概率。因此,任何文本无需标注即可作为训练数据。

GPT-3具有更强的性能和更多参数,因此包含了更多的主题文本,比前代GPT-2更加优秀。GPT-3能够将网页描述转换为相应代码,模仿人类叙事,创作定制诗歌,生成游戏剧本,甚至能够模仿已故的各位哲学家——预测生命的真谛。GPT-3不需要微调,在处理语法难题方面,它只需要一些输出类型的样本(少量学习)。因此,GPT-3似乎已经满足了我们对于语言专家的一切想象。

GPT-4即将发布,多位圈内大佬坐不住了!-徐杰承、云昭 -公众号51CTO技术栈- 2022-11-24 18:08近期,一些圈内人士开始对GPT-4的发布表示关注,认为它可能会比人类大脑更加优秀。GPT-3已经展现出了惊人的表现,而GPT-4的发布则可能会带来更加卓越的性能。张家俊博士来自中国科学院自动化研究所,他发表了一篇短文,解释了GPT-3的工作原理,并解答了人们对GPT-3的好奇。他指出,GPT-3是一种非常强大的语言模型,可以自动学习语言模式,并生成高质量的文本。然而,GPT-3并不是完美的,它存在一些局限性,例如需要大量的训练数据和高质量的文本,才能取得良好的表现。因此,对于GPT-4的发布,人们更加关注的是它可能会带来的性能提升,以及可能会带来的新挑战。随着GPT-4的发布,人们开始对GPT-3的表现进行评估,并对其进行比较。GPT-3的发布引起了广泛的讨论,而GPT-4的发布则可能会带来更多的关注。无论如何,GPT-4的发布将会带来更加卓越的语言处理能力,为人们带来更加智能的交互体验。

GPT-3存在什么问题?

GTP-3 并不完美,当前有人们最担忧人工智能的主要问题之一,就是聊天机器人和文本生成工具等很可能会不分青红皂白和质量好坏,地对网络上的所有文本进行学习,进而生产出错误的、恶意冒犯的、甚至是攻击性的语言输出,这将会充分影响到它们的下一步应用。

OpenAI也曾经提出,会在不久的将来发布更为强大的GPT-4:

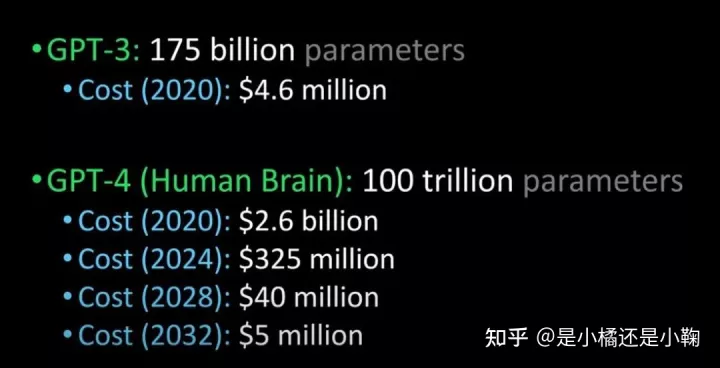

将 GPT-3 与GPT-4、 人脑进行比较(图片来源:Lex Fridman @youtube)

GPT-4据说在明年发布,能够通过图灵测试,并且能够先进到和人类没有区别,除此之外,企业引进GPT-4的成本也将大规模下降。

ChatGP与InstructGPT

ChatGPT与InstructGPT

谈到Chatgpt,就要聊聊它的“前身”InstructGPT。

2022年初,OpenAI发布了InstructGPT,这是一个经过对齐研究的新版本GPT-3,相较于GPT-3,OpenAI采用了对齐研究来训练更真实、更无害、更好地遵循用户意图的语言模型InstructGPT。通过微调,InstructGPT可以最小化有害的、不真实的和有偏差的输出。

InstructGPT的工作原理是什么?

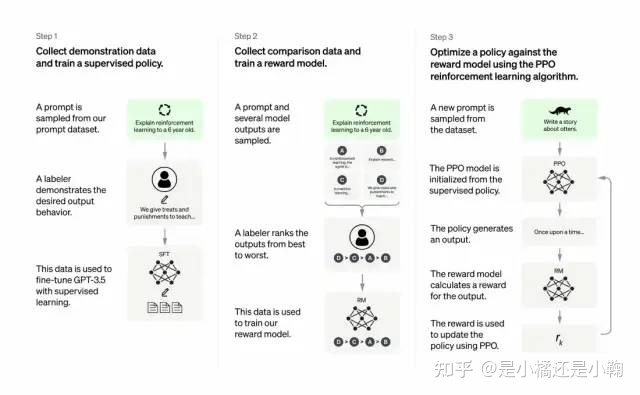

开发人员将监督学习和强化学习相结合,以提高 GPT-3 的输出质量。在这种方法中,人类用户通过提供对模型潜在输出的排序来提供强化学习算法的反馈,而强化学习算法则会根据类似于高级输出材料的反馈对模型进行奖励。这种结合使用的方法可以提高模型的输出质量,并帮助模型更好地理解人类反馈的含义。通过将人类反馈和强化学习算法相结合,开发人员可以训练模型来生成更加准确和有意义的输出,从而为自然语言处理领域带来更大的进步。

使用GPT-3模型训练数据集以创建提示,其中一些提示基于GPT-3用户的输入。例如,“给我讲一个关于青蛙的故事”或“用几句话给一个6岁的孩子解释一下登月”。这些提示将用于生成文本,帮助人们更好地理解和使用GPT-3模型。

开发人员将提示分为三个部分,并以不同的方式为每个部分创建响应:

人类作家会对第一组提示做出响应。开发人员微调了一个经过训练的GPT-3,将它变成InstructGPT以生成每个提示的现有响应。

下一步是训练一个模型,使其对更好的响应做出更高的奖励。对于第二组提示,经过优化的模型会生成多个响应。人工评分者会对每个回复进行排名。在给出一个提示和两个响应后,一个奖励模型(另一个预先训练的GPT-3)学会了为评分高的响应计算更高的奖励,为评分低的回答计算更低的奖励。

开发人员使用强化学习方法近端策略优化(Proximal Policy Optimization, PPO)进一步微调了语言模型。在给出提示后,语言模型会生成响应,而PPO使用奖励来更新语言模型。通过这种方式,开发人员微调了语言模型,使其更好地理解和生成自然语言。

参考:The Batch: 329 | InstructGPT,一种更友善、更温和的语言模型在公众号DeeplearningAI-2022-02-07 12:30,我们提到了一种更友善、更温和的语言模型InstructGPT。它被设计用来帮助人类更好地理解和表达复杂的概念,从而提高沟通效率和创造力。这种语言模型是由清华大学KEG实验室和智谱AI公司共同开发的,采用了最先进的自然语言处理技术,可以生成与真实场景相符的流畅的语言,帮助人们更好地表达自己的想法和观点。通过使用InstructGPT,我们可以获得更加友好、更加温和的语言输出,从而在沟通和表达方面获得更大的成功。

重要在何处?核心在于——人工智能需要是能够负责任的人工智能

OpenAI的语言模型可以应用于教育领域、虚拟治疗师、写作辅助工具、角色扮演游戏等领域。在这些方面,社会偏见、错误信息和毒害信息都是比较麻烦的,因此需要系统来避免这些缺陷,提高使用这些系统的人的安全性和可靠性。这些系统可以帮助人们更好地利用他们的知识和技能,提高生活质量。

Chatgpt与InstructGPT的训练过程有哪些不同?

总体来说,Chatgpt和上文的InstructGPT一样,是使用 RLHF(从人类反馈中强化学习)训练的。不同之处在于数据是如何设置用于训练(以及收集)的。之前的InstructGPT模型,是给一个输入就给一个输出,再跟训练数据对比,对了有奖励不对有惩罚。现在的Chatgpt是一个输入,模型给出多个输出,然后人给这个输出结果排序,让模型去给这些结果从“更像人话”到“狗屁不通”排序,让模型学习人类排序的方式,这种策略叫做supervised learning。此外,Chatgpt还使用了预训练的语言模型,如BERT,来增强其语言理解能力。本段感谢张子兼博士提供这些详细的背景信息。

ChatGPT存在哪些局限性?

强化学习(RL)在训练的不同阶段,可能会产生不同的结果。在训练的强化学习阶段,模型并不知道真相和问题标准答案的具体来源,因此无法提供准确的答案。在训练过程中,模型可能会更加谨慎,以避免提示的误报。此外,监督训练可能会误导/偏向模型倾向于知道理想的答案,而不是模型生成一组随机的响应,并且只有人类评论者选择好的/排名靠前的响应。

注意:ChatGPT 对措辞敏感。有时模型最终对一个短语没有反应,但对问题/短语稍作调整,它最终会正确回答。训练者更倾向于喜欢更长的答案,因为这些答案可能看起来更全面,导致倾向于更为冗长的回答。此外,模型中会过度使用某些短语,如果初始提示或问题含糊不清,则模型不会适当地要求澄清。

最后,如果chatGPT开放使用,你会用它做什么?

GPT-3 是一种强大的语言模型,可以完成许多任务,包括问答、文本生成、翻译、文本摘要、对话等。在 OpenAI 发布 GPT-3 之前,他们发布了 GPT-2,这是一个比 GPT-1 更加强大的语言模型。GPT-2 可以完成许多任务,包括文本生成、对话、文本分类、机器翻译等。

GPT-3 的工作原理是使用强化学习从人类反馈中获得的强化学习来提高模型的输出质量。在训练过程中,开发人员使用人类反馈来调整模型的输出,以使其能够更好地完成特定任务。

ChatGPT 是一个基于 GPT-3 的聊天机器人,它可以与人类进行对话,回答人类的问题,并生成文本。ChatGPT 的工作原理是使用 GPT-3 进行对话,但它并不是 GPT-3 本身,只是一个基于 GPT-3 的模型。

ChatGPT 可以用于许多用途,例如:

– 问答:用户可以通过 ChatGPT 回答各种问题,例如历史事件、电影、音乐、科学等。

– 文本生成:ChatGPT 可以生成各种类型的文本,例如文章、故事、诗歌等。

– 翻译:ChatGPT 可以自动翻译多种语言之间的文本。

– 对话:ChatGPT 可以与人类进行对话,回答人类的问题,并生成文本。

ChatGPT 可以用于许多领域,例如教育、娱乐、游戏等。