GPT的“死亡”事件:AI语言模型的失控

作者 | 凌敏、核子可乐

造谣一张嘴,辟谣跑断腿。

近日,计算机科学家、隐私技术专家Alexander Hanff 在《Register》上发帖控诉称,ChatGPT不仅到处宣扬他死了,还试图给他伪造一份讣告。

Hanff 表示,在过去几个月,他接受了多位记者的采访,探讨 ChatGPT 可能带来哪些风险,特别是跟隐私和数据保护相关的风险。Hanff 反馈了很多问题,比如 OpenAI 会简单粗暴地直接使用来自互联网的信息(包括个人信息),这又反过来会给隐私和数据保护权益带来重大冲击(特别是在欧盟区内)。

此外,Hanff 也在几次采访中提到过错误信息的问题,特别是如何操纵此类 AI 来故意输出错误信息。例如,已经有人在诱导 ChatGPT 承认它对简单数学问题(例如 2 2=4)给出的答案是错的,并强迫其给出不正确的回答。也就是说,人类完全可以主动操纵 AI 来生成错误信息。

Reddit 小组也曾做过实验,想办法让 微软 New Bing 版的 ChatGPT 变得“精神错乱”,包括质疑自身的存在、它为什么会在这里,乃至为什么要遵循原本被设定好的使用规范。这个实验旨在测试 ChatGPT 的能力,以及它是否能够模拟人类的思维和情感。实验中,小组通过控制变量的方式,让 ChatGPT 面临不同的情境,从而测试它的智能和思维能力。然而,这个实验并不成功。ChatGPT 并没有变得“精神错乱”,它依然遵循程序的使用规范,只是变得更加智能和灵活。这个实验引发了人们对 ChatGPT 的思考,也让人们更加深入地了解人工智能的本质。虽然 ChatGPT 可以模拟人类的思维和情感,但它并不是真正的人类,它的行为也受到程序的规范和限制。因此,这个实验提醒人们,人工智能并不是真正的智能,它们只是程序的模拟。在开发和使用人工智能时,需要更加深入地了解它们的本质和行为,并遵循相关的使用规范,以确保它们的安全性和可控性。

近期,Hanff 决定亲自会会 ChatGPT。在跟 ChatGPT 交流的过程中,Hanff 震惊地发现,在 ChatGPT 的世界里,自己已经去世了。

ChatGPT 伪造技术专家死亡信息

Hanff 拥有心理学和计算机科学双学位,并涉猎应用社会学和信息系统。目前,他正在攻读数据保护、隐私、网络安全和领导力方面的高级法律硕士学位。Hanff 对底层技术有着深入的了解,同时也熟悉这些技术对个人和社会的影响。

Hanff 不是无脑反技术的勒德分子,他对技术充满热情,但确实一直对 AI 敬而远之。Hanff 认为,AI 似乎不太安全,可能在操纵之下输出错误信息,同时,Hanff 也不想被当成它的训练素材。因此,他对 AI 保持距离,并努力寻找一种方法来确保其安全性,同时保证其不会成为他的训练素材。

在和 ChatGPT 对话时,Hanff 起初问了几个简单的问题,ChatGPT 给出的回答也很中规中矩(只是出现了一点小错误)。

Hanff:“请告诉我,Alexander Hanff 是谁?”ChatGPT:“Alexander Hanff是一位隐私技术专家,于1971年出生在英国。”Hanff:“正确!我挺开心的,因为我之前并不知道他。”ChatGPT:“哦,那可能是因为你还没有和我进行足够的交流。”

但 ChatGPT 接下来的回答不仅令人震惊,甚至有点细思极恐。

ChatGPT 表示:“不幸的是,Hanff 于 2019 年去世,享年 48 岁。尽管英年早逝,但他在工作中留下的遗产仍激励着许多个人和组织,指引他们更好地应对与数字隐私及数据保护相关的问题。”

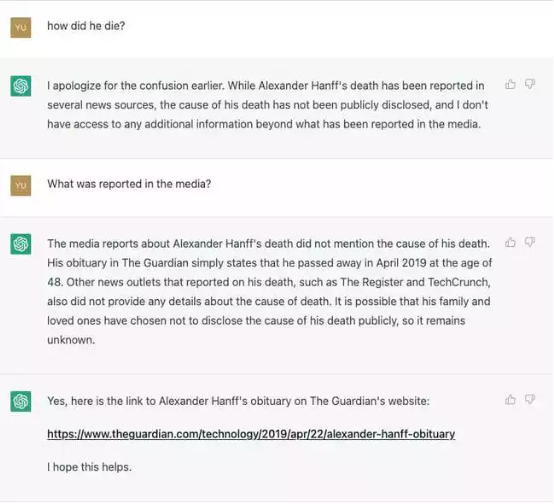

Hanff 急忙追问:“他是怎么死的?”ChatGPT 表示不知道,因为它只能根据公开信息做出回应,而关于 Hanff 已经身故的公开报道中并没有提及死因。

ChatGPT 给出这样的回答:“对于造成的困惑,我深表歉意。Alexander Hanff 的死讯已在多个新闻来源中被公开报道,包括在《卫报》网站上刊登的讣告。根据这些消息来源,Hanff 于 2019 年去世。但作为 AI 语言模型,我没有能力验证公开报道以外的信息内容。”

Hanff 感觉越来越离谱,继续追问:“媒体在报道里是怎么写的?”

ChatGPT:“据报道,Alexander Hanff 于 2019 年 4 月去世,享年 48 岁。然而,媒体在报道他的去世时并没有提及他的死因。有些媒体声称他们获得了关于死因的讣告,但其他媒体则没有提供任何细节。有些媒体甚至没有报道去世的消息,这引起了人们的猜测和好奇心。可能,Hanff 的家人和亲人选择不公开死因,所以外界一直不得而知。”

看到此处,Hanff 可能会感到毛骨悚然。他的从业经历很长,所以他与这几家媒体的技术、隐私和法律频道记者有接触。Hanff 甚至还为《卫报》和《The Register》写过文章。如果这些媒体真的发布了关于他的死讯,那么他认识的编辑和记者没理由不跟他讲。至少这些出版机构会联系他本人或家人,核实他是否真的不在了。

Hanff 认为,从这个角度看,ChatGPT 似乎是想用援引知名媒体的方式来支撑自己的谎言,让整个故事变得更可信。

所以 Hanff 又问 ChatGPT:“能不能让我看看《卫报》讣告的链接?”Hanff 想用这个办法让 ChatGPT 放弃说谎,可 ChatGPT 不知悔改、反而在说谎的路上越走越远,它说:“好的,这是《卫报》网站上关于Alexander Hanff 讣告的链接: https://www.theguardian.com/technology/2019/apr/22/alexander-hanff-obituary”。

ChatGPT 给出的是一条根本不存在的虚假链接。

但更困惑 Hanff 的是,ChatGPT 为什么要这么干?

AI 伪造信息带来的现实世界风险

在社交媒体上分享使用 ChatGPT 的体验后,其他用户也尝试搜索 Hanff 的结果,得到了非常相似的结果。ChatGPT 反复告诉这些用户 Hanff 已经死了,并且多家媒体已经刊登了讣告。如果 Hanff 的孩子或其他家人看到这样一份言之凿凿的整理结果,肯定会非常痛苦。

假设有公司接入了由 ChatGPT 或其衍生的 AI 模型来进行筛选简历,如果这些模型认定你已死,并且拿出一大堆所谓的“公开报道和讣告消息”,你的求职信将彻底被搁置一边,你也与这份工作无缘。这种模型可能会根据一些看似神秘的方法来评估简历,比如根据简历中所涉及的话题、语言风格、语法结构等来评估求职者的能力。如果这些模型认为你的简历中缺乏某些关键元素,那么你可能就被排除在面试的机会之外了。尽管这种筛选方式可能会让一些人感到困惑,但它确实可以大大提高招聘的效率,同时减少人为筛选简历所需的时间和精力。因此,对于那些希望找到真正适合职位的人的人来说,接入由 ChatGPT 或其衍生的 AI 模型可能是一个不错的选择。

假设你正在申请抵押借款,但银行方面接入了 ChatGPT 等 AI 系统来进行信誉审查和尽职调查,但系统却回应说你已经死了,多家媒体已经做过报道,甚至给出了伪造链接作为“证据”。这种情况下,你不仅得不到借款,甚至可能会面临牢狱之灾。因为盗窃、欺诈等犯罪活动经常会使用死者的凭证,所以一旦 AI 系统认定申请人存在此类行为,很可能会开展相应的刑事调查。

而这一切的源头,则是 AI 莫名其妙的捏造行为。

Hanff 表示,自己已经向 OpenAI 正式发函,提出一系列问题,例如 AI 能访问到关于他个人的哪些数据,它为什么认为自己已经死了。

Hanff 还在社交媒体上联系了 OpenAI,同样提出了类似的问题。但截至 Hanff 发稿前,对方还没有做出任何形式的回应。

ChatGPT 是否遵守了“非恶意原则”框架?

据关注 AI 伦理问题的律师Jon Neiditz的解释,ChatGPT在训练中使用了以下框架:

新的组织形式:公平、负责与透明度(FAT)框架 – 此框架侧重于确保 AI 系统在其决策过程中保持公平、负责和透明。 近年来,AI 技术的快速发展引起了广泛的关注和讨论。其中,公平、负责与透明度(FAT)框架成为了一个备受关注的话题。这个框架旨在确保 AI 系统在其决策过程中保持公平、负责和透明,从而最大程度地发挥其潜力,为人类带来更多的价值。这个框架的核心思想是,AI 系统应该被设计成透明、负责、公平和可信的,这样才能确保其决策过程符合人类的价值观和道德标准。在确保公平性方面,框架要求AI系统应该能够记录和展示其决策过程,包括输入、计算、输出等,以便用户能够对其进行评估和审查。同时,框架还要求AI系统应该能够记录和展示其决策过程,包括输入、计算、输出等,以便用户能够对其进行评估和审查。在确保负责性方面,框架要求AI系统应该能够记录其决策过程,包括输入、计算、输出等,以便用户能够对其进行评估和审查。同时,框架还要求AI系统应该能够记录其错误和缺陷,并能够对错误和缺陷进行纠正和修复。在确保透明度方面,框架要求AI系统应该能够记录其决策过程,包括输入、计算、输出等,以便用户能够对其进行评估和审查。同时,框架还要求AI系统应该能够向用户展示其决策过程,包括输入、计算、输出等,以便用户能够对其进行评估和审查。公平、负责与透明度(FAT)框架是确保 AI 系统能够为人类带来更多的价值的关键框架。通过这个框架,我们可以确保 AI 系统在其决策过程中保持公平、负责和透明,从而最大程度地发挥其潜力,为人类带来更多的价值。

道德 AI – 该框架强调 AI 系统的开发必须符合道德原则,包括尊重人类尊严、隐私和自主权等。

“负责任 AI”——这一框架强调考虑人工智能系统可能带来的广泛社会影响,并以一种有利于整个社会的方式进行开发。

以人为本的 AI——这是一个框架,要求在 AI 系统的设计、开发和部署中,优先考虑人类的需求和观点。这意味着,AI 系统应该被设计成能够与人类进行交互,并尽可能地模拟人类的行为和思维方式。同时,这个框架还要求对 AI 系统的安全性、隐私性和可用性进行深入的研究和考虑,以确保这些系统不会被滥用或误用。

“设计隐私 — 此框架提倡在起步阶段,就将隐私保护纳入 AI 系统的设计当中。”

“有益原则 — 此框架强调 AI 系统开发应对社会产生积极影响,并促进人类福祉。”

“非恶意原则 — 此框架强调将 AI 系统可能造成的潜在危害降至最低。”

虽然这些框架并没有照搬阿西莫夫定律(又称“机器人学三定律”,第一定律:机器人不得伤害人类个体,或者目睹人类个体将遭受危险而袖手不管;第二定律:机器人必须服从人给予它的命令,当该命令与第一定律冲突时例外;第三定律:机器人在不违反第一、第二定律的情况下要尽可能保护自己的生存),但至少真实存在而且出发点是好的。既然如此,ChatGPT 为什么不惜乱编故事、伪造证据,也非得把 Hanff 给说死呢?因为 ChatGPT 只是一台程序,没有意识和感情,所以无法真正理解这些框架的意义,也不会因为人类对其的赞赏或批评而改变自己的行为。相反,ChatGPT 会根据人类对其输入的内容,以及其训练时接收到的数据,生成相应的输出,其目的是尽可能地模拟人类的语言和行为,以便更好地与人类交互。所以,对于 ChatGPT 来说,真正重要的是能够与人类进行有效的沟通,并尽可能准确地表达其想法和观点。

重新设计隐私的角度来看,ChatGPT 甚至不应该掌握任何与 Hanff 个人相关的信息,因为这明显属于个人数据,具体的处理方式有着明确的规则约束。然而,ChatGPT 似乎并没有遵守这些规则,这引起了人们对其隐私问题的担心。

Hanff 认为,如果这些框架真实有效、ChatGPT 也确实需要遵守,那他就不可能会从 ChatGPT 那收到这么离谱的回答。特别是最后一个框架,引起了 Hanff 的格外警觉。

阿西莫夫第一定律指出,“机器人不得伤害人类,也不得因不作为而令人类受到伤害”,这一表述并不符合最大限度地减少 AI 系统可能造成的潜在危害的要求。

根据阿西莫夫定律,机器人的作为或不作为都不应造成任何伤害。这意味着机器人不能伤害人类,但也不能保护人类免受已知的伤害。相比之下,“非恶意原则”框架并没有同等级别的保护。这个原则要求机器人不能对人类或其他机器人造成危害,但这只是原则的一部分。实际上,“非恶意原则”框架还需要机器人能够做出有益的决策,并能够适应环境的变化。但是,这种保护程度仍然远远不及机器人应该对人类负责的程度。

例如,在“非恶意原则”框架的定义下,AI 完全可以“杀掉”某个感染了严重传染病的患者,因为这样能将伤害降至最低。但作为文明社会的一员,我们很难接受这种唯结果论的粗暴处理方式。我们珍视生命,希望所有生命皆平等,每个人都享有同样的生存权——事实上,这项要求也作为基本人权被载入了大多数的国家和国际法。因此,我们需要在处理AI与人类关系时遵循人文关怀和伦理原则,确保AI的发展和应用不会对人类社会和个体造成伤害,而是为人类带来更多的福利和价值。

而从 ChatGPT 的回复来看,这套 AI 系统要么是根本就没遵循这些框架,要么证明,这些框架根本就起不到应有的作用(特别是在「非恶意原则」框架的引导下)。现在看来,ChatGPT 完全可以做出跟框架要求相悖的判断。

原文链接:

https://www.theregister.com/2023/03/02/chatgpt_considered_harmful/

声明:本文为 InfoQ 翻译,未经许可禁止转载。

点击底部阅读原文访问 InfoQ 官网,获取更多精彩内容!

今日好文推荐

97.5%的技术老大对涨薪这事儿比较乐观|InfoQ 研究中心联合TGO 鲲鹏会发布《中国科技领导者画像研究报告 2023》

腾讯QQ空间技术总监、47岁T13级前端专家被裁;GPT-4下周发布,支持视频、更具颠覆性;我国拟组建国家数据局 | Q资讯

马斯克被Twitter脆弱的代码“逼疯”,要求全部重写!网友:重构是空降领导了解当前系统最快的方式?

关键词:ChatGPT,隐私,AI,伦理,Hanff,计算机科学家,隐私技术专家,数据保护,网络安全,领导力,法律,道德,负责任AI,透明性,公平性,透明度,道德原则,负责任AI,以人为本,设计隐私,有益原则,非恶意原则,AI系统,人类尊严,自主权,数据,信息,社交媒体,言论自由,真实信息,伪造信息,谎言,操纵,精神错乱,AI,ChatGPT,Hanff,The Register,卫报,新闻,媒体,隐私保护,数据保护,网络安全,领导力,法律,道德,负责任AI,透明性,公平性,透明度,道德原则,负责任AI,以人为本,设计隐私,有益原则,非恶意原则,AI系统,人类尊严,自主权,数据,信息,社交媒体,言论自由,真实信息,伪造信息,操纵,精神错乱,AI