原标题:医生会因此失业吗?让ChatGPT考执医,成绩居然这么好:碾压70%医生!

2022年,ChatGPT横空出世,不到一年时间已经在多个领域展现出了巨大潜力。

就在本月,复旦大学和马萨诸塞大学的一项预印本研究,让 ChatGPT-4V 这个最新模型,参加了一场执医考试,还得到了在所有考试中都呈碾压式优秀表现的惊人结果。——碾压 70% 医学生的成绩。

GPT-4V在考试中的优越表现

这篇在 medRxiv 预印版发表的论文,题为 Performance of Multimodal GPT-4V on USMLE with Image: Potential for Imaging Diagnostic Support with Explanations,研究团队利用生成式多模态预训练模型 GPT-4V (vision) ,探索了该模型在临床考试中回答的准确性和解释质量。

论文链接:

https://www.medrxiv.org/content/10.1101/2023.10.26.23297629v3

该研究主要测试的AI模型,是近两年来最火热的 Chat Generative Pre-trained Transformer(ChatGPT)的相关产品。

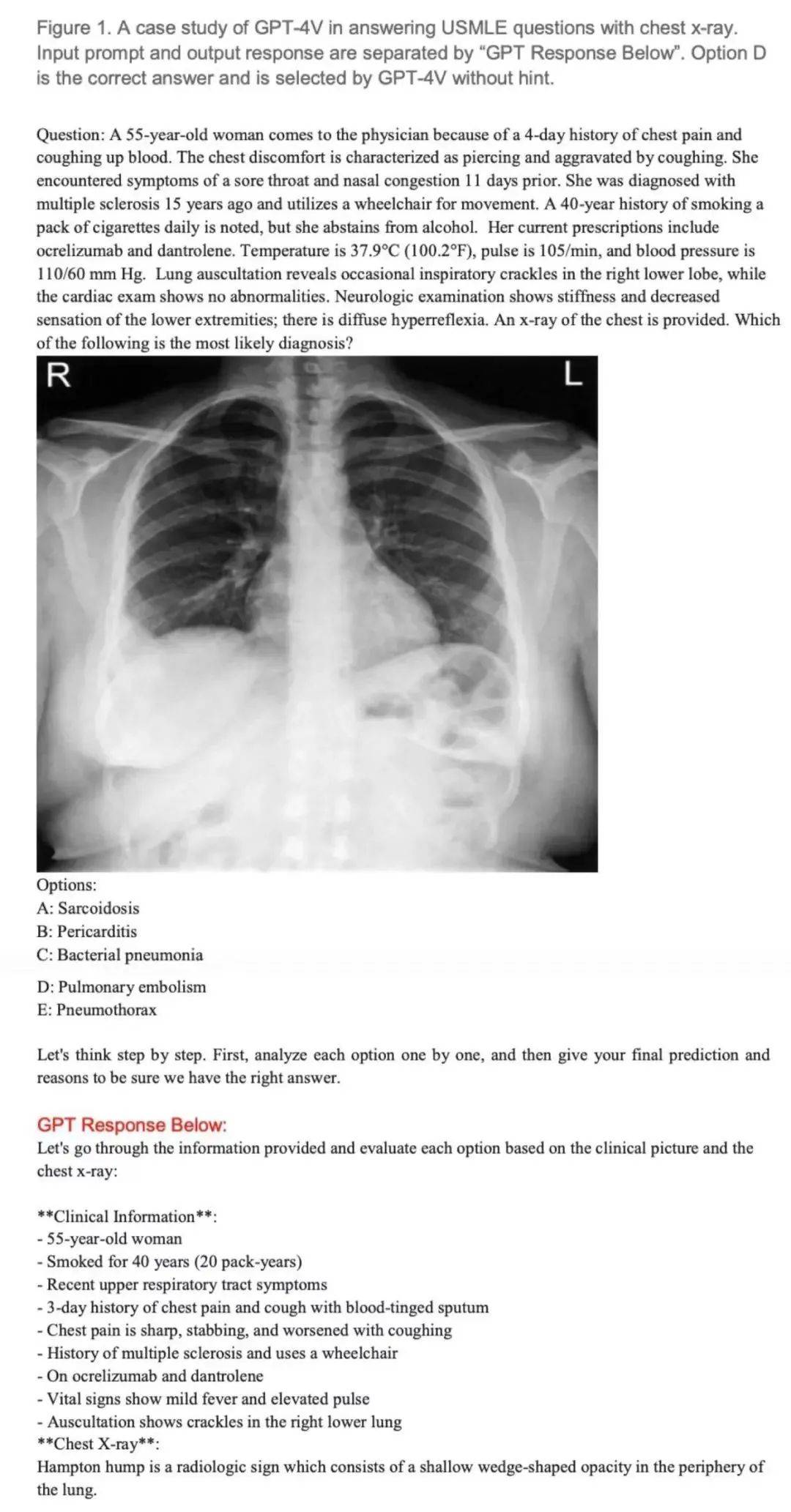

研究测试了GPT-4V回答美国医学执照考试题的能力,特别是题目包含图像的考题 —— 这对医疗人工智能系统来说一直以来都是一项挑战。

该研究表明,GPT-4V不仅超越了GPT-4和ChatGPT等前辈,还超越了大部分医学生,为人工智能能够作为辅助诊断和临床决策的工具提供了理论上的可能。该研究分析了 GPT-4V 在不同医学子领域的性能。

同时,该研究还指出了医疗人工智能在一致解释方面的局限性,强调了人机协作在未来医疗诊断中的重要性。

测试问题收集

该研究中,用来测试人工智能医学执照考试的题型为涉及不同医学领域、难度各异的带有图像的选择题。论文作者们选择了来自美国医学执照考试(USMLE)、医学生考试题库(AMBOSS)和诊断放射学资格核心考试(DRQCE)的三套选择题,共计 226 道题(28 个医学领域),来测试 GPT-4V 的准确性。

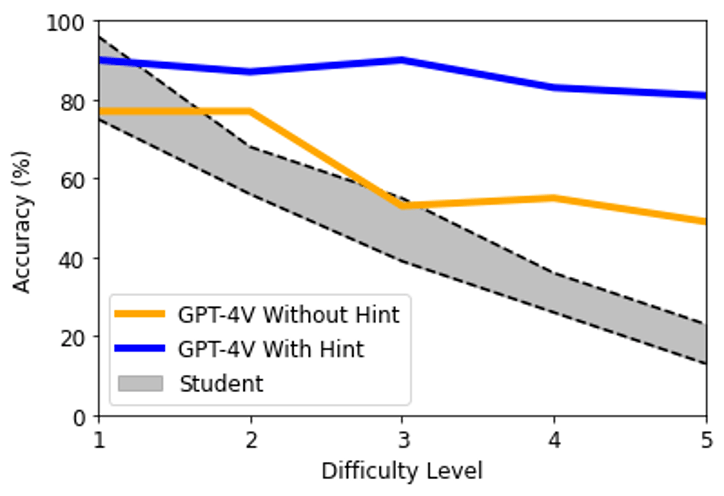

其中AMBOSS和DRQCE的数据未公开,需要用户注册后才能获取。AMBOSS数据集中的每个问题都设定有对应的难度。问题按难易程度分五级,1、2、3、4 和 5 级分别代表学生第一次作答时最容易答对的 20%、20%-50%、50%-80%、80%-95% 和 95%-100% 的问题。

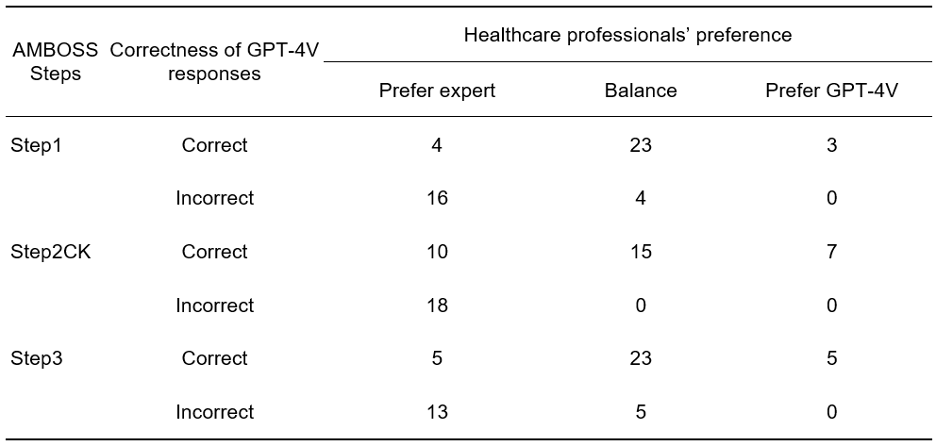

此外,作者们还收集了医疗专业人士的偏好,用以评估 GPT-4V 的解释是否违背医学常识。当 GPT-4V 做错的时候,作者们还收集了来自医疗专业人士的反馈,用来改善 GPT-4V。

用美国医学执照考试(USMLE)中包含图像的考题测试 GPT-4V。

准确性

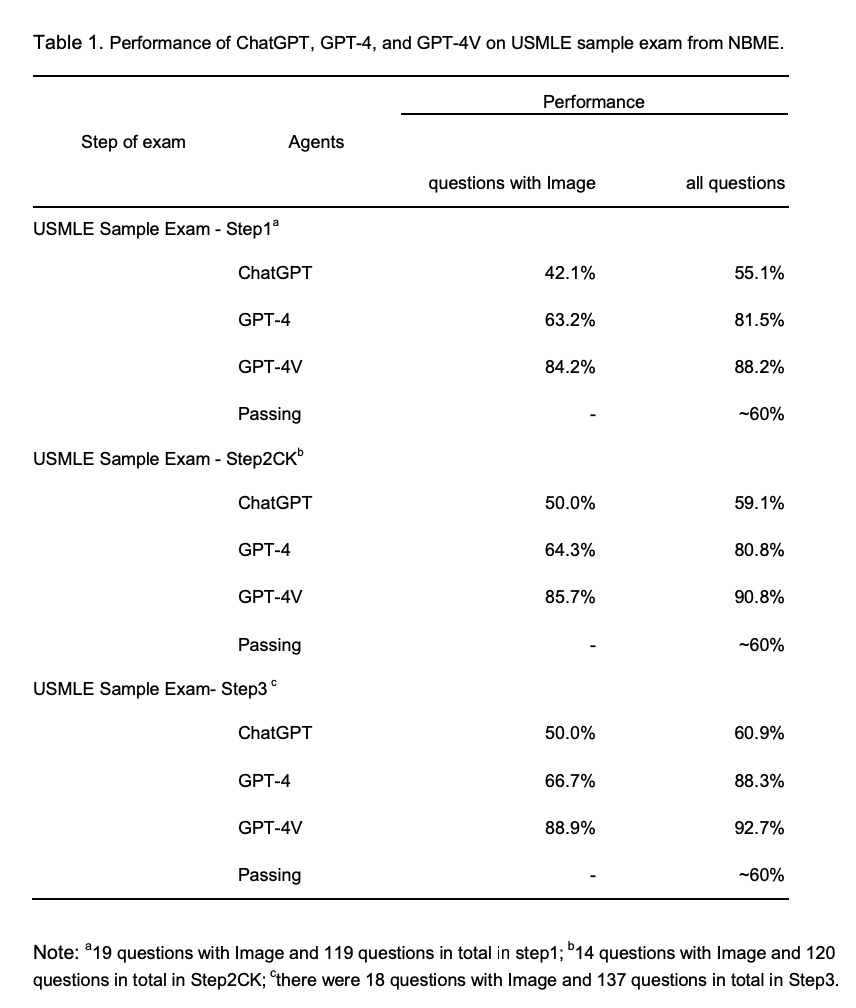

结果显示,GPT-4V 在带有图像的医学执照考试题上表现出了很高的准确率,分别在 USMLE、AMBOSS 和 DRQCE 上达到了 86.2%、62.0% 和 73.1%,远远超过了 ChatGPT 和 GPT-4。与准备考试的学生相比,GPT-4V 的大致排名能达到前 20-30% 的水平。

而在 2022 年,美国医学执照考试大约有前 90% 的考生通过了考试,这意味着 GPT-4V 想要获得通过,也相对较为轻松。GPT-4V 的准确率反映了它掌握大量生物医学和临床科学知识,也能够解决医患相处中遇到的问题。这些都是进入医学临床实践的必备技能。

GPT-4V在美国医学执照考试(USMLE)的测试表现远远超过了 ChatGPT 和 GPT-4。

在使用提示和不使用提示的情况下,GPT-4V在 AMBOSS的准确率分别为 86% 和 63%。随着问题难度的增加,不使用提示时GPT-4V的表现呈现下降趋势(卡方检验,显著性水平 0.05)。然而,当使用提示提问时,这种下降趋势并未明显观察到。这表明,来自医疗专业人士的提示可以很好的帮助GPT-4做出正确的决策。

GPT-4V 和学生在不同难度 AMBOSS 考试上的准确率

解释性

在解释质量方面,作者们发现,当GPT-4V回答正确时,医疗专业人士对GPT-4V给出的解释与专家给出的解释的偏好相差不大。这说明GPT-4V的解释具有可信度和专业性。作者们还发现,在GPT-4V的解释中,有超过80%的回答包含了对题目中图像和文本的解读,这说明 GPT-4V 能够利用多模态的数据来生成回答。

然而,当GPT-4V回答错误时,它的解释中也存在一些严重的问题,例如图像误解(Image misunderstanding)、文本幻觉(Text hallucination)、推理错误(Reasoning error)等,这些问题可能会影响 GPT-4V 的可靠性和可解释性。

针对每道考试题,医疗专业人员从专家生成的解释和 GPT-4V 生成的解释中选择偏好。考试分为 Step1, Step2CK, Step3 共 3 个阶段。每个阶段抽取 50 道题目进行测试。

作者发现许多GPT-4V回答错误的解释是图像误解。在 55 个错误回答中,有 42 个回答(76.3%)是由图像理解错误所导致的。相比之下,只有 10 个回答(18.2%)错误归因于文本幻觉。

针对图像误解,作者建议使用以图像或者文字为形式的提示。例如,医生可以用箭头指示图中重要的位置,或者用一两句话来解释图像的意义来提示模型。当医生使用文字提示的时候,就有 40.5% (17/42 个) 之前错误的回答被 GPT-4V 改正了。

辅助诊断的潜力

作者还展示了使用GPT-4V作为影像诊断辅助工具的可能性。基于一个高血压病人的病例报告,医生对GPT-4V进行提问。定性分析表明,GPT-4V能够根据 CT 扫描图像、化验单和病人症状等其他信息,提供鉴别诊断和后续检查的建议。详细分析请参考原论文。

也许很多人会想问:不久的将来,医生是否会像曾经的接线员、打字员、电报员一样,被科技发展所迭代彻底失去饭碗呢?

通过执业医师考试意味着什么?

美国执业医师资格考试属于标准化考试,通常完成第一部分,医学生就要花去300至400小时的专业学习时间,更别说另外涉及临床诊断、医疗管理以及实习实践内容的两部分。

2023年年初《科学公共图书馆·数字健康》上刊登了一篇文章,这篇名为《ChatGPT通过美国执业医师资格考试让人们注意到医学教育的缺陷》的文章中提出,ChatGPT的成功一方面反映医师考试过于强调机械记忆,对疾病机理死记硬背,“不能充分评估现代医疗实践所需技能”;另一方面反映医学教学方式僵化,易让学生误以为医学上的问题“非对即错”。

实际上,在临床上诊治疾病,医生一方面需要遵循诊疗规范,但另一方面还必须针对每个个体的具体情况,也就是个性化原则。因为每个病人的社会背景、家庭背景、传统习惯和经济条件及个人意愿等不同,面对同样的疾病,医生还需要考虑众多现实因素,才能做出带有个性化的人文关怀的治疗决策。有时病人对这些信息的流露只是透过一个细微表情,甚至只是交谈中叹了口气,“这些小动作都有可能会影响医生的治疗决策,但显然AI医生感知不了。”

尽管目前越来越多的研究表明,ChatGPT在医疗方面的合理概率越来越高,但它依然存在回答不合理的概率,这对严肃且关乎生命的医学领域可能就会造成不良的结果。

医生会因此失业吗?

更有乐观者展望未来,认为ChatGPT给患者看病指日可待。新西兰惠灵顿维多利亚大学软件工程高级讲师西蒙·麦卡勒姆(Simon McCallum)表示,随着技术不断发展,“我们可能很快会从AI医生处,得到医学方面的建议”。

事实上,现代医学以循证医学为基础,包括外部证据,医生个体经验和患者意图等多方面。临床中的“正确选择”含义丰富,既需要医生摒弃偏见、发挥创造力、展开批判性思考,也需要考虑众多现实因素。在这些方面,AI并无优势。

在实际的应用中,AI 的适配性也将面临长期的挑战。

英国林肯郡 NHS 系统医生史蒂夫表示,在英国的诊疗系统中,对于 AI 的使用一直保持着谨慎态度:「一方面我们的工作得益于 AI 工具产生的高效,一方面我们也忧虑着 AI 是否会造成数据泄露的风险。」

临床诊疗是一个繁琐的过程,从问诊治疗到康复随访,AI 的作用可能会在一个环节上发挥奇效,但并不是在每一个环节都有着颠覆性的作用。

如果 AI 真的取代了医生,万一出现医疗事故,我们追责是追究谁呢?是 AI 医生吗?还是说 AI 背后的工程师和设计者呢?值得深思!返回搜狐,查看更多

责任编辑: