中国战略新兴产业融媒体记者 艾丽格玛

“OpenAI可能会在2024年底破产。”

这则惊世骇俗的新闻在人工智能领域引起了大量的关注和讨论,它来自于一家印度媒体Analytics India Magazine的专栏作家Mohit Pandey的分析文章。一时间,“生成式人工智能如何持续变现”成为热门话题——毕竟,身为先行者的ChatGPT尚未成功,后发者和模仿者们也同样面临着同样的困境。

从风头无两,到身陷困境,生成式人工智能在今年历经烈火烹油、鲜花着锦之盛,又渐现颓势,各种“GPT”们又该怎样寻找出路?

“烧”钱无止境

70万美元,这是ChatGPT每天的平均运营成本。

根据公开数据,自从开始开发ChatGPT以来,截至今年五月,其亏损翻了一番,达到了5.4亿美元,而2022年它的收入却只有3000万美元。OpenAI首席执行官山姆·奥尔特曼,定下了今年营收2亿美元、明年营收10亿美元的目标,但随着后续GPT-5开发等相关工作的进行,亏损可能持续扩大。

ChatGPT的每月成本会受到多种因素的影响,因此并没有一个确切的数字。它的成本取决于模型规模、运算资源、数据处理、人力成本、维护以及其他因素。

OpenAI资料显示,ChatGPT训练一次13亿参数的GPT-3 XL模型每天需要的全部算力约为27.5PFlop/s,而训练一次1746亿参数的GPT-3模型每天需要的算力约为3640PFlop/s。运营和维护大型语言模型十分昂贵,每月成本可能高达几百万美元以上。它引以为傲的数十亿到数千亿个参数的深度学习模型,使它需要更多的计算资源和内存,从而增加了硬件和电力成本。

运行ChatGPT需要的高性能的GPU或TPU,其租赁费用以及电费成本都会在每月成本中占据重要比例。国盛证券估算,2023年1月平均每天约有1300万独立访客使用ChatGPT,对应芯片需求为3万多片英伟达A100 GPU,初始投入成本约为8亿美元,每日电费在5万美元左右。

除此之外,为了训练ChatGPT,需要大量的文本数据,在某些情况下,需要人工标记数据以进行训练,采集、清洗和处理这些数据可能会产生一定的费用。而为了持模型的稳定性、安全性和性能,需要有专业团队进行监视、维护和技术支持。

到目前为止,OpenAI“烧”的钱,仍然来自微软对它的投资,这使公司能够维持运营,但盈利却无从谈起。

而且,与微软这个自己“背后的东家”理念的分歧,也逐渐显露。

例如,最近,微软发布了Azure ChatGPT的GitHub存储库,直接在Azure平台上提供服务。一天后,该存储库被删除。

实际上,微软唯一通过OpenAI获得收入的方式是通过Azure OpenAI服务,因此希望将所有用户都转移到这个服务上,而不是免费提供ChatGPT给每个人。对于OpenAI来说,当然希望将所有用户留在自己的ChatGPT平台上。

但很显然,市场不需要“两个ChatGPT”。

在去年三月,微软还将Bing搜索与ChatGPT合并,用户达到了1亿。但实际上,OpenAI反对微软将不完整版本的GPT-4集成到Bing Chat中。

对于微软来说,如果ChatGPT只能在其Azure云和Bing上可用,利益就能最大化。在这一点上,两家公司之间显然存在分歧。

为何增长陷入瓶颈?

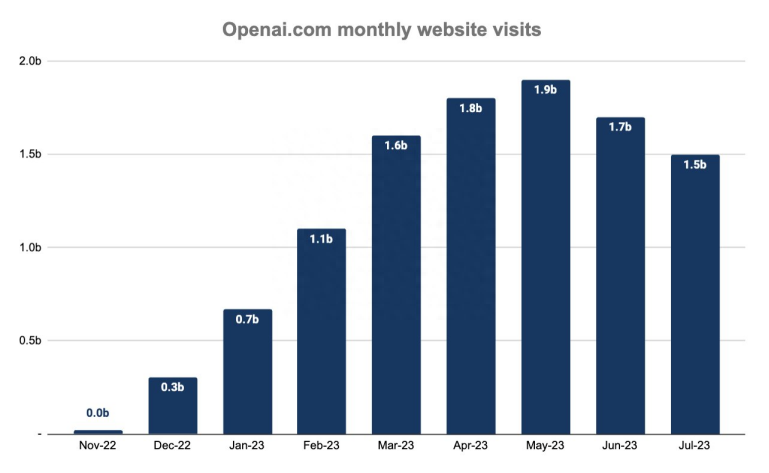

从今年5月到7月,ChatGPT用户数量已经连续两月下滑。

SimilarWeb数据显示,与6月相比,2023年7月的用户群减少了12%,从17亿用户下降到15亿用户。

有人猜测,用户数下降的一个主要原因可能是“API内部竞争”。也就是说,有很多相关公司禁止员工在工作中直接使用ChatGPT生成文本,但允许他们调取它的API,并在工作中使用。

但API也需要购买,并非开放的服务,这显然无法解释它亏损持续的原因。

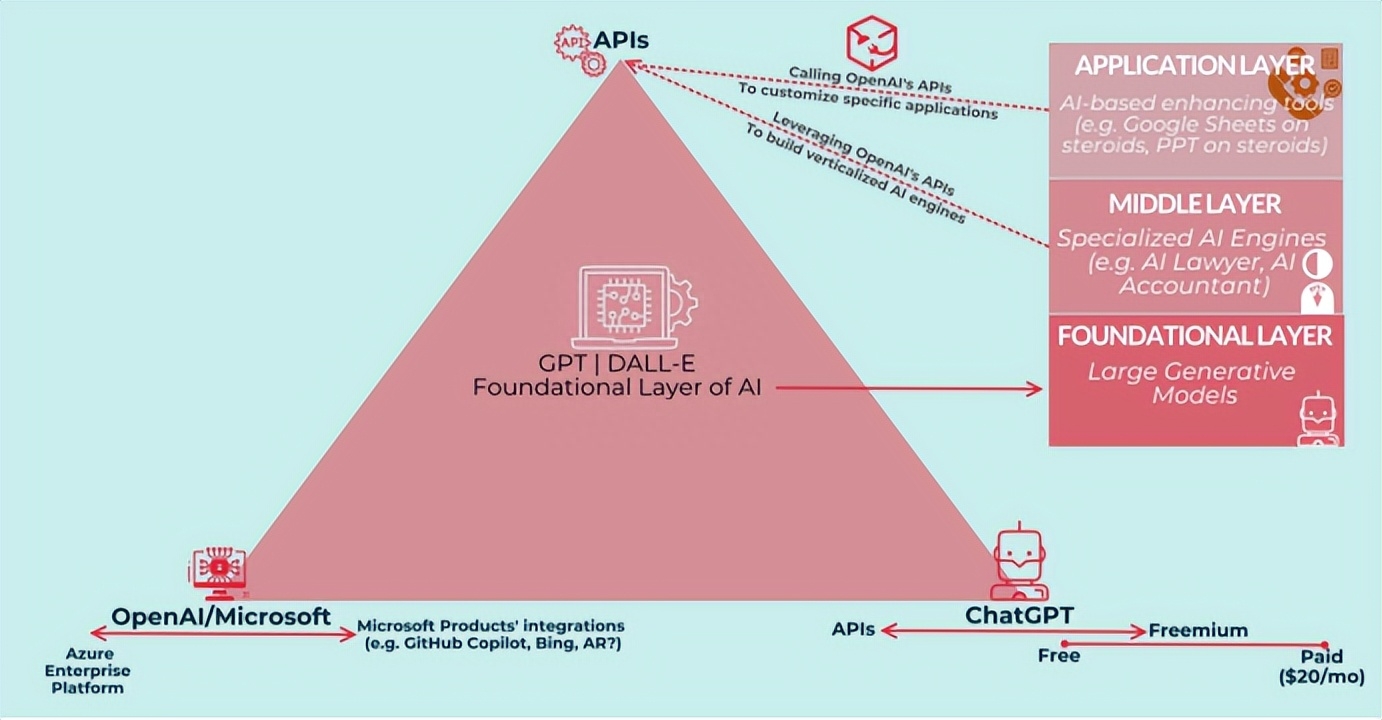

OpenAI采用了“平台业务模式”的战略。本质上,它充当了其他公司和服务构建的基础层。OpenAI与支持其的初创公司之间存在一种共生关系。换句话说,这些初创公司增长得越多,它们的计算需求就越大,对OpenAI平台的支出就更多。