文章主题:

随着以ChatGPT为代表的生成式AI兴起,其背后以大模型为基础的人工智能成为业界投入的方向。

🌟🚀掌握未来,只需一招!💡大模型,那可是AI领域的超级英雄,无需繁星点点的标注,就能凭借无尽的数据海洋,用自监督学习的独门秘籍,自我修炼成能适应各种挑战的大师级存在。🔍一旦训练完成,这些模型就像拥有魔法般,只需轻轻一调,或是少量数据的二次喂养,就能迅速适应新环境,为开发者带来创新的翅膀,轻松应对各类需求。🛠️无论是医疗诊断、自动驾驶,还是个性化推荐,大模型都能以高效且精准的方式,提供强大的技术支持,引领行业变革,实现真正的智能化。🚀拥抱大模型,就是拥抱无限可能!🌍#大模型 #自监督学习 #微调二次训练 #AI未来

🌟🚀人工智能现状揭示:”小模型”困境与高效挑战💡🔍当前的人工智能技术,尽管在特定场景中展现出强大的效能,却受限于模型的“专一性”,难以跨领域迁移,形成全能型解决方案。这就好比一个个独立的小工具箱,虽功能强大,但互换使用难度大,大大降低了研发的整体效率和成本效益。🚀🔍训练过程中的繁琐手工调参与海量标注数据的需求,就像给AI披上沉重的枷锁,既耗费资源又阻碍创新。每一步都需要精确到每一个细节,这无疑增加了技术进步的步伐,同时也对技术的普及设置了障碍。💡🛠️为了突破这一瓶颈,我们需要寻求更通用、可扩展的”大模型”策略,让人工智能能够像人类大脑那样灵活适应各种任务,实现真正的智能化升级。🚀🧠优化研发流程,减少数据依赖,推动AI向更高水平迈进,这不仅是科技的进步,也是经济发展的必然趋势。让我们期待一个更加智能且高效的未来!🌍💻

相比之下,大模型的改进可以使所有的下游小模型受益,大幅提升人工智能的使用场景和研发效率。

🌟 ChatGPT背后的强大引擎——GPT系列,正经历着惊人的技术跃进!每一版本的参数量都在以超乎想象的速度增长,这就像一场科技的马拉松,速度与规模并存。🔥 随着模型复杂度的加深,对大规模预训练数据的需求和成本也随之水涨船高,但这恰恰体现了其在人工智能领域的领先地位和不断进化的能力。🌍SEO优化提示:#GPT模型升级#ChatGPT技术革新#参数量爆炸式增长

国盛证券计算机分析师刘高畅、杨然在发表于2月12日的报告《Chatgpt 需要多少算力》中估算,GPT-3训练一次的成本约为140万美元,对于一些更大的LLM模型,训练成本介于200万美元至1200万美元之间。这一成本于全球科技大企业而言并不便宜,但尚在可接受范围内。

初始投入近十亿美元,单日电费数万美元

🎓投资分析🌟:ChatGPT的火爆,芯片需求直线上升!据统计,仅今年1月,每天就有约1,300万独立用户涌入这股AI浪潮,每分钟产生的数据量堪比一座小型数据中心。而这背后,GPU的需求量更是惊人,达到3万多片英伟达A100级别,其计算力不容小觑。初始的巨额投入,预计接近8亿美元,显示出技术革新带来的市场潜力。💡能源消耗面:随着业务的扩张,每日的电力开销也不容忽视,高达5万美元,这不仅是运营成本,也是对可持续发展的一种考量。🔥值得注意的是,ChatGPT的崛起不仅改变了通信方式,更引领了人工智能行业的全新革命。对于相关芯片制造商来说,这意味着巨大的机遇与挑战并存,如何抓住这一趋势,优化生产,将是未来的关键议题。🔍SEO优化提示:使用关键词如”ChatGPT、AI浪潮、GPU需求、技术革新、市场潜力、电力开销、可持续发展、人工智能行业”等,同时保持内容的连贯性和信息准确性。

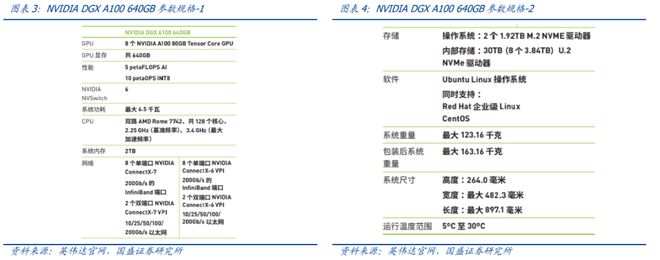

1)计算假设:英伟达A100:

根据OneFlow报道,目前,NVIDIAA100是AWS最具成本效益的GPU选择。

英伟达DGXA100服务器:

🚀💡超强大脑GPU阵列!🔍8枚A100芯片火力全开,AI计算能力震撼突破5万亿FLOPs/s!⚡️每台独享6.5kW峰值功率,科技与效能的极致碰撞!💰价格亲民,只需$19.9K,即可驾驭未来智慧浪潮!🏆立即锁定,开启AI新时代!🌐 #AI超级计算机 #高性能GPU #未来科技趋势

标准机柜:

🌟【超大规模计算】🚀 一台19英寸的42U服务器,相当于7个DGXA100的高效部署空间,每个模块价值不菲,达到140万美元。这套强大的数据中心阵列配备了56颗A100 GPU,GPU算力高达35PetaFLOP/s,堪称超算界的猛兽!💡最大功率输出为45.5kw,确保稳定运行的同时,也体现了绿色节能的设计理念。这样的高性能配置,无疑能提供前所未有的计算能力,满足最复杂的科学计算和大数据处理需求。📊欲了解更多详情或寻求定制解决方案,欢迎垂询,我们以专业和创新为您打造高效的信息生态系统。🌐

2)芯片需求量:每日咨询量:

2)芯片需求量:每日咨询量:

根据Similarweb数据,截至2023年1月底,chat.openai.com网站(即ChatGPT官网)在2023/1/27-2023/2/3这一周吸引的每日访客数量高达2500万。假设以目前的稳定状态,每日每用户提问约10个问题,则每日约有2.5亿次咨询量。

A100运行小时:

假设每个问题平均30字,单个字在A100GPU上约消耗350ms,则一天共需消耗729,167个A100GPU运行小时。

A100需求量:

对应每天需要729,167/24=30,382片英伟达A100GPU同时计算,才可满足当前ChatGPT的访问量。

3)运行成本:初始算力投入:

以前述英伟达DGXA100为基础,需要30,382/8=3,798台服务器,对应3,798/7=542个机柜。则,为满足ChatGPT当前千万级用户的咨询量,初始算力投入成本约为542*140=7.59亿美元。

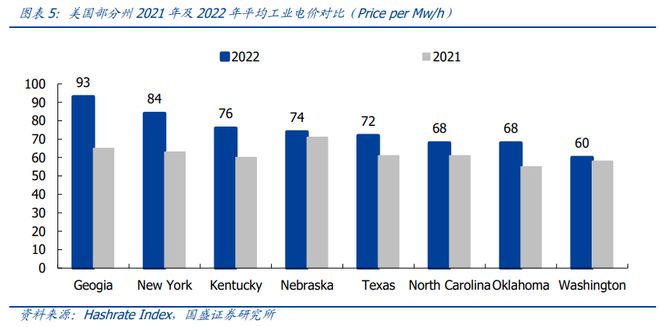

每月电费:

用电量而言,542*45.5kw*24h=591,864kwh/日。参考HashrateIndex统计,我们假设美国平均工业电价约为0.08美元/kwh。则,每日电费约为2,369,640*0.08=4.7万美元/日。

训练成本:公有云下,单次百万至千万美元

训练成本:公有云下,单次百万至千万美元

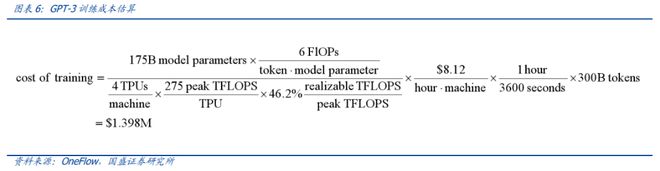

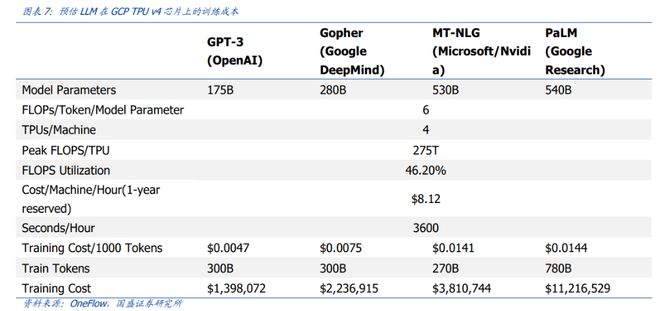

国盛证券基于参数数量和token数量估算,GPT-3训练一次的成本约为140万美元;对于一些更大的LLM模型采用同样的计算公式,训练成本介于200万美元至1200万美元之间:

1)基于参数数量和token数量,根据OneFlow估算,GPT-3训练一次的成本约为139.8万美元:每个token的训练成本通常约为6N(而推理成本约为2N),其中N是LLM的参数数量;假设在训练过程中,模型的FLOPS利用率为46.2%,与在TPUv4芯片上进行训练的PaLM模型(拥有5400亿参数)一致。

2)对于一些更大的LLM模型(如拥有2800亿参数的Gopher和拥有5400亿参数的PaLM),采用同样的计算公式,可得出,训练成本介于200万美元至1200万美元之间。

国盛证券认为,在公有云上,对于以谷歌等全球科技大企业而言,百万至千万美元级别的训练成本并不便宜,但尚在可接受范围内、并非昂贵。

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!