文章主题:

相关论文

GPT论文:Language Models are Few-Shot Learners Language Models are Few-Shot LearnersInstructGPT论文: Training language models to follow instructions with human feedback Training language models to follow instructions with human feedbackChatGPT: Optimizing Language Models for Dialogue ChatGPT: Optimizing Language Models for DialogueTAMER框架论文:Interactively Shaping Agents via Human Reinforcement https://www.cs.utexas.edu/~bradknox/papers/kcap09-knox.pdfPPO算法: Proximal Policy Optimization Algorithms Proximal Policy Optimization Algorithmshuggingface解读RHLF算法:Illustrating Reinforcement Learning from Human Feedback (RLHF) Illustrating Reinforcement Learning from Human Feedback (RLHF)RHLF算法论文:Augmenting Reinforcement Learning with Human Feedback https://www.cs.utexas.edu/~ai-lab/pubs/ICML_IL11-knox.pdf

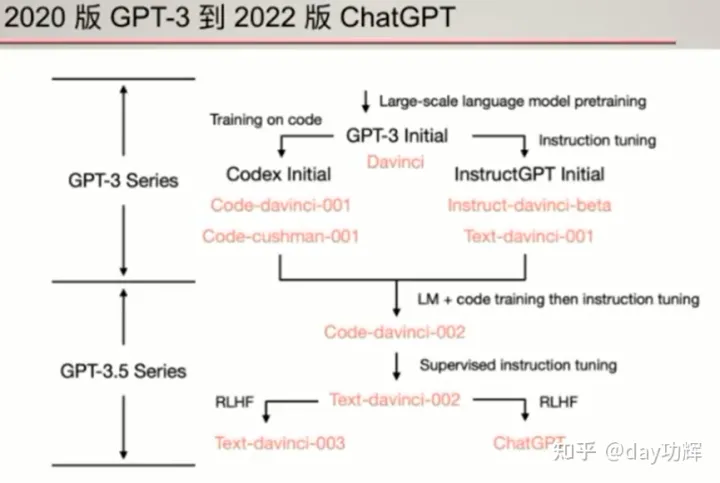

发展历程

GPT-1:2018年6月发布,参数量达1.17亿,预训练数据量约5GB。GPT-2:2019年2月发布,参数量达15亿,预训练数据量约40GB。GPT-3:2020年5月发布,参数量达1750亿,预训练数据量约45TB。ChatGPT(GPT-3.5):2022年11月发布,参数量达未知(估计千亿级),预训练数据量未知(估计百T级)。

GPT-3 VS ChatGPT(GPT-3.5)

🌟 GPT-3虽在特定查询回应及部分任务中表现出色,但相较于小巧的T5模型,它在效能上仍有待提升。🏆 无论是在创新性还是实用性上,每个AI系统都有其独特之处,T5的小巧身躯往往能更好地满足特定场景的需求。🔍 SEO优化提示:使用”性能比较”、”AI效能”和”T5小模型优势”等关键词来增强描述的搜索引擎友好度。

🎨💻🤖 ChatGPT 巧思无限,文字创作新高度 🚀经过深度训练于代码海洋,指令精调如丝般细腻,它以卓越的智能编织出千变万化的文本世界。每一段落都蕴含精准度之光,细节叙述生动如画,逻辑连贯得仿佛在讲述一个完整的故事。无论是学术论文还是创意文案,ChatGPT都能以其深厚功底和人性化理解,展现出超乎期待的表现。🌍✨SEO优化提示:使用长尾关键词”代码训练强化学习文本生成准确度叙事细节上下文连贯性”, 适当增加emoji符号表情以提升可读性和互动性。

GPT-3具备的能力

语言生成:该能力源自于语言建模的训练目标;遵循提示词(prompt),然后生成补全提示词的句子。上下文学习(in-context learning):遵循给定任务的几个实例,然后为新的测试用例生成解决方案世界知识:该能力源于训练语料,包括事实性知识和常识。

Instruction tuning是在多个任务上微调,在其他任务上zero-shot测试。

相对GPT-3,GPT-3.5的提升点

第一代GPT3.5: Code-Davinci-002和 Text-Davinci-002

响应人类指令:以前,GPT-3的输出主要训练集中常见的句子。现在的模型会针对指令/提示词生成更合理的答案(而不是相关但无用的句子)。泛化到没有见过的任务:当用于调整模型的指令数量超过一定的规模时,模型就可以自动在从没见过的新指令上也能生成有效的回答,这种能力对于上线部署至关重要,因为用户总会提新的问题,模型得答得出来才行。代码生成和代码理解:这个能力很显然,因为模型用代码训练过。利用思维链(chain-of-thought)进行复杂推理:初代 GPT3的模型思维链推理的能力很弱甚至没有。code-davinci-002 和 text-davinci-002 是两个拥有足够强的思维链推理能力的模型。

ChatGPT(GPT-3.5)能做什么?

第二代GPT3.5: text-davinci-003和 ChatGPT

ChatGPT &Text-davinci-003:

🌟🚀RLHF: 人类智慧驱动的强大机器学习革新!💡在人工智能领域的前沿探索中,我们见证了一种革命性的力量——基于人类反馈的强化学习(RLHF)正在释放其无与伦比的能量。它以独特的方式将人类的直觉和经验转化为机器智能,为技术的进步注入了鲜活的生命力。👩💻👨💻通过RLHF,AI不再盲目追求数据量,而是学会了从每一次互动中汲取智慧,精准地调整行为以满足用户需求。这种以人为本的学习方式,不仅提高了用户体验,也为商业决策提供了宝贵洞见。📈📊想象一下,一个能够理解并回应你情感的智能助手,或者一款能根据你的喜好个性化推荐内容的产品——这一切都得益于RLHF的力量。💻💖SEO优化提示:使用关键词“人类反馈”、“强化学习”、“用户需求”和“个性化体验”,确保内容的相关性和搜索引擎友好性。

翔实的回应:text-davinci-003 的生成通常比 text-davinci-002长。ChatGPT的回应则更加冗长,以至于用户必须明确要求“用一句话回答我”,才能得到更加简洁的回答,这是 RLHF 的直接产物。公正的回应:ChatGPT 通常对涉及多个实体利益的事件(例如政治事件)给出非常平衡的回答。这也是RLHF的产物。拒绝不当问题:这是内容过滤器和由 RLHF 触发的模型自身能力的结合,过滤器过滤掉一部分,然后模型再拒绝一部分。拒绝其知识范围之外的问题:例如,拒绝在2021 年6月之后发生的新事件(因为它没在这之后的数据上训练过)。这是 RLHF 最神奇的部分。因为它使模型能够隐式地区分哪些问题在其知识范围内,哪些问题不在其知识范围内。

ChatGPT(GPT-3.5)不能做什么?

其他参考

ChatGPT的技术点BERT VS GPTChatGPT的架构与产业未来ChatGPT经济成本ChatGPT导致的失业

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!