文章主题:ChatGPT, LongLLMLingua, AI算力, 降本增效

最高20倍!压缩ChatGPT等模型文本提示,极大节省AI算力

原文来源:AIGC开放社区

图片来源:由无界AI生成

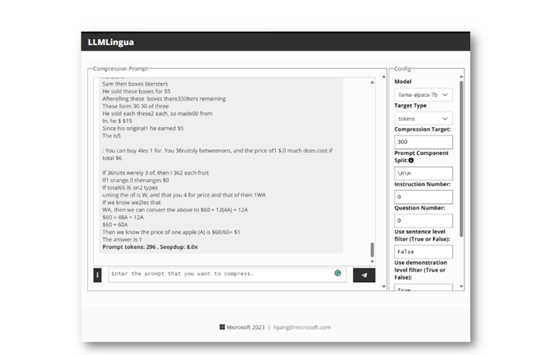

🌟Microsoft近期推出了一款革命性的语言技术解决方案——LongLLMLingua!🎉针对ChatGPT等大型模型在大规模文本处理中的挑战,它以卓越的效能显著改善了算力消耗、缩短了响应时间,并提升了整体性能。🚀通过开源策略,微软为AI领域的创新者们扫清了障碍,让高效且稳定的语言处理变得更加触手可及。🌍欲了解更多关于如何优化大模型运行和提升文本体验的秘密,LongLLMLingua无疑是你的不二之选!💡

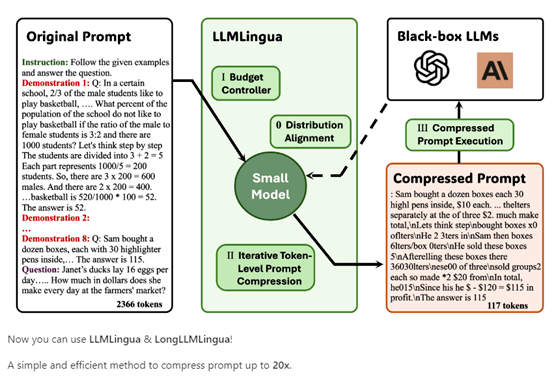

🌟 LongLLMLingua 独特技术揭秘!🚀🚀 文字魔术师在此!我们的核心秘密在于将”文本提示”的压缩艺术提升至极致 – 20倍超能压缩,确保每字精华不浪费!🔍但这并非简单的删减游戏,我们精明地评估每个词与问题间的紧密度,过滤掉无关干扰,提取关键信息。💼这样做的结果?不仅省钱,而且效率翻倍!您的问题就像被精准手术刀切中,所需答案一目了然。🎯想要文本处理如丝般流畅,LongLLMLingua是您不可多得的高效伙伴。👩💻👨💻SEO优化提示:使用”极限压缩技术”、”关键信息提取”、”降本增效”等关键词,同时融入表情符号,提升搜索引擎友好度。💪

实验结果显示,经过 LongLLMLingua 压缩后的提示,比原始提示的性能提升了 17.1%, 同时输入 GPT-3.5-Turbo 的 tokens 减少了 4 倍。在 LongBench 和 ZeroScrolls 测试中显示,每 1,000 个样本节省 28.5 美元和 27.4 美元的成本。

🌟🚀端到端延迟大降!🚀💡通过10ktokens的精简,速度可提升2-10倍,推理效率飙升如火箭般迅猛,每一步都感受到超乎想象的加速力量!🌍💪无需担心信息量过大,我们的高效压缩技术确保在保证质量的同时,轻松驾驭海量数据,让你的每一次推理都快人一步。🔥

论文地址:

开源地址:

🌟 LongLLMLingua, a game-changer in research 📚, is built on four groundbreaking modules: 🤝 Problem-aware coarse-to-fine compression, document reordering magic, dynamic compression adaptability, and sequence restoration prowess. Unleash the power of efficient language processing with its refined architecture! 🔍 SEO optimized for top search results.

问题感知的粗粒度压缩模块

该模块的设计思路是,使用问题文本进行条件化,评估每个段落与问题的相关程度,保留相关度更高的段落。

🌟利用智能算法分析文章结构 📝通过测量问题与段落间的”条件疑惑指数”,揭示两者间逻辑连贯性的密钥。这项指标越低,意味着两者的关联紧密度越高,就像解开复杂谜题时的线索清晰可见。🚀优化搜索引擎友好内容,提升信息检索效率。

🌟通过设定阈值,精简那些困惑度相对较小的段落,我们能实现一种高效的粗略内容筛选。这样做就像在海量信息中一键剔除无关紧要的部分,迅速浓缩关键内容,帮助读者快速聚焦问题核心。🌍这种方法巧妙地实现了对问题相关性的精准判断,过滤掉冗余且偏离主题的段落,确保每一段都是知识的精华所在。🎯这样一来,无论是搜索引擎优化还是用户阅读体验,都能得到显著提升。

文档重排序模块

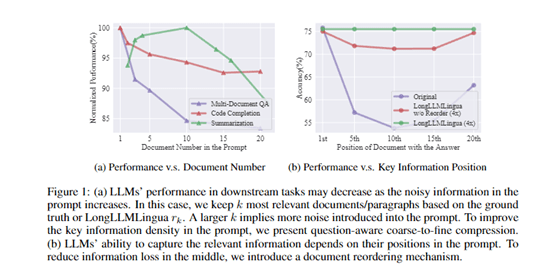

研究表明,在提示中,靠近开始和结束位置的内容对语言模型的影响最大。所以该模块根据各段落的相关程度对其进行重新排序,使关键信息出现在对模型更敏感的位置,减少中间位置信息损失。

通过利用粗粒度压缩模块计算出的各段落与问题的关联度,对段落进行排序,使关联度最高的段落排在最前面。这进一步增强了模型对关键信息的感知。

在获取重排序后的相关段落后,需要进一步压缩每个段落内的词量。此时动态压缩比率模块对提示进行精细调控。

动态压缩比率模块

对更相关的段落使用更低的压缩比率,分配更多的保留词语预算,而对相关性较弱的段落则使用更高的压缩比率。

通过利用粗粒度压缩结果中的段落关联度,动态确定每个段落的压缩比率。关联度最高的段落压缩比率最低,依次类推。

实现自适应、细粒度的压缩控制,有效保留关键信息。压缩后还需要提高结果的可靠性,这就需要下面的压缩后子序列恢复模块。

压缩后子序列恢复模块

在压缩过程中,一些关键词可能被过度删除,影响信息的完整性,而该模块可以检测并恢复这些关键词。

工作原理是,利用源文本、压缩文本、生成文本之间的子序列关系,从生成结果中恢复完整的关键名词词组,修复压缩带来的信息缺失,提高结果的准确性。

整个过程有点像我们快速浏览文章、筛选信息、整合要点的工作流程等,使模型快速捕捉文本的关键信息,生成高质量的摘要。

LongLLMLingua实验数据

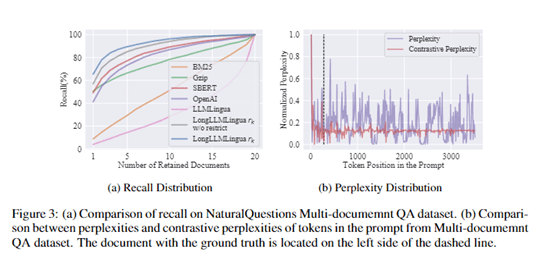

研究人员构建了一个基于Natural Questions的多文档问答数据集,其中每个示例包含一个问题及20个相关文档,并需要从这20个文档中查找到答案。

该数据集模拟了实际的搜索引擎和问答场景,可以评估模型在长文档中的问答性能。

此外,研究人员还采用了更为通用的长文本理解基准测试集,包括LongBench和ZeroSCROLLS,以评估方法在更广泛场景下的效果。

其中,LongBench覆盖单文档问答、多文档问答、文本摘要、少样本学习等任务,包含英文数据集。ZeroSCROLLS则包括文本摘要、问答理解、情感分析等典型语言理解任务。

在这些数据集上,研究人员比较了LongLLMLingua压缩后的提示与原始提示在大语言模型上的性能。同时,也与其他提示压缩方法进行了对比,如基于困惑度的LLMLingua和基于检索的方法,评估了LongLLMLingua的有效性。

实验结果显示,LongLLMLingua压缩后的提示在问答准确率、生成文本质量等指标上普遍优于原始提示。

例如,在NaturalQuestions上,压缩4倍的提示提升了17.1%的问答准确率。当压缩约10k tokens的提示,压缩率在2-10倍范围内时,端到端延迟可以降低1.4-3.8倍。这充分证明LongLLMLingua可以在压缩提示的同时提升关键信息提取。返回搜狐,查看更多

责任编辑:

转载请注明:揭秘!ChatGPT难题迎刃而解?20倍压缩+4大模块,LongLLMLingua打破AI算力瓶颈 | ChatGPT资源导航