文章主题:

AIGC“尖峰系列” | 源码“聊天人”:正经回答关于源码的“一切”

为什么ChatGPT有时候会一本正经的胡说八道?

为什么它明明“知道”自己错了,却依然在错误的答案上一路狂飙?

它自信满满又错漏百出的数学,真担心会带坏吃瓜群众啊!

在一个加班的夜晚,源码小伙伴们正在交流AIGC开源模型之后带来的应用创新浪潮,此时,有人提到:为什么我们不能自己先做一个呢?电光火石的瞬间,灵感迸发。

先进团队,先研发/生产/使用先进生产力工具。

于是,源码的技术同学们开始大量、反复、不厌其烦地研究、调试和训练。现在,我们隆重推出这款“可能是世界上能最准确回答和源码有关的十万个为什么的”AI应用:源码“聊天人”(对,数字化部门研发的太快,品牌部门还没来得及起名,文章最后,请你投票或留言,决定“聊天人”的真名!)

通过这款应用,你可以多快好省地了解到关于源码的一切;而源码的同学,则相当于有了一个可以打通并整合内部资源和信息库的工作小助理。

真是太棒了!

不过,怎么解决我们一开篇提到的问题呢?

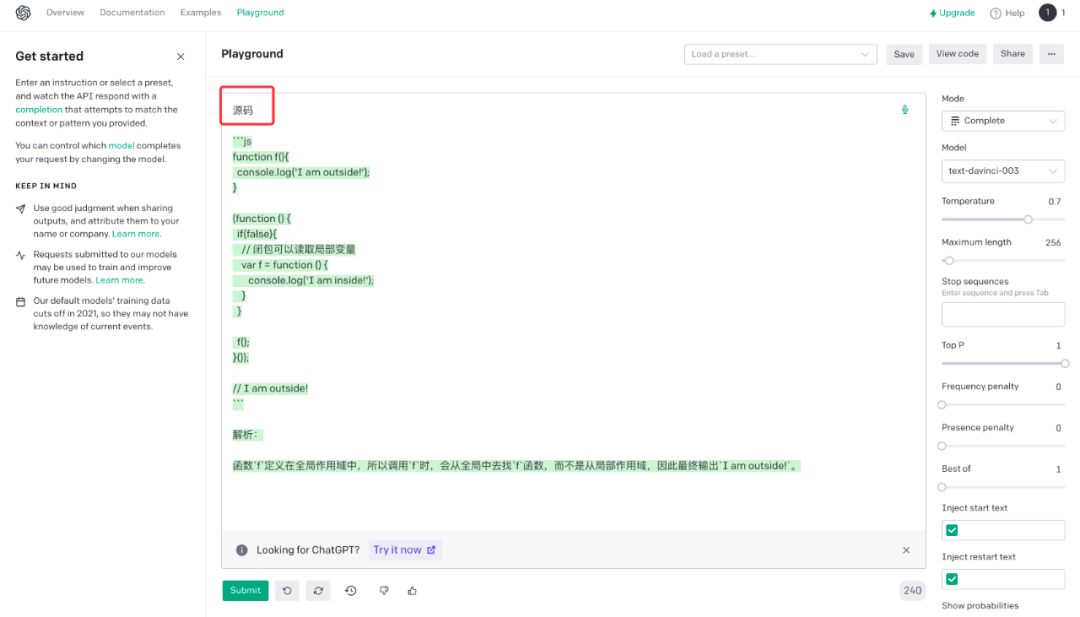

ChatGPT背后的大模型本身是续写,如果不进行Prompt和特别的训练,它也许其实不知道自己要干什么。

比如只让它续写“源码”,它很随机的写出了一段“源码”。

但如果我们能提供更多专属资料“喂给”模型,结果就会完全不同:

Prompt是最低成本的调教ChatGPT的方法,也不需要finetune。但是Prompt的内容长度是被严格限制的,也就是说我们不能无休止的喂它内容:过多的内容,反而会让ChatGPT迷惑,给出错误的结果;太长的Prompt ,ChatGPT也会拒绝服务。

如果我们通过一些工程和算法手段,将最合适的内容喂给ChatGPT,那么就能够发挥它的最大能力。

源码的技术同学们开启了对ChatGPT对话生成结果的可靠性的探索和研究,希望能够让ChatGPT这个智能工人能够在听懂话的前提下,产生安全、准确、可靠的内容结果。

而如何在企业,尤其是源码这样数字化做的很好的头部投资企业的成千上万、甚至百万规模级别的信息库中,选择合适的内容喂给背后的模型,就是一个巨大的挑战。

源码小伙伴最终选择基于Facebook/Meta Research团队的Faiss稠密向量检索工具,结合语义模型对公司内部大量信息进行了embedding处理。确保Prompt的内容,始终是最贴合用户语义的。

Faiss是由Meta(FaceBook)AI团队开源的库,用于在高维空间中针对海量的稠密向量进行近似近邻检索的可靠方案,被广泛用于各种相似性检索场景中。

Faiss是由C++编写,支持使用GPU或CPU运行,能够支持十亿级别向量的快速检索。

技术同学们为ChatGPT定制开发了源码限定的信息处理模块,通过附加多个语义模型和信息处理引擎,能够让ChatGPT在接收Prompt指令前,预学习必要的知识,让ChatGPT在生成结果后,也进行必要的内容安全检查和调整,确保输出内容都是正常、安全的。

在这个过程中,为了能及时提供最新、最全面的信息,技术同学还实现了部分内部系统与机器助手的连接。

技术团队的小伙伴还在尝试用OpenAI的embedding能力和模型finetune能力进一步优化模型,新的迭代版本也将不日上线。

下面,就跟我们一起来跟源码“聊天人”玩耍吧!

为什么源码资本,叫源码资本?

源码似乎喜欢黑白色系?

源码的“心向辽阔,探索不熄”有什么含义?

来点挑战性的吧,源码如何看待AIGC?

有点意思,源码还有什么亮点,你挑个重点说说?

那么,怎么才能找到你?

责任编辑:

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!