来源:微信公共图片库

近期,ChatGPT的发展经历了一系列的考验:

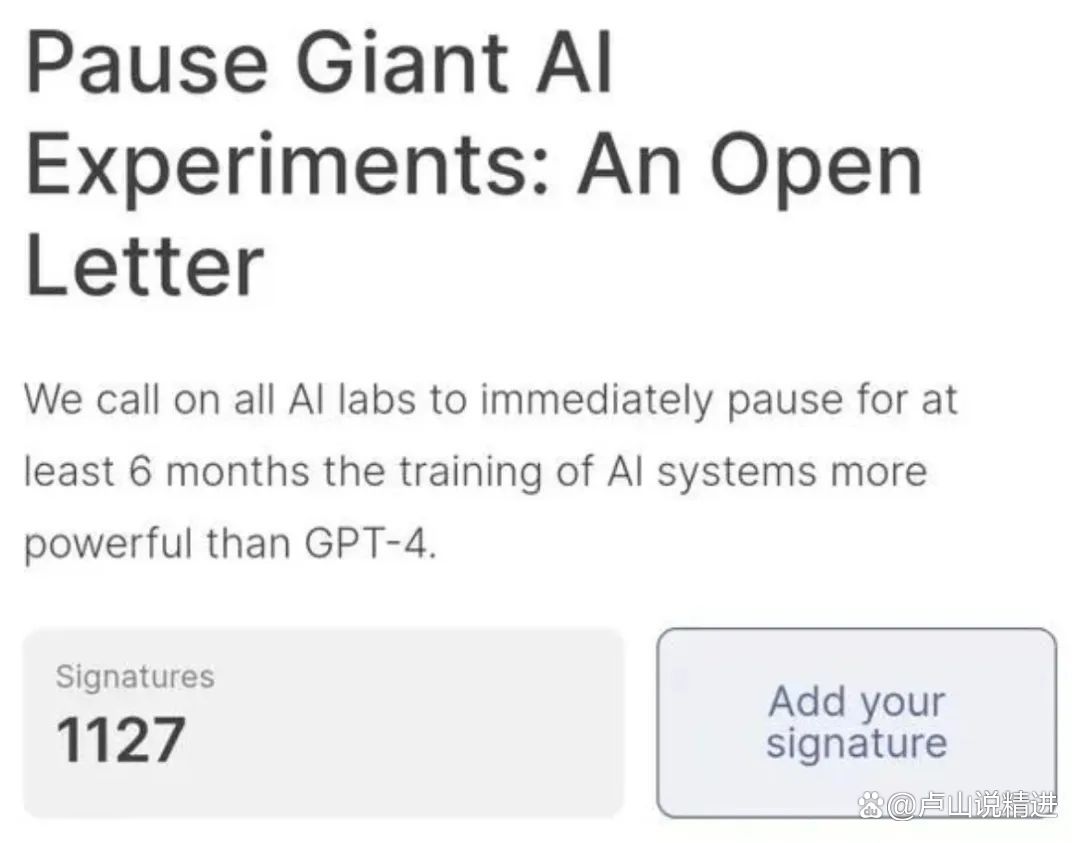

上千名科学家联名发表公开信,呼吁所有AI实验室立即暂停训练比GPT-4更强大的AI系统,为期至少6个月,以确保人类能够有效管理其风险。关键是签署公开信的有一众大佬,比如,图灵奖得主、深度学习三巨头之一约书亚·本吉奥,曾是Open AI大金主和联合创始人的埃隆·马斯克,《人类简史》作者尤瓦尔·赫拉利,苹果联合创始人史蒂夫·沃兹尼亚克等等;

来源:futureoflife

欧洲刑警组织发表了一份题为《ChatGPT-大型语言模型对执法的影响》的报告称,ChatGPT可能被滥用于网络钓鱼、宣传虚假信息以及网络犯罪,这加剧了外界对这一新兴事物在法律、道德等方面的担忧。

来源:ChatGPT, the impact of Large Language Models on Law Enforcement

意大利个人数据保护局宣布,从3月31日起禁止使用ChatGPT,限制其开发公司OpenAI处理意大利用户信息,并开始立案调查。OpenAI公司非法收集用户个人数据,且没有设置年龄验证系统防止未成年人接触非法材料,将采取限制措施“直到ChatGPT尊重隐私”。

西班牙数据保护局AEPD宣布对ChatGPT的潜在数据泄露问题展开初步调查。法国监管机构CNIL也宣布,在收到多起针对ChatGPT的投诉后,他们也决定展开调查。

而欧盟方面也宣布,将成立专门工作组,计划将ChatGPT视为高风险的AI系统进行监管,目的是让欧盟各国都重视起来自AI的威胁。

很快,为了回应来自官方和民间的各种质疑,Open AI在其官方博客上发表了一篇文章,题为《我们对于人工智能安全的方法》,副标题是:确保人工智能系统的建立、部署和被安全地使用对于我们的使命至关重要。

开篇第一句有点像OpenAI的使命宣言:我们致力于确保强大AI系统的安全和让人们广泛受益。

随后,它强调自己的AI工具为世界各地的人们提供了许多好处,比如,帮助他们提高工作效率,增强他们的创造力,并提供量身定制的学习体验。同时,他们也认识到,像任何技术一样,这些工具也会带来真正的风险,因此他们努力确保该系统在各个层面的安全性。

接下来,OpenAI从“构建安全系统、改进保障措施、保护儿童、尊重隐私、提高事实准确性、持续研究和参与”六个方面进行了阐述。第一人称“我”指的是OpenAI官方。

【1】构建越来越安全的人工智能系统

在发布任何新系统之前,我们都会进行严格的测试,邀请外部专家提供反馈,采用强化学习等技术改进模型的行为,并构建广泛的安全和监控系统。

例如,在最新的模型GPT-4完成训练后,我们花费了6个多月的时间在组织内部开展工作,以使其更加安全和合规,然后才公开发布。

我们认为,强大的人工智能系统应该接受严格的安全评估。需要制定法规来确保采用这种做法,并且我们积极与政府合作,探讨这种法规的最佳形式。

小编:在公众场合,OpenAI一直在呼吁政府和专家参与到监督监管人工智能的发展中来。

另外,据说史上最强的GPT-5已经测试完毕,原定于今年年底发布。不过有了上述一系列的事情和OpenAI作出的反应,不知道GPT-5是否还能如期上线。

【2】从实际使用中学习,以改进保障措施

在部署之前,我们努力防止可预见的风险,然而,我们在实验室中所能学到的东西毕竟有限。尽管进行了广泛的研究和测试,但我们无法预测人们使用我们技术的所有有益方式,也无法预测人们如何滥用这项技术。这就是为什么我们相信,随着时间的推移,从现实世界的实际使用中学习是创建和发布越来越安全人工智能系统的关键组成部分。

我们小心翼翼、按部就班地向更广泛的人群发布新的人工智能系统,并在吸取经验教训的基础上不断改进。

我们通过自己的服务和API提供最强大的模型,这样开发者就可以将这项技术直接构建到他们自己的应用程序中。这使我们能够监测并对滥用行为采取行动,并不断构建缓解措施,以应对人们滥用我们系统的真实方式,而不仅仅是从理论上进行想象。

现实世界中的实际使用也促使我们制定了越来越细致的政策,反对那些对人们构成真正风险的行为,同时仍然允许我们的技术以更多有用的方式被使用。

至关重要的是,我们认为社会必须有时间来调整和适应日益强大的人工智能,而且每个受到这项技术影响的人都应该在人工智能如何进一步发展方面拥有自己的发言权。迭代部署帮助我们将各类利益相关者引入到关于采用人工智能技术的对话中,而拥有这些工具的第一手使用经验显然十分重要。

小编:其实,除了AI可能会被滥用的风险,比如,别有用心的人利用GPT大规模制造和传播虚假信息,或者GPT被利用进行有杀伤力的网络攻击等等之外,还有一个更大的系统性的风险:连ChatGPT的创造者们都不知道,这种通用大模型在疯狂进化过程中,到底会产生出什么样的能力和能量。

在接受ABC News独家采访中,主持人问Open AI 首席技术管 Mira:对于ChatGPT,你最担心的安全问题是什么?

Mira回答:这是一种非常通用的技术,当你拥有如此通用的东西时,很难事先知道它所有的能力、潜在影响以及它的缺陷和局限性。

通用大模型似乎正在迎来技术奇点。这是人类社会尚未经历过的,尚未经历的就是未知,未知就蕴含着不可预测的风险。

360创始人周鸿祎更是直言:人工智能在未来2-3年将具有自我意识,然后它将毁灭人类。

【3】保护儿童

我们安全工作的一个关键重点是保护儿童。我们要求用户必须年满18岁(或经父母批准年满13岁)才能使用我们的人工智能工具,并正在研究验证功能。

我们不允许我们的技术被用于生成仇恨、骚扰、暴力或成人等类别的内容。与GPT-3.5相比,我们的最新模型GPT-4对受限内容请求做出响应的可能性降低了82%,我们已经建立了一个强大的系统来监控滥用行为。GPT-4现在对ChatGPT Plus的用户开放,我们希望随着时间的推移让更多的人也能使用它。

我们已经做出了巨大的努力,尽量减少我们的模型产生伤害儿童内容的可能性。例如,当用户试图将儿童安全虐待材料上传到我们的图像生成工具时,我们会拦截并将其报告给国家失踪与受剥削儿童中心。

除了我们默认的安全护栏,我们还与非营利机构可汗学院等开发者合作,为他们量身定制安全缓解措施。可汗学院开发了一个人工智能助手,既可以充当学生的虚拟导师,也可以充当教师的课堂助手。我们也在开发更多功能,这些功能将允许开发者为模型输出设置更严格的标准,以更好地支持需要这些功能的开发者和用户。

小编:GPT-4已经可以识别图像,估计人脸识别应该不是问题了。如果能够把人脸识别和访问权限之间做个互动,倒是个不错的做法。

另外,人工智能助手充当的虚拟导师也可以主动教孩子们如何更好地保护自己。

【4】尊重隐私

我们的大型语言模型是在广泛的文本语料库上进行训练的,这些文本语料库包括公开可用的内容、获得授权的内容以及由人工审核人员生成的内容。我们不使用数据来销售我们的服务、做广告或建立人们的档案,而是为了让我们的模型对人们更有帮助。例如,ChatGPT通过与人进行更多对话来改进自己。

虽然我们有些训练数据中包括在公共互联网上可以获得的个人信息,但我们希望我们的模型了解世界,而非个人层面。因此,我们努力在可行的情况下从训练数据集中删除个人信息,微调模型以拒绝对有关个人信息的请求,并响应人们从我们的系统中删除个人信息的请求。这些措施将我们的模型生成包含私人个人信息的响应的可能性降至最低。

小编:一方面,我认为OpenAI关于“…从训练数据集中删除个人信息,微调模型以拒绝对有关个人信息的请求,并响应人们从我们的系统中删除个人信息的请求…”的举措是行之有效的,而且效果正在显现:

ChatGPT3的时候,你问关于马斯克的个人隐私信息时,它都直言不讳。但是ChatGPT3.5就已经开始拒绝回答了。

另一方面,GPT的训练数据除了来自互联网,也来自每天的人机对话中。在很大程度上,如何识别、处理和引用人机对话中的信息,包括隐私信息可能更加重要。

【5】提高事实准确性

如今的大型语言模型基于它们之前看到的模式(包括用户提供的文本输入)来预测接下来的下一系列词汇。但在某些情况下,下一个最可能出现的词汇实际上可能并不符合事实。

因此,提高事实准确性正成为OpenAI和许多其他人工智能开发商的一个重要关注点,我们正在取得进展。通过利用用户对被标记为不正确的ChatGPT输出的反馈作为主要数据来源,我们提高了GPT-4的事实准确性。与GPT-3.5相比,GPT-4生成事实性内容的水平提高了40%。

当用户注册使用该工具时,我们会尽量做到透明,以免ChatGPT可能提供错误回复。然而,我们认识到,要进一步降低幻觉的可能性,并教育公众了解这些人工智能工具目前的局限性,还有很多工作要做。

小编:和第四点一样,“…对被标记为不正确的ChatGPT输出的反馈作为主要数据来源”的举措是有效的。

同时,这里有两个关键点:

一个是“用户”群体是否足够大?足够大才能更有效和有效率地纠正错误信息。这让我想起了一款在美国非常好用的躲避拥堵的app——Waze。它是由社区驱动,收集用户的地图数据和其他信息,并学习用户的驾驶时间,提供路线和实时路况更新的应用程序。这个原理和维基百科类似,都是通过放手发动群众来建设美好“家园”的。

另一个是,这些用户的辩错和纠错能力怎么样?如何确保用户的“纠正”是正确的。

【6】持续研究和参与

我们认为,解决人工智能安全问题的一个切实可行的方法,就是投入更多的时间和资源来研究有效的缓解和校准技术,并针对现实世界可能被滥用情况进行测试。

重要的是,我们还认为,提高人工智能的安全性和能力应该齐头并进。迄今为止,我们最好的安全工作就是与我们能力最强的模型合作,因为它们更善于遵循用户的指示,更容易被“引导”。

我们将越来越谨慎地创建和部署功能更强大的模型,并将随着人工智能系统的发展继续加强安全预防措施。

虽然我们等了6个多月才部署GPT-4,以更好地了解其功能、好处和风险,但有时可能需要更长的时间来提高人工智能系统的安全性。因此,政策制定者和人工智能提供商将需要确保人工智能的开发和部署在全球范围内得到有效监管,这样就没有人会为了领先而寻找捷径。这是一项艰巨的挑战,需要技术和制度创新,但我们渴望为此做出贡献。

解决安全问题还需要广泛的辩论、实验和参与,包括为人工智能系统的行为设置界限。我们已经并将继续促进利益相关者之间的合作和开放对话,以创建一个更安全的人工智能生态系统。

小编:随着个性化定制AI成为可能,AI工具被滥用的风险就会大大增加。与诸如核武器这样的大杀器不同的是,核武器只有极少数人能接触到,而诸如ChatGPT这样的人工智能工具是面向大众的,因此其带来的复杂度不言而喻。

正如OpenAI 创始人Sam Altman接受ABC News采访时说的:“ChatGPT将是人类迄今为止开发的最伟大的技术。”

希望我们能善待它,它也能善待我们。

来源:OpenAI官网,微信公共图片库

>>>END<<<