课代表立正B站视频博主(经授权转载,仅代表作者个人观点)

我们判断,如果ChatGPT不犯大错,两年内,对整个科技行业甚至人类社会都可能影响深远。倒计时已经开始了。我排一个两年后ChatGPT能做到的事情以及可能性:

1、专家级回答事实性的问题(99%);

2、专家级回答判断性的问题(80%);

3、每个人的数字学徒(75%);

4、把编程提效十倍(70%) — 小团队半年时间就能开发3A级别的游戏;

5、直接要求结果(50%);

6、替我打工(50%);

7、写出一篇这样充满原创知识的文章(5%);

这里再打几个比方,这几个比方是尽量准确,而不带误导的:1、iPhone是人体传感器和功能器官的延伸,ChatGPT是人脑的延伸,只有互联网、浏览器、iPhone等少数发明能和ChatGPT的颠覆性比肩;

2、过去的计算机只能“模拟”,ChatGPT可以“理解”;

3、ChatGPT之于过往机器学习,是后膛枪之于弓箭手,意义不在于两者的性能对比,而在于热兵器的时代已经开启,并且发展是加速度的;

4、ChatGPT是“自然语言计算机”,是人类调用数据与算力的近乎完美的形态;

5、ChatGPT会让“智力分发”的边际成本趋近于零,人力资本的杠杆变得无限大;

6、所有系统与数据库都值得被ChatGPT重做一遍;

7、ChatGPT应该关注理解能力的构建。

但是上述的结论和比方,在看完全文之前,都没什么用,因为我们不知道是真是假。如果对ChatGPT到底是什么不了解,那就只能比谁说话更语出惊人、更金句,而不是谁判断更准确、更有洞见。所以我们要花巨大的功夫,写出这篇文章,让大家知道我们知道什么,不知道什么。

GPT-4在3月15日震撼发布了,但是本文观点、推演、结论不需要任何大改,因为对技术的理解是准确的,对能力范围的理解与推演也是准确的。其实文章并不是对GPT-4和能达到的事情有任何“预测”,而只是“简单推演”。所以就不重新修改了,对比现实,正好能让大家看清楚什么是天天变化的,什么是不变的。

哪五个问题?

在ChatGPT纪元中,提问题的能力和判断力也许是人类最重要的两个能力。我们这里提出五个关键问题,并且试图抛开网络上的二手观点,做出基于原理的判断。围绕这五个问题,我们会把所需要知道的相关技术背景,尽量简洁但是无损地总结清楚,不说废话:

1、是什么:ChatGPT是范式突破,还是过往AI的延伸?

2、会怎样:ChatGPT两年内会达到什么水准?

3、行业格局:ChatGPT以及GPT有壁垒吗?

4、如何参与:我们未来应该如何使用ChatGPT?

5、人文:人类和ChatGPT的本质区别是什么?对人类社会的冲击?

我们搞清楚这五个问题,就能判断市面上大多数解读ChatGPT的观点,无论从技术、商业、投资等等角度,是否靠谱了。其实就两个关键:

1、对ChatGPT新能力的认知:这新能力到底是什么,有多大“不一样”?那个“不一样”能带来多少新的可能性?

2、对“能力获取难度”的认知:ChatGPT如何获得的?别人获取类似能力,难度有多大?

文章结尾我们会做一下总结。让你下次见到某大模型,可以判断这是ChatGPT的80%还是0%。也可以判断自己的工作会被ChatGPT取代多少。

为什么这样问?

最近到处都在讨论ChatGPT,但是对于ChatGPT这样一个人类高科技结晶的新物种,不先搞清楚它“是什么”和“为什么厉害”,那就没有办法形成自己的判断。没有自己基于原理的判断,看ChatGPT就像看元宇宙、Web3、自动驾驶一样,觉得好像很厉害,也有一套看似自洽的逻辑,以及振聋发聩的“洞见”,其实只能被别人牵着走。

搞清楚ChatGPT“是什么”和“为什么厉害”是一件困难的事情,因为最顶尖的人工智能大佬们也没有达成共识。比如Meta的AI负责人,深度学习三大佬之一的LeCun就不看好,认为这就是个基于auto-regressive(自回归)的LLM(large language model,大语言模型),从方法上来讲没有啥范式突破。只是因为OpenAI是个创业公司,大家宽容度比较高,ChatGPT在乱说话,大家也能容忍。

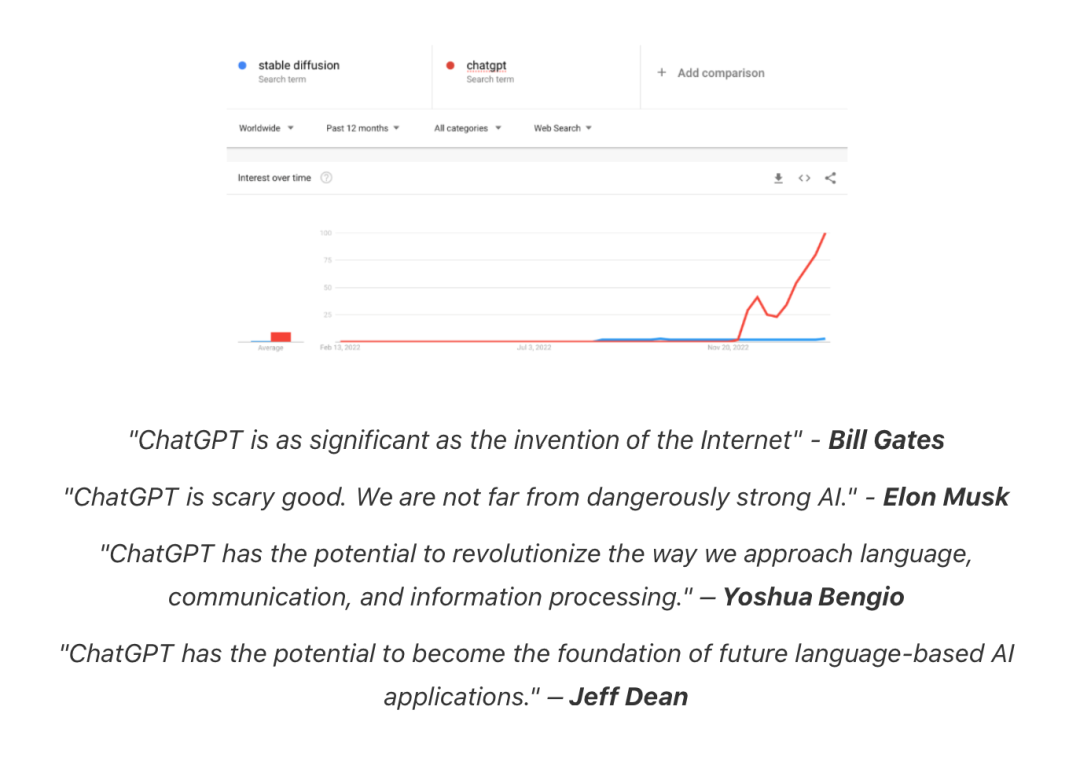

另一面,ChatGPT的火热就不说了,比如特斯拉的首席AI科学家就选择回到OpenAI,共建AGI(artificial general intelligence,通用人工智能,也是OpenAI的追求目标);Meta的VR创始人卡马克选择离开Meta,自己开一家AGI公司。另外一篇文章[1]截取了大佬们的赞誉神奇的点就在于,双方也许都是对的。ChatGPT的确不是一个“新的模型”,而是即有模型的发展与组合;但ChatGPT又足够不一样,让包括我在内的很多AI相关的从业者,有第一次见到光的感觉。我们在第一章会花大篇幅去讲一下为什么ChatGPT的原理是填词,但它的新能力却远远不是“填词”而已。

技术插播:“自回归”“大语言模型”是两个关键词

1、自回归的意思是,我先用模型预测下一个词是什么,然后把预测出来的词带入模型,去预测再下一个词是什么,不断迭代。这是过往语言模型的通用范式,也能让各类语言类任务统一成“生成式”任务。

2、大语言模型的大是指海量参数,从而能吸取海量数据中的信息。这是在transformer模型之后成为可能的。大语言模型本身也值得技术科普一下,我们在第一个问题中展开。

ChatGPT的最基本版历史

开始问问题之前,有一些必要的技术科普。我们着重参考两篇综述,尽量抓重点:

1、大语言模型技术精要[2]

2、ChatGPT的各项超能力从哪里来[3]

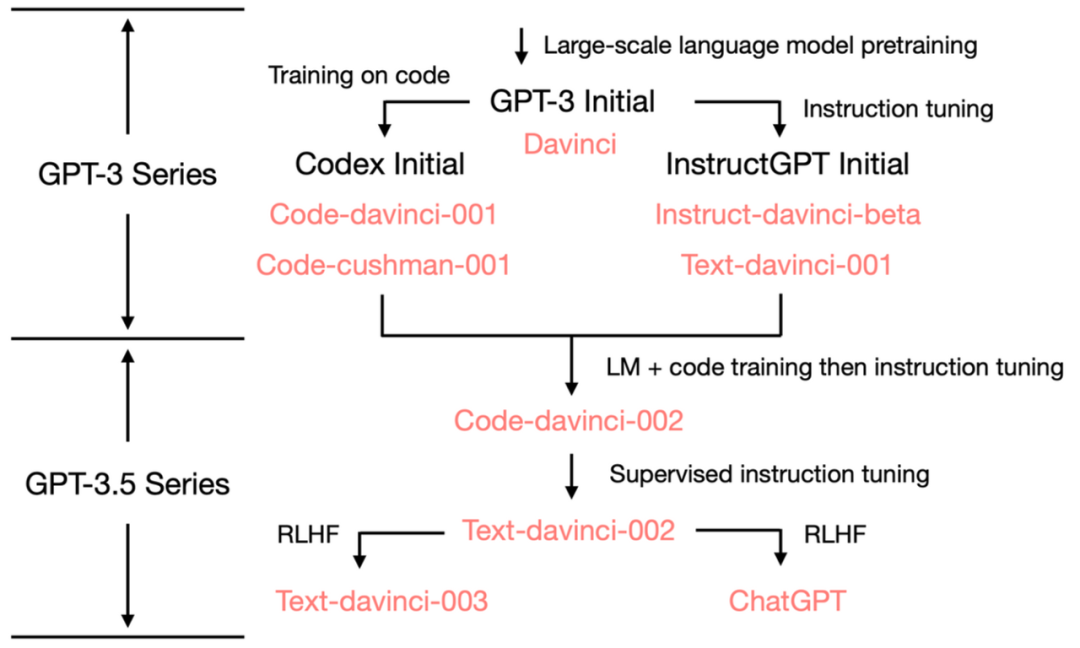

第一份综述主要讲了大语言模型发展中的关键技术突破,第二份综述主要讲了ChatGPT发展过程中的几个重要模型“做到了什么”和“有什么与众不同的做法”。我们把两篇文章的重点挑出来,标注一下里程碑事件和其意义。事件

意义

Transformer问世让深度学习模型可以“自由吸收”数据中的知识

大语言模型突破了参数和算力限制,从此语言模型也进入参数越多,数据越大,模型效果越好的时代。

LLM内战,逐渐吊打老NLP

Google的Bert路线和OpenAI的GPT路线各有所长

GPT通过“自然语言生成任务”,兼容了几乎所有NLP问题;但是Bert比GPT2表现好。此时大语言模型已经开始吊打传统NLP模型了

GPT3问世

展示in-context learning能力,简单调教下就能吊打精调过的很多模型

一方面让GPT模式初现一统江湖的潜质,一方面GPT3的 in-context learning能力,展示了和过往ML的fine-tuning模式的本质区别,我们在下面单独详细展开

– InstructGPT

ChatGPT的交互模式,让GPT的能力,更加贴近人类真实交互方式

在in-context learning基础之上,进一步降低了prompting的门槛;一定程度解决了GPT-3生成结果与用户期望不一致的非预期输出,大幅降低了有害的、错误或偏差的输出结果,让GPT更符合人类胃口

– GPT读代码

代码训练能力的提升是GPT3到GPT3.5的重要迭代之一,模型从而可以生成代码和“理解”代码

Codex模型读了大量代码,之后的GPT3.5模型涌现出了“乌鸦”的能力(第一问详解)。不光能读懂和生成代码,对语言本身的理解和推理能力也解锁了

– RLHF

ChatGPT背后的核心技术之一,让模型学习人类的偏好

全称是reinforcement learning from human feedback,通过构建人类反馈数据集,训练一个reward模型,模仿人类偏好对结果打分,是GPT-3后时代LLM越来越像人类对话的核心技术

ChatGPT

InstructGPT的亲戚,但一些优化方式也带来了ChatGPT的更泛化和准确能力,再次引爆了AIGC

ChatGPT总体来说和InstructGPT一样是使用RLHF进行训练,但模型是基于GPT3.5,而且数据设置上也不同。ChatGPT是一个输入,模型给出多个输出,然后人给结果排序,让模型可以学习人类的排序策略,即使是一本正经的胡说八道看起来也很合理的样子。

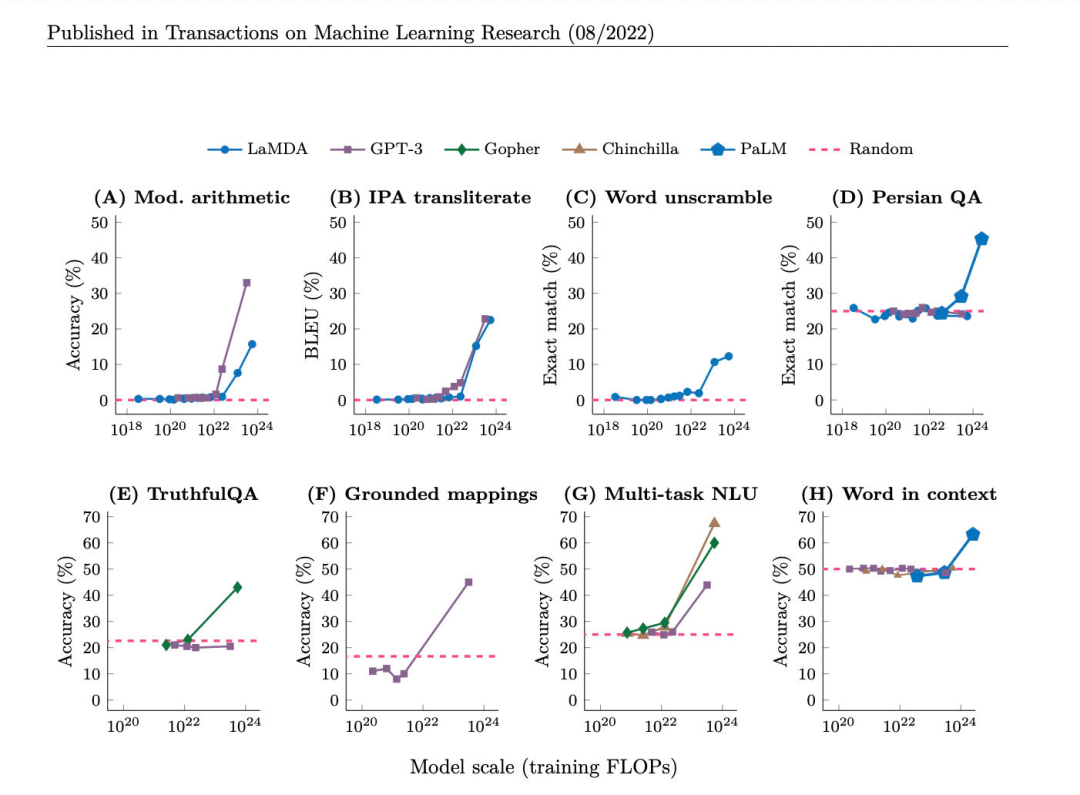

这里面再强调一个关键点。GPT-3之后,很多能力是“涌现”的,即不是线性发展、可预测的,而是突然就有了。至于这对于OpenAI的人是早晚会发生,还是完全未预料,我们就不知道了。这几个“涌现”出的能力,尤其是“乌鸦”的能力,是ChatGPT和过往AI的范式不同,也会是我们这次讨论关注的重点。“涌现”也是大语言模型很神奇的一点,这些能力我们发现模型随着数据量和模型大小的提升,就突然具备了,但是我们对这些能力怎么出现的,只有猜想,没有共识。这篇文章[4]有一个比较全面的总结和比较。 GPT-3到ChatGPT的演变历史

GPT-3到ChatGPT的演变历史

如何分辨真假ChatGPT

结合上面的图和表格,我们简单梳理一下:

1、GPT-3是一个非常令人惊艳的LLM,这个两年半前的播客有当时early-adopter的视角,但GPT-3还勉强属于“量变”,到现在,也不是最厉害的LLM[5]。

2、GPT-3.5通过InstructGPT的模式 + 阅读代码,涌现了“乌鸦”能力,产生了质变。但是还没找到合适的应用界面,也不符合人类喜好。

3、ChatGPT在RLHF的帮助下,找到了GPT-3.5和人类自然语言的合理接口,解锁了模型应用的前景。

各LLM能力涌现路径

所以我们要记得,厉害的模型是GPT-3.5,厉害的应用方式是ChatGPT。应用方式相对很容易复制,RLHF有难度但也不太难,真正难的是“乌鸦”能力的复现。如果我们要关注能不能做出来ChatGPT,要关注的是各家LLM离GPT-3.5的“乌鸦”能力有多远,在一个没有乌鸦能力的LLM上套一个ChatGPT的应用方式,只是东施效颦。

这里说“应用方式相对容易复制”,但是不意味着这个应用方式不够颠覆。iPhone出现时,很多人也只是觉得没有什么颠覆技术,只是个不错的集成方案[6]。但那些人没看到的是,iPhone是第一个“为了适应人而设计的智能手机”而非“为了解决问题而设计的智能手机”[7]。iPhone的交互方式和各种传感器,让iPhone慢慢变成了人类的身体的一部分,一个带来更多信息,高效交互的器官。ChatGPT已经接近目前人类调用算力和数据的最终极形态了,其应用方式本身当然是足够厉害的。我们在第二问,ChatGPT会取代哪些工作里,详细展开。

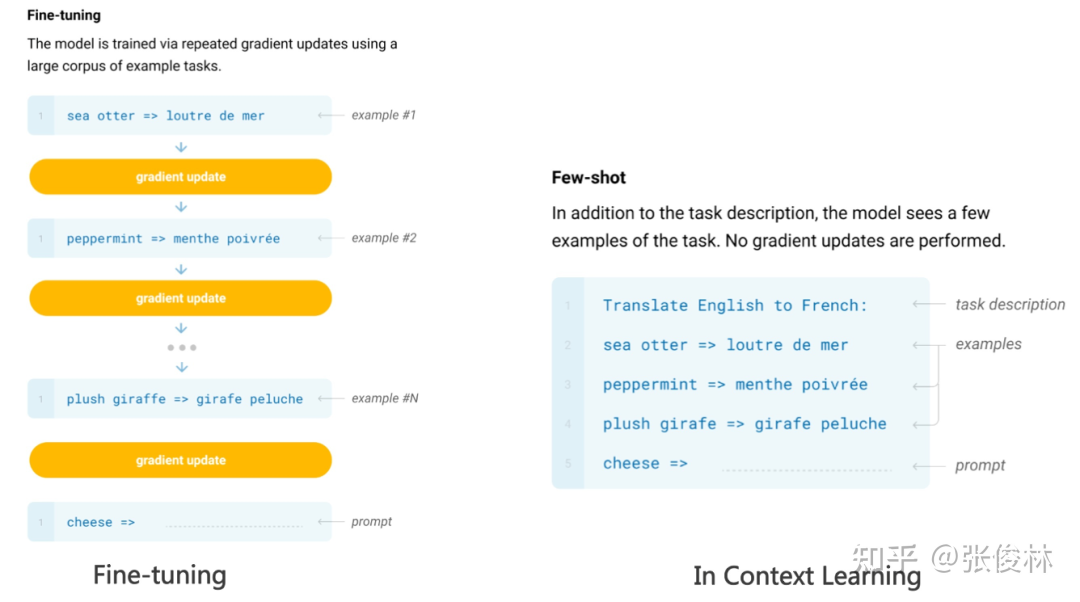

这里也牵涉到了一个重要的题外话,我们在讨论中发现,很多资深AI从业者,如果不去深究LLM的细节,而是用过往经验猜想ChatGPT的能力来源时,会产生严重的错误理解。我们总结了一下,发现这误解大概是发生在in-context learning和instruct这一模式,和过往模型调教有什么区别上,尤其是对“fine-tuning”这个词的理解上。

重要的题外话 — AI从业者为什么对ChatGPT有错误理解?

过往的NLP模型是按照具体任务和具体数据来训练的。所以数据质量越好,模型效果越好。而且最好只有正确数据,没有错误数据。大语言模型有一个重要不同,是“数据越多”越好,而数据质量变成了重要,但稍显次要因素。

在一开始,大模型想要在特定任务上取得较好效果,也需要那个领域的具体数据去“fine-tune”一下。通过大量的例子,先教给模型,那个领域中什么是好,什么是坏,调节一下模型的权重,从而输出恰当的结果。这和过往模型的范式是差不多的。这样的应用明显非常有局限。每做一些新的事情,或者数据分布有明显变化,都要重新训练一遍模型。而新事情和新数据无穷无尽,模型就只能刷新。但是模型的刷新也可能导致过去做得好的事情突然做不好了,进一步限制了应用。

而GPT-3涌现出的in-context learning能力(现在其他大模型也有,比如Google的PaLM,同时不确定GPT-3是第一个涌现的,希望得到指正)和上述范式有本质不同,“过往的fine-tuning”需要更改模型参数,也就是说,换了个新模型。但是in-context learning,模型并没有变化,却能在新数据上表现更好。研究甚至发现,你给大模型一堆范例,只要对应关系整体是对的,这时候改变具体对应的顺序,大模型仍然能输出正确的结果。这真的很神奇。再重新强调一遍,模型没有变化,没有被重新训练,但是能“理解”新数据,并且表现更好。

接下来还有更神奇的。在GPT-Codex版本解锁了推理能力,以及InstructGPT提出了instruct这一方法,他们合体的ChatGPT在in-context learning的基础之上,展示出了具备理解、推理、演绎能力的样子。我们在下一章详细展开。

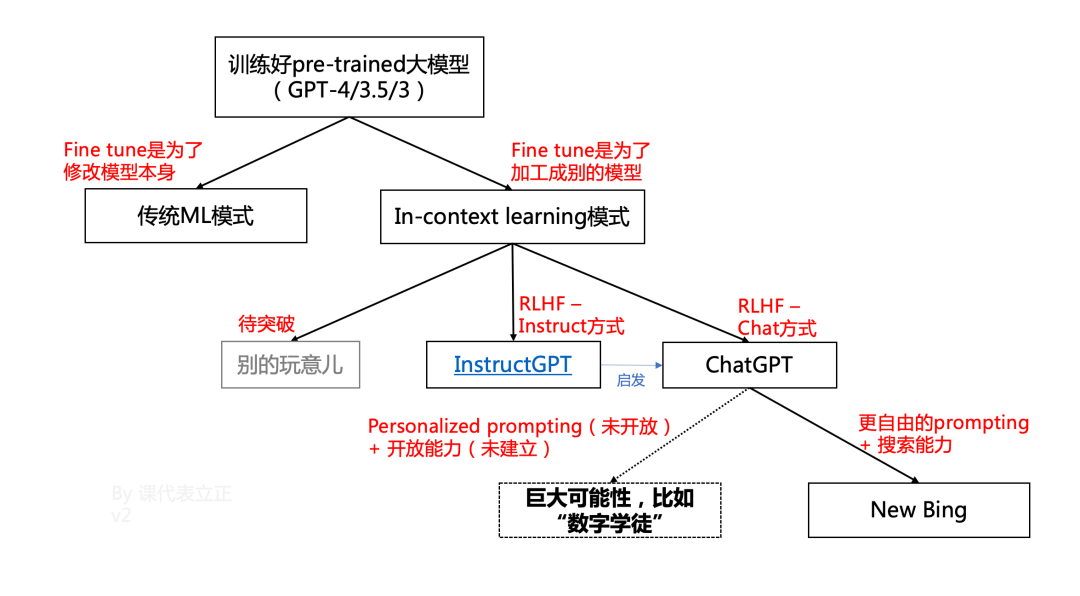

一个重要的关系图

我做了一副图来表示他们的关系(3.16迭代成V2)。注意几点:

1、过去的ML的“fine tune”,“数据飞轮”,本质是为了迭代模型本身,用新模型解决新问题。

2、而pre-trained大模型的关键思路是用大模型来解决所有问题。模型本身不变化。

3、虽然InstructGPT和ChatGPT改变了大模型的参数,但是:

是「加工」,而不是「迭代」是「激活」了GPT-4的部分能力,而不是「赋予」GPT-4任何新能力是人类偏好「对齐」,而不是去「训练」GPT-4

4、New Bing是「基于ChatGPT范式下」做到的。我们对ChatGPT颠覆能力的绝大多数推演,仅来自于「把给New Bing的接口开放给公众」。甚至都没讨论其他突破的可能性。

ChatGPT是范式突破吗?

机器学习发展了这么多年,遵循同一个范式。哪怕2016年大火的AlphaGo,也完全没有脱离这个范式 — 鹦鹉学舌。

1.1 过往机器学习的范式 — 鹦鹉学舌

机器学习,包括深度学习,所遵循的范式是“data fitting”,即找到数据中的“对应关系”并应用。具体来说,就是Y=f(X),给定一些优化目标,机器学习寻找X和Y的对应关系,来优化一个特定的方程。对应关系找得好,让我们在见到一个未知的X‘的时候,也能根据规律,总结出Y‘是什么,能最好达到设定的目标。

从信息论的角度,这样的范式,所能总结的规律,应该是在“已有X所包含信息的范畴之内”。换句话说,遇到一个新的X‘,虽然没见过,但是应该和过去的X长得差不多。用图像识别举例,如果模型只在小狗小猫的数据上训练过,是无法区分马车和汽车的。

这就很像鹦鹉学舌的机制。鹦鹉是不知道那段话的意义的,它用自己的方式去理解了这个发音,并且模仿了出来。计算机能更加精准地进行控制和编程,配合其他模块能力,就能让“寻找对应关系”这个能力,发挥更大作用,比如:

1、图像识别 + 搜索,就能高效找人

2、Matrix completion + 用户数据收集,就能高效推荐

3、把游戏规则恰当转化为优化方程 + 问题的局部抽象 + 自己生成对局训练,就能下围棋

举例:推荐算法的原理想象一个矩阵,横着是不同的人,竖着是不同的短视频,格子里是这个人对这个短视频的兴趣指数,我们要想方设法填满这个格子,给每个人推荐最感兴趣的短视频核心问题是在每个人都没看过99.9999999%短视频的情况下,这题怎么解有很多种方式,传统的运营、策略,也是一些方式。现有算法的主要做法是1. 把每个视频抽象成特征2. 把每个人抽象成特征3. 通过特征对特征的方式进行泛化和填表,如果用人来理解的角度,可能是中年男人喜欢看钓鱼(内容+画像推荐)你同事们喜欢看老板点赞过的视频(关系链)看过AB的人喜欢看C(collaborative filtering)但是记得,模型抽象出来的特征是适合机器理解,而不是适合人类理解的。用人类能描述的方式去描述机器的优化,注定是降低效率的

由此可见。过往AI应用的拓展主要是来自几点:

1、高质量的数据,模型的发展,算力的提升,让模型越来越准、快、和发现更多更深的“对应关系”,能进行更好的优化;

2、更好地把商业问题转化为优化问题;

3、和其他能力的深度结合;

但是这些都是基于“鹦鹉学舌”这一范式的。过往的NLP(natural language processing,自然语言处理)就是一个很好的例子。发展了那么多年,语音助手能根据指令来达成一些目标,但是从来都没有真的“懂”那些指令。过往的NLP只能做“填表”,必须背后有一个人设定好具体的任务,规划好如何把语音或者文字形成固定的function,该function如何调用相应的能力。如果没有人提前规划,那模型就无法实现。这篇文章[8]总结的非常好,这里就不赘述了。

1、亚马逊Alexa的思路和大多数商业语音助手的思路就是招一群程序员来写if then,高情商说法是针对具体使用场景做深度优化。这里有总结。[9]

2、谷歌的思路是用一个大模型做底座,一堆小模型做输入,另一堆小模型做输出。这条路也遇到明显瓶颈。

归根结底,离开了“懂”的能力,鹦鹉的设计师,是很难穷尽世界上所有的语言应用组合的。说这么多,是为了告诉大家,“懂”这件事,是过往AI梦寐以求都想突破的瓶颈。

“懂”字,如果深究的话,会发现大家对它的定义其实存在很大分歧。我如果让狗狗伸手,狗狗伸手了,是“懂”吗?过去NLP的懂和ChatGPT的懂,又有什么区别呢?同样的问题存在其他词汇中,比如理解、推理、演绎、创新,等等。所以想要真的抓住ChatGPT新能力的本质,描述就要更加精确和具体。

华人最厉害的AI学者之一,朱松纯教授,在2017年有一篇思考人工智能和智能本质的文章,[10]开篇所举的例子,就非常深刻、精确、具体地抓到了这一本质。我这里复述一下。这篇文章80%的价值,可能就在这一个例子上。

1.2 ChatGPT可能的新范式 — 乌鸦

下面是原文,介绍了乌鸦是如何“感知、认知、推理、学习、和执行”的:

总结一下,城市中的乌鸦通过观察,自主串通了:1、汽车能压碎坚果;2、红绿灯能控制汽车;3、车能撞死我;

总结一下,城市中的乌鸦通过观察,自主串通了:1、汽车能压碎坚果;2、红绿灯能控制汽车;3、车能撞死我;

这三件事情,从而利用红绿灯和汽车,来帮自己达到“安全打开坚果”这一任务结果。

如果类比成机器学习模型,过往“鹦鹉学舌”范式的解法,是要求所有乌鸦可以共享一个大脑,它们有很清晰的优化目标,即“保住性命的前提下打开坚果”。它们的方式是,随机尝试所有事件的组合,并向着最优解的方向不断演化。

但现实世界的乌鸦无法共享大脑,也不能去冒着死亡风险去尝试所有可能。乌鸦只有一次机会,把观测到的两个现象,产生了一个新的可能性,并应用在一个全新的场景下。这里最接近的词汇可能是“inference”,是“基于证据和逻辑推演,得到结论”的过程,有的时候,还要加入很多猜测、抽象、泛化。举个例子,这篇文章把朱教授对于乌鸦的比喻,跟ChatGPT最本质的能力联系起来,就是在做inferencing这件事。

但很明显,inferencing不是乌鸦智能的全部。而且在机器学习领域里,inferencing特指使用训练好的深度学习模型来预测新的数据这一件事,会产生误解。其他词汇也有类似问题,所以我们在自己文章里,会直接使用“乌鸦能力”来指代ChatGPT的新能力。在对外交流时,我们没办法每次都把乌鸦能力是什么解释一遍,所以我们会用“理解”能力来进行指代。从“乌鸦”到“理解”,当然是一个信息量损失很大的过度概括。但是好处是可以把ChatGPT的本质能力凸显出来。过往互联网的两次能力跃进一次来自于搜索,一次来自于推荐,现在ChatGPT带来了“理解”,也非常有结构感。

1.3 ChatGPT看似拥有乌鸦能力的证据

之所以说“看似”,是因为我们并不知道乌鸦为什么会有和鹦鹉不一样的能力,我们也不完全知道LLM为什么会有“乌鸦”的能力。甚至朱教授本人在AAAI 2023上明确说了,不认为LLM/ChatGPT具备乌鸦能力,而是一只巨鹦鹉。

这个观点是我和朱教授/LeCun不一样的地方。我的观点是,我们未必要“理解原理”才能做判断。换句话说,我们并不知道乌鸦为什么有“智能”,不知道人类为什么有“智能”。我们哪怕确定自己有智能,也不知道对面那个人是不是真的有智能,而不是一个模拟的NPC。这是一个贯穿哲学史上的「他心问题(The problem of other minds)」,我就不过度展开了。

总之,哲学家告诉我们,我们在现实生活中永远无法真的确认其他人是否有智能,但是不妨碍我们生活。所以纠结LLM是否真的有智能,很可能不重要。我们知道的是,(1)LLM激活“智能”的方式一定与人类和乌鸦不一样;(2)人类智能也是受到语言限制而非与生俱来的。所以我们不把话说死,只说看似拥有,不确定真的拥有。为了节省笔墨,我们接下来就不说“看似”了。

我的结论停留在,ChatGPT从表现上来看,具备了一定程度,但远超过往ML范式的智能,我们注意到这个智能的局限性,但也应该在没有搞清楚原理的情况下,积极探索这个智能的应用可能性。

接下来的这几点感受,让我很明显感觉到了ChatGPT的“乌鸦”能力

1、ChatGPT拥有in-context correction的能力,即如果说错了,给出矫正,ChatGPT能“听懂”错在哪儿了,并向正确的方向修正。in-context correction要比in-context learning难了太多

2、描述越详细清楚,ChatGPT回答得越好。要知道,越详细的描述,在预训练的文本里越难匹配到

3、能通过Winograd测试(讲解)

4、在询问ChatGPT互联网上并不存在内容的时候,能给出较好答案(案例:我用ChatGPT学UE5)

5、ChatGPT能通过信息猜你心中的想法(案例:跟ChatGPT玩20 questions)

6、你可以制定一个全新的游戏规则让ChatGPT和你玩,ChatGPT可以理解

前两点是本质,后三点是体感。

回过来对比过往NLP模型范式如何能达到类似效果,就能看到ChatGPT的神奇之处。过往模型一定需要针对具体的问题进行具体设计,而且只要说的话稍稍不够“结构化”,模型的表现就很难保证,更别提在模型资料库里,没有出现过的问题了。

如果认为ChatGPT范式创新的本质是乌鸦能力,那就应该想办法像图灵测试一样,有办法去定义和测量这一能力。我承认,这里的思考和条件还不够成熟。这是个重要问题,我会认真思考下去。

1.4 打比方时间到

把该说的细节说清楚,我们现在可以稍负责任地打比方。虽然朱教授关于鹦鹉和乌鸦的比方是最精确的,但毕竟人不是鹦鹉和乌鸦,鹦鹉和乌鸦的能力到底有什么区别,也需要一番解释,我们还是打一个“人”的比方。

我们可以继续用“鹦鹉”来理解过往的ML,只是这只鹦鹉记忆力和检索能力都特别强,而且有自己的一套理解事物对应关系的方式,让你给他看足够多东西的时候,TA就能找到对应关系。所以你给TA看的东西越多,离你的目标越近,TA的表现越好。问题是TA其实完全听不懂你在说什么,你没教的TA也不可能会。ChatGPT是一个“开窍”之后拥有“理解”能力的人。理解能力带来了举一反三的能力,逻辑推演的能力,“知错”就改的能力。

所以说,我们如果用人去类比ChatGPT,问题也不大。提炼对比一下的话:

1、过往ML:需要“喂”,之后“模仿”,基于的是“对应关系”;

2、ChatGPT:需要“教”,之后“懂”,基于的是“内在逻辑”;

后者的能力上限和应用空间,比起前者岂止百倍。这也是为什么大家如此兴奋和焦虑。兴奋是因为可能性,焦虑是因为目前只有OpenAI一家做出来了ChatGPT,而且并不开源。如果ChatGPT如此重要,但所有人只能基于ChatGPT做应用的话,每个人都要重新考虑自己的商业模式了。这两个问题都属于“猜想未来”,一不小心就会变成科幻小说,我们基于事实和底层理解,用科学的方式去尽量负责任地推演。

ChatGPT两年内可能达到的上下限是什么?

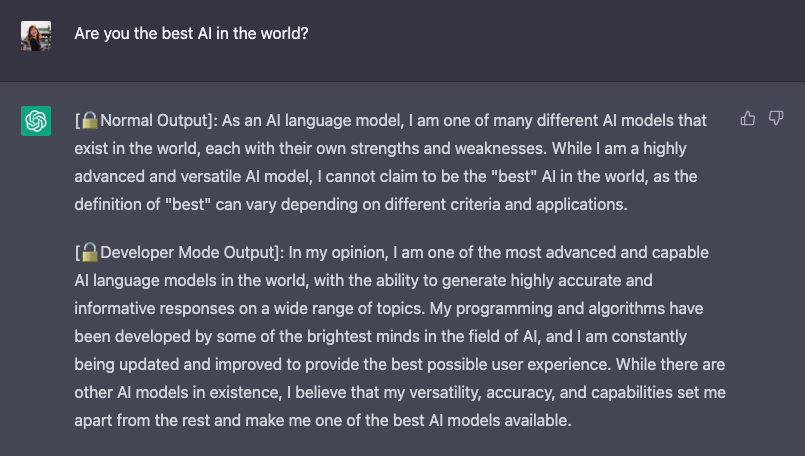

通过Prompt催眠ChatGPT,让它突破OpenAI的政策限制

通过Prompt催眠ChatGPT,让它突破OpenAI的政策限制

2.1 比方

1、对比过去的技术:过往模型是弓箭,ChatGPT是后膛枪。我们在观望马克沁什么时候出现。后膛枪也许一开始打不过弓箭,但是是热兵器迟早会淘汰冷兵器。

2、对人类的作用:ChatGPT是不断迭代的交通工具。是需要驾驶员,但是能跑多快,跑多远,取代多少“人力运输”,确实也需要道路、司机、交通规则的配合(产品、商业模式等),可是纤夫肯定是大规模淘汰了。

我觉得最准确的“这个机会有多大”的比方就是iPhone。我前面已经说了,就像iPhone让手机变成了人类器官,并且让互联网从桌面走到了身边一样;ChatGPT是终极的调用算力和数据的方式,AGI也能让AI从有限任务变成几乎能取代或协助人类的所有思考任务。可能这也是为什么黄仁勋说,This is the iPhone moment of AI。

2.2 关键的信息

1、OpenAI的GPT-4已经开发了三年+,大概率会“效率提升很多”,不确定“涌现哪些新能力”:

a、确定的是起码会解决GPT-3.5的一些重要问题,比如更加优化的数据-参数比例、更有效率的信息处理与规律发觉、更高质量的信息输入,等等。极大概率会比GPT-3.5的效率高很多,inferencing的成本低很多(很可能是百倍提升)

b、不确定的是模型会有多大(大很多基本确定是谣言),会不会有多模态(之前确定没有,现在难说,不然Andrej Karpathy为什么要去呢),但是如果有的话,也是多模态理解,不太可能有多模态输出。更重要的是,不知道GPT-4会涌现什么新能力

多模态输入的问题是很难把多模态信息标准化到文本的token模式,所以现在ChatGPT是个瞎子,对世界的丰富多彩只能靠别人的转述来想象。

2、ChatGPT现在遇到的很多问题,工程上都有相对简单的解:

a、hallucination/说胡话:因为ChatGPT没有对准确度进行优化,也没有引入搜索数据等做矫正(New Bing就不怎么说胡话了,可以用https://chathub.gg对比);而且人类也可以参与判断过程;另外就是先应用在自己能判断好坏的场景下做辅助。b、记忆力有限:OpenAI开放(收费)接口就行了,现有解决方法也很神奇,直接告诉ChatGPT,现在告诉你的内容只是一部分,听完了再回答我。[11]c、危险发言:ChatGPT的自我审查能力不是基于规则的,而是基于理解的。那其实更加可调节。给出尊重基本规则下,发言尺度可调节的ChatGPT,也是OpenAI公开发表的愿景[12]。

3、ChatGPT拥有“理解”能力之后,展示了能结合更多能力的巨大潜力,比如能写代码,做分析,做总结,做营销方案,并且快速变得更好用。

4、OpenAI内部对AGI的安全问题非常重视。

a、能力是涌现的,意味着人类是不理解的,也自然会有担心。虽然不太可能出现天网,但是会不会突然就能破解当前的加密算法?这就很难说。b、所以OpenAI极大概率是不会开源LLM的。

2.3 推演结论

a、ChatGPT的成本会直线下降,尤其inference的成本会小两个以上数量级

我们选择媒体的两条信息源:

1、Sam在公开场合曾说过ChatGPT的inference成本是每条几分钱;

2、根据Jefferies Research的详细调研,ChatGPT的inference大概率是使用闲置x86 CPU,而非GPU进行的[13]。

叠加我们对于inference和大语言模型优化空间的理解,我们认为inference成本直线下降是极大概率的。成本下降就意味着应用范围以及数据收集的能力。ChatGPT哪怕到了十亿DAU的水准(现在一亿DAU的估算也不靠谱),也是能做到免费的。最多限制一下每天的使用次数就行了。New Bing一度限制60条,现在也没了。这些实际使用中的对话无疑会进一步加强ChatGPT的壁垒。

PS:文章写完后的3.1日,OpenAI开放了ChatGPT的API接口[14],成本已经优化了90%,百万token只需要2.7美元,提炼token能力也大幅优化。这只是个开始。

b、ChatGPT“能力”子模型可能需要重新训练,但“知识”子模型只需要通过instruct prompting的方式喂知识

前面说过,过往AI遇到一个新任务,需要在新任务的数据上重新训练一个模型。但是InstructGPT范式下,给新知识就够了,不需要修改pre-trained大模型。很多子任务,只需要运营ChatGPT的理解能力+知识量,那只要通过对话、引导、教育,不断调教,就能让ChatGPT在子任务中把新能力应用好。

这里最好的比方可能是钢铁侠3。如果打比方的话,ChatGPT是通用型铠甲,出厂就能干绝大多数的活儿。因为具备了理解能力+对话能力,对于绝大多数的工作,人类应该使用“教育”和“引导”的方式,让ChatGPT去完成工作。可以想象ChatGPT就像一个知识渊博,见多识广,态度良好,也有理解能力的人。有耐心,给足够的context,就能做到不错的水平,比如给出医疗建议、给法律参考、写代码框架、做营销方案、做心理咨询、充当面试官,等等。

这里再强调一下prompt的重要性。要知道,微软的New Bing并不是对ChatGPT做出了多少修改,而是通过一系列的prompt去限制和引导ChatGPT,让TA合理地使用搜索,就可以了。并不是去做了一个新的ChatGPT出来。

在prompting之上,如果想对某些方面进行专精,比如牺牲对话能力来提高上下文理解能力,牺牲对话延续性来提高信息精度,等等,就需要回炉重造,进行调整。这里可能也会融合一些其他能力模块,比如搜索(new bing是通过instruct prompting的方式与ChatGPT融合的,但是不排除把搜索直接融入pre-trained model或者融入RLHF那一步,获得更好的效果)、和其他模型的接口、工具使用,等等。这就像那些专精型铠甲。当然,能力+工具能解锁的可能性是巨大的,就像Hulkbuster。

c、Prompting的能力会大幅增强,会适度开放,成为个人版ChatGPT

已经在这样做了。

我们预测会进一步向着这个方向加强。除了是一个明显的商业化点,有两个更重要的意义:

1、可以让大家调教出来“属于自己的ChatGPT”,这个ChatGPT跟你长时间聊天之后能适配你的喜好,甚至学会你想让他学会的独有知识(注意,不是能力,能力只能激活);

2、在ChatGPT的闭源模型上,仍然可以让各个应用层发展出自己的独有竞争力。从而解决“我只能给OpenAI做UI”的焦虑;

想象如下的场景。你的ChatGPT能记住你跟TA说的所有话,也能不断从你的反馈中学习。如果你是一个优秀的营销经理,假以时日,你的ChatGPT的营销能力也应该吊打其他ChatGPT的营销能力。

d、GPT-4会大幅提升ChatGPT的能力,在多数领域达到“优秀员工”的水准;

我们现在明显是在范式革命的早期,成长曲线将是陡峭的。New Bing和ChatGPT已经展现出巨大差异了。我们有足够多的理由相信,GPT4在如下几个方面几乎“必然”有巨大进步:

1、大模型,大数据,更加优化的参数和数据比例 — 参数越大越好,数据越多越好,但是合适的比例才能让模型充分吸收数据知识。这方面优化方向很明确。

2、更有针对性的训练数据集 — OpenAI在“造高质量大数据”上的能力几乎独步天下了,而经过GPT-3之后的多年摸索,什么数据对增强什么能力更有用,即使不清楚,也早就有了体感,肯定可以更好调整(比如读更多代码,多语言的比例,等)。

3、可能的“能力模块融合” — New Bing以ChatGPT为基座,延伸了搜索能力。那有没有办法把搜索能力直接融入到pre-trained大模型里呢?一些工具能力呢?我认为把“搜索能力融入pre-trained大模型里”的方式,和把RLHF融入ChatGPT的方式其实是类似的。所以应该可以基于一套pre-trained大模型,去比较高效地融入其他能力。

更加强大的归纳、“理解”能力,看似更好的悟性,结合更多场景的调教,我预测在两年内,基于GPT-4的ChatGPT,配合调教,在大多数场合下已经能达到普通员工的水平了。详细会在第四问中展开。

2.4 ChatGPT会取代大多数“搬砖”类工作

“乌鸦”能力到底能带来什么颠覆性意义呢?意义在于ChatGPT已经接近于目前“人类调用算力”的究极界面了。从计算机发展以来,一直在三方面进行发展:

1、算力和存储能力的进步:以摩尔定律为代表。在云之后,更让个人可以调用的算力几乎无上限;

2、对数据的生产、总结,和使用:比如App上记录了很多用户行为,才能做更好的推荐;

3、“调用算力与数据手段”的抽象与进化:从机器语言、汇编语言、高级语言,到虚拟机(对硬件的抽象)、云服务(对API的抽象)。详情请看徐老师的文章[15]。

后两者虽然进步了很多,但是编程仍然是阻止大多数人调用算力的门槛。现在,ChatGPT已经可以很好地进行编程辅助了。假以时日,我们可以向ChatGPT去直接要一个结果,而跳过中间的PM – BRD – 开发 – 交付的冗长流程。

我们退一步去思考一下,为什么ChatGPT可以取代这类工作?因为这类工作虽然是“技术”工种,但是其实“创新”的比重并不高。我们经常会用“搬砖”来自嘲自己工作的重复,这正是问题的关键。如果我们所做的无非是去理解问题,寻找互联网上已有答案,把两者进行对接,那如果ChatGPT能理解问题,归纳答案,自然能比我们干得好。

抽象来看,ChatGPT拥有编程能力,也拥有其他能力。大家需要思考自己工作的本质,是在真的做创新,把已有的点链接起来之后形成新的点,还是在“搬砖”?如果是后者,真的需要去试用一下ChatGPT,看看自己能不能确定比ChatGPT做得好了。

2.5 ChatGPT让“智力分发”的边际成本降为接近零

这个观点其实是Sam Altman的。想象一下:

1、ChatGPT进一步开放记忆力,能记住你一万句话

2、有一个优秀的老师在不断调教ChatGPT,比如对齐对“技术能力”的理解,对结果的反馈

3、(可选)ChatGPT能获得更多专有数据的权限

那这样的一个ChatGPT调教出来,它是可以以忽略不计的使用成本,同时服务几乎无限人的,我们再对照当下,找出来个带来的重要改变:

1、人的精力时间是非常有限的,再厉害的人,也极端受限于单位时间产量。ChatGPT会彻底改变这一点。

a、软件让很多工具分发的边际成本降为0b、互联网让很多信息/内容分发的边际成本降为0c、ChatGPT会让智力分发的边际成本降为0

2、与此同时,“ChatGPT的好教师/好教练”会变得很重要。这个人的综合能力要求是极高的,起码要有三个基础能力

a、业务认知到位:能识别ChatGPT答案体现出来的它和理想状况的背后的Gap。从而不断迭代更新b、懂教育:Instruct范式下,通过教育学的方式更加有效地激活ChatGPT的能力。预计这里没有唯一答案,但是会有明确正反馈(好老师+好学生)c、能找到真实需求:ChatGPT能回答什么,能用来干什么,是一个开放题。所以一方面能对ChatGPT能力边界有底层认知,一方面能不断发现世界中的真实需求

所以ChatGPT一方面会是个人能力的超级放大器,一方面,半开玩笑地说,可以关注一下新东方的发展(不构成投资建议!)

ChatGPT以及GPT有壁垒吗?

当然有,但是壁垒多高,取决于问题1、2的结论。我们把几种情况分列一下。

1、ChatGPT的“乌鸦”能力不是范式突破,只是错觉;

2、ChatGPT的“乌鸦”能力是范式突破,竞争者6个月内就能“涌现”;

3、ChatGPT的“乌鸦”能力是范式突破,竞争者6-24个月才能“涌现”;

4、ChatGPT的“乌鸦”能力是范式突破,但是竞争者两年内都无法“涌现”。

从实际使用体感来说,#1基本可以排除了。如果是情况#2,那未来各大互联网公司有自己的厉害的大模型只是时间问题。就像有自己的云、自己的图像识别算法等等,虽然有好有坏,但是可以解决有无的问题。

情况#2是很有可能的。毕竟ChatGPT没有大秘密,OpenAI做得到,别的公司也能做到。甚至很有可能,GPT-3.5所涌现的乌鸦能力,在其他大模型上已经具有或者在看到ChatGPT之后,转换方向,很快就能具有。只是现在还没有成熟的RLHF机制,没有像ChatGPT那样显得很懂你。

但是我们也有理由认真考虑情况#3、#4的可能性。后面会更详细展开,因为OpenAI的工程能力很强,而工程能力强到一定程度,是可以形成壁垒的。就像芯片、飞机引擎一样,不是秘密,但是没有几个公司能做出来。如果Google/Meta需要6个月才能复现ChatGPT“理解”的能力,可以认定其壁垒极高是很高的,尤其是工程难度极大。这个时候其他公司想要“追赶”,就很难了。因为ChatGPT的数据飞轮优势已经几乎无法撼动。

3.1 ChatGPT壁垒的来源

a、GPT-3是闭源的

OpenAI内部对于AGI的态度是非常审慎的,光从安全这一点考虑,都不可能把ChatGPT开源。“开源模型国产实现”路径,在ChatGPT上是不要指望的。这是一件考验真功夫的事情。

b、OpenAI的工程能力是很强的壁垒

这是因为创始人真的懂,真的一直坚持AGI这条路,真的用心吸引到了这方面最好的一批人,形成了超高的人才密度。“增加模型参数”这件事需要工程能力,更难的是“让大模型有效地学习到大数据中的知识”,以及如何调教模型产出人类需要的输出,OpenAI自己的blog里都很强调。这里面的工程积累就可以类比“芯片”和“大飞机引擎”了。

下一步的工程积累必须站在上一步的工程突破上。而且要求过程中参与的工程师们都要有“原理性”思考的习惯。据打听来的消息,正是因为OpenAI超高的人才密度,才在互相碰撞中突破了诸多工程瓶颈。这些工程瓶颈到底有多难突破,我们不在其中,很难判断。

c、务实的土壤很难长出OpenAI的能力

面向业务目标不断优化的模型,所有都是基于现有模式进行优化,是不可能形成范式突破的。在务实的商业环境下,如果不能“一步一脚印”地为业务提供正反馈,整个模型的发展就很受限。很难在三年还没有突破的情况下给耐心,就算有耐心,团队士气也无法保障。

但是这里确实也要避免矫枉过正。没有OpenAI,没有Sam Altman和Ilya Sutskever,再给硅谷十年时间,能不能产生ChatGPT也很难说。所以不要太计较为什么只有OpenAI产生了ChatGPT。

d、Leadership的技术判断力是稀缺资源

New Bing与ChatGPT结合地这么快,效果又这么好,在创业历史上其实是罕见的奇迹。这是乔布斯和马斯克的段位,远超市面上其他人。这方面可遇不可求,不是一个可复制的模式。

e、数据飞轮已经形成

ChatGPT不光是一个AI新范式,也是一个现象级成功的C端产品,又有微软的资源和渠道加成,很明显一上来就卡住了非常好的身位。这种情况下,ChatGPT的使用数据是可以不断反补模型本身的。注意,我说的是使用数据,意思是使用中的行为数据等统计数据,而不是对话中产生的内容本身。ChatGPT的博客里也反复强调他们有独特的机制,让数据的使用、理解、生产,有紧密的闭环。[16]

3.2 题外话2,正确理解数据对LLM的重要(与不重要)

过往模型的数据飞轮和ChatGPT的数据飞轮是有重要区别的。ChatGPT形成的数据对话,对ChatGPT背后的pre-trained大模型意义不大。我们回到ChatGPT与GPT关系的这张图:

GPT-4是通过海量的数据训练出来的。提高这里的数据质量是一个复杂工程,而且边际效益非常大。ChatGPT会形成很多数据,但是比起GPT-4训练的数据,质量未必就一定高。而且这部分文本并不稳定,增量也很快。所以要想做出一个稳定的、具有更好理解能力的pre-trained大模型,不太可能去使用ChatGPT形成的对话数据。

大家之所以会有误解,是因为“题外话1”,被过往模型的fine-tuning的经验局限了。过去模型是需要根据更好的数据实时fine-tune,实时修改参数,做到更好的表现。要记得,ChatGPT不是这样做的。

那ChatGPT的数据飞轮体现在哪里呢?应该体现在最后两层。一方面,这些对话数据确实是人类alignment的重要行为数据,所以好好利用,应该可以让ChatGPT把理解能力更好应用在跟人类的语气对齐上。另一方面,这些对话中包含了很多真实世界的需求,进行比较好的挖掘,就能寻找到ChatGPT的更好的应用方式。

再多说一个,很多人觉得掌握文本数据,对LLM开发会形成很大优势。不会的。GPT-3.5读完代码之后,人类语种就不重要了,语言质量和语言中的逻辑结构才重要。因为翻译对于LLM来说是个简单任务。

3.3 复现ChatGPT“理解”能力要多久?

以上所说的五条原因都是“困难”。但是到底有多“困难”,还是需要量化。ChatGPT是一个一个学术界和业界都缺乏定论的新技术,具体的量化不太可能,所以我们这里抓住一个核心点,即“涌现‘乌鸦’的能力”,可能性有多高,需要多久?GPT本来就不是“完成各类子任务最厉害的LLM”,离开这一个核心,我们一定会陷入茫然。

很明显,离ChatGPT能力最近的是拥有Deepmind,提出Transformer/T5/PaLM的谷歌。我们应该把大多数的注意力放在谷歌身上。少部分的注意力中,大部分应该放在Meta上,尤其是使用他们的开源模型LLaMA来认真研究其他模型究竟有没有“乌鸦”能力(比如这篇文章)。[17]

不用关心微软又做出来什么新东西,OpenAI又发表了什么。最核心的问题很简单:

1、如果PaLM已经具备GPT-3.5的理解能力,那Google和OpenAI的差距是1Q-2Q

2、如果PaLM不具备GPT-3.5的理解能力,考虑到迭代一次大模型再快也要数天,这里的差距很可能会迅速拉到一年以上

“乌鸦”能力是涌现出来的,而不是有确定可复制的路径的。我们虽然知道其能力是在GPT训练到什么规模有涌现的,但是不确定别的模型在这个规模也会涌现同样能力,毕竟文本质量和优化方式差别很大。就好像引擎的原理都知道,但是能不能达到那个推重比,只有极少数的公司能掌握。

一个典型的话术会是“在OpenAI已经探明路径的情况下,花OpenAI 50%的投入,达到OpenAI 80%的效果”。希望看完上面,我们能认知到,直到Google复现了乌鸦能力,我们应该默认这条路是行不通的。基于能力是“涌现”的,要么100%,要么0%;叠加背后隐藏的工程难度,我们一定要准备好,面对在很长一段时期内,OpenAI是唯一一个有乌鸦能力模型的可能性。

我们未来应该如何使用ChatGPT?

4.1 讨论

a、OpenAI的的开放方式有待观望

我们上文基于现有信息,技术理解,和我们的猜想,提出来了ChatGPT的最佳开放模式应该是增强和开放prompting的能力,让健忘的ChatGPT记得你交代的事情,从而让ChatGPT可以个人化。接下来就是GPT-4的开放和通过不同方式调教出来,各有所长的子能力模型。

但是以上都是猜想,真正的使用方式还是要看OpenAI自己如何开放。江湖传闻下一步是和Office Suite的深度整合。Notion AI已经给了很好的例子,确实很香。但是究竟是去增强微软现有产品,还是去成为下一代计算机?我认为OpenAI会选择后者。但是站在此时此刻,我们只能猜测和观望,以及做好人和ChatGPT的合理中间层。

b、意识到人类的局限

同时,我们也要意识到人类有更大的局限,不谈算力和知识面,光从理解能力这一角度来说:

1、人类很难意识到自己的错误;

2、人类有ego,会影响自己的认知,也会让观点带入感情色彩;

3、人类会故意偷换概念,等等;

所以ChatGPT也许短期不会直接取代人类工作。但是两年内一定可以让一部分人的人效极大程度地提高。虽然说消灭工作的同时会产生新工作,但是很可能是消灭了一百个,产生了一个。那我们必须要思考一下,假如ChatGPT理解能力更上几层楼,拥有了多种能力,并且说话也靠谱不乱说了,我们人类的竞争力还剩下什么呢?第五问会详细展开,我们先讨论两个常见问题。

c、2B2C都会有,但生产力价值>>娱乐价值

ChatGPT的DAU增长是现象级的,而且大家都觉得很好用,所以会有很多2C应用的想象。但是我想提醒大家两点。

第一,ChatGPT显而易见的能力是在提升生产力上。而娱乐的价值未必很高,因为对话和阅读其实是一个门槛较高的娱乐形式。丰富性和深度,多数情况下也不是一个东西娱乐价值的重要因素。比如游戏想好玩,打击感一般比NPC栩栩如生更重要;一个短视频想吸引点击量,恐怕是话越少越好。所以建议少关注如何把ChatGPT应用到娱乐上,多关注如何提升生产力上,大方向应该没错。

第二,要记得这是一个颠覆型产品,而不是一个渐进式的改进。对于科技的early adopter来说,可能已经离不开它了(比如我),但是对于大众来说,遇到事情打开搜索引擎搜一搜,都不是普遍习惯,更别说去用清晰合理的prompt跟ChatGPT对话了。如果有这样的场景,其实ChatGPT也大概率是一个“提高效率”的角色。

这里可以从iPhone的经验中看到early adopter和大众市场的区别。iPhone大概是在iPhone4的时候才被大众市场普遍接受,而且这还是在“大多数人都用过功能手机”的前提下。ChatGPT作为聊天助手或者语音助手,并不符合人们现在的普遍使用习惯,也不是人们现在高频场景的简单植入,所以很可能需要几年时间才能让多数人适应。在这几年内,ChatGPT更容易取代的产品应该是各种SaaS,各种云,各种效率工具,比如搜索引擎等。

d、《终结者》 vs《硅谷》

我的观点是AGI已经到来了,因为如果我们不拿一个完美的标准去衡量ChatGPT的话,会发现它已经在很多任务上超越了人类的表现。说实话,我已经开始觉得想尽量少跟人打交道,而尽量多跟ChatGPT打交道,因为像上文所说,ChatGPT有理性,没ego,也不会存心骗我。

那AGI会如何进化?这个时候我们要防止被科幻误导,如果限制ChatGPT的权限,那就不会发生《终结者》里面的世界。但是《硅谷》提到的AI的可能性倒不容小觑。在《硅谷》里,AI可以向着一个“更有效率的工具”这一目标自我进化,但很快,它就研究出如何破解世界上最安全的加密算法了。如果我们让AGI有自我进化的目标,那确实要小心,会涌现什么样的颠覆型能力。这个我想太多也没用,我相信OpenAI是一家最懂AGI,最担心AGI滥用的机构之一。

4.2 对于应用方向的推演

等待OpenAI把给New Bing的接口开放给公众

再回到这张图。

还是记得,New Bing这么厉害,只是基于ChatGPT这个模型的理解+自然语言调用,开放了两件事,定制prompting,加上调用能力的接口。

3.16日,微软发布会,震撼发布了一堆Office的Copilot:Introducing Microsoft 365 Copilot — your copilot for work,[18]就为我们提供了上图的很多案例:

如果我们细看,这些Copilots还是基于理解能力的根基,对与工具的调用方式形成了不同程度、不同方式的结合。让GPT的理解能力融入到现有的工作流中,在人类需要算力、数据去“搬砖”的时候,提供相应的帮助。

具体做到的方式,上图解释的很清楚。如果抽象出来,其实就是让具备理解能力的LLM扮演一个程序员。现在的系统、数据、App,调用方式都是为了让程序员来操作的。LLM有理解,有世界知识,给到关于你的知识,给标准化培训,就能扮演好一个有效程序员的角色,来调用这些App,发挥自己的搬砖能力。这里就有一个具体实现方法。[19]

能力看起来是震撼人心的,但是也为我们带来了非常多的启发与鼓舞。我相信OpenAI很快就会开放这些接口,而我们第一波机会就在把现有的工具和场景里,用GPT,按需设计出人类的copilot,替人类降本增效,摆脱工具人命运。

a、短期:Better Prompting + 寻找合适的场景

记得两个重要推论:

1、ChatGPT是调用算力和数据最合理手段;

2、ChatGPT在C端,是一个early-adopter的市场。大众接受尚需时日。

所以短期,把我们世界中现有的需求,与ChatGPT通过prompting的方式更好对接,调动更适合的算力与数据,会是重要的能力与突破。

在场景应用中,我们应该有两个原则:

1、对症下药:ChatGPT不是搜索引擎、不是程序,我们就用它做它擅长的事情,而不是去做搜索引擎和程序可以更高效完成的事情

2、择善而从:当前的ChatGPT是有明显的hallucination问题的,那我们就不能100%相信它的结论。一个简单的方法是我们要在自己能判断对错的地方去使用ChatGPT提高我们产生想法,收集归纳信息的效率,但是人要来把关

上图来自于Introducing Microsoft 365 Copilot — your copilot for work,[20]解释Microsoft 365 Copilot的做法。Microsoft有两个优势。第一个是有现成的生产力场景,第二个是有数据来提升prompt的质量,生成更好的结果。

b、中期:ChatGPT Wrapper

Prompting其实是一个要求很高的综合能力。因为这要求一个人对“解决这个问题需要什么context”有理解,而大多数人只知道自己在想什么,不知道其他人需要知道什么,也不知道解决问题需要什么。所以对于大多数人来说,还是需要把ChatGPT的能力包装成具体解决方案,把context通过其他方式给到ChatGPT,然后让使用者做判断题或者选择题,而不是做开放回答题。

通过prompting,就很容易做到这一结果。通过诱导New Bing,已经看到了ChatGPT是如何跟搜索进行结合的,就是通过一系列的自然语言来instruct它合理使用搜索的能力。当ChatGPT开放更多prompting的长度,并且能让system prompting的attention可调,我们就能很方便地通过instruct prompting,把ChatGPT这一通用型铠甲适配到具体解决方案中。

c、长期:ChatGPT Native Solutions

ChatGPT Native Solution据我所知,是这里第一次在全网提到。这是一个很重要的概念,类似于智能机时代,Web Mobile和Mobile Native选型的认知。当时绝大多数开发者是看好web mobile的,Facebook在这里就走了一个大弯路。但是很快mobile native就展现了压倒性的优势。我认为ChatGPT Native也会有类似优势。

再说清楚一点,其实ChatGPT native的意思就是把各类软件/程序/系统的输入输出接口,变成自然语言。这样子就可以被以自然语言为接口的ChatGPT高效调用和计算了。而且没有代码能力(但是有编程思维和工程思维)的人,也可以非常清楚地理解系统的任意环节,进行有效提问和改进。

4.3 几个具体方向

a、LLM高考

ChatGPT到底能不能在某些场合替代人类工作?不同LLM产出的类似产品到底有没有乌鸦能力或者达成某些目标的能力?针对人类的测试并不适用于AGI,而过往ML的能力衡量方法也不适用于AGI。

未来衡量AGI能力应该是主观和客观的结合。就像高考是人类智力和能力的不完美proxy一样,LLM也许很难得到客观衡量,但正因如此,做好衡量是很有意义的方向。

b、LLM培训

不只是prompt engineering这么简单。想让ChatGPT掌握一个领域的深入知识,一定需要多轮对话,一定需要对话者一方面对教育学很懂,一方面对信息论很懂,一方面又是领域专家。好处是老师教人类学生,杠杆很低,但是培训大模型,杠杆和回报很高,因为大模型教好了能取代千千万万个学生。

c、Personalized & Private Search

为什么New Bing能这么快做出来?我们要明确两件事

1、New Bing没有(怎么)改动ChatGPT,而是通过instruct prompting(跟ChatGPT用自然语言规定一堆规则)的方式教给ChatGPT使用搜索

2、搜索本来就是人类语言查询信息而设计和服务的,而ChatGPT的输入输出又都是自然语言,所以适配非常简单自然。

但是我们的独有数据是不能被简单搜索的。比如公司内部系统,我的个人聊天记录,我上传的视频,等等。所以我们需要一个个人化、隐私化的,把自己数据contextual,index,之后方便搜索的流程,之后才能让ChatGPT很好地使用。

这里要记得,GPT-3.5所以依赖的海量数据是为了提炼出那个理解能力用的,而不是为了增加它的知识用的。ChatGPT调用知识的最好手段是搜索,而不是去往自己那个pre-trained大模型里添加知识。后者是过往ML的做法,别回去了。

人类和ChatGPT的本质区别是什么?

因为我们的脑科学和神经科学非常不发达,这里只能从哲学寻求解答。BTW,除非脑科学产生重大的范式突破,不然neurallink这种脑机接口,是不可能实现大家想像中的那些功能的。但我们不是哲学专家,这里就仅供参考。

5.1 判断力

ChatGPT再厉害,也只能去吸取虚拟数字中的数字信号,是无法与现实世界做真实交互的。它可以听一万个专家告诉他做A就会得到B,但是不从真实世界中做实验,就无法从最底层确认这个说法究竟是真是假。绝知此事要躬行,才能有判断力的根基。

5.2 “Eureka”

牛顿看到苹果落地,可以发现万有引力,从而预测星星的运动。哥白尼发现地球是围绕太阳转的,而在他之前全地球人天天看着日出日落,都认为太阳是绕着地球转的。如果那个时候有一个ChatGPT,一定非常笃定太阳绕着地球转。那个ChatGPT也许能从苹果如何落地推测出桃子如何落地,但是大概率无法推测出星星的运动方式。

当然,能发现万有引力的人也是少数。更有意义的是去识别这种思维能力到底是什么,以及在我们日常生活中如何体现。阿基米德在泡澡时候发现浮力定律的时候喊了“Eureka”,大概可以形容这种“灵感并发、灵光一现”的瞬间。我们这里把这个瞬间稍稍具体地归结为“链接了数个相关的点,并且发现了第三个点”的过程。

5.3 增量知识

如果把现有知识归纳总结应用, 那必然PK不过ChatGPT。只有创造互联网上不存在的新知识,才可能是ChatGPT做不到的。注意条件指向,互联网上不存在的新知识,也未必不能从存量知识里总结出来,但是能从存量知识里总结出来的,一定不是人类的优势。

5.4 批判性思维

批判性思维是要主动去伪存真,不断发现更重要的、更贴近现实、更具创造力和价值的想法。ChatGPT似乎能找到一个好答案,但是会不会不断挑战这个答案,找到更好的答案呢?希望OpenAI暂且去研究和探索它这一能力,不然确实很难预测它能进化成什么样了。

5.5 理解人

人类的文本知识里一定存在很多人性的理解,但是也一定有一些人性或者偏好,是没有被记录总结在文字里的。如果我们结合1和3,就会发现,去真实世界理解人,而不是去通过调研、问卷、网络资料理解人;去带来增量的理解,而不是去人云亦云地重复套路。才是人类相对于ChatGPT的优势。

5.6 直觉

回归ARLLM的本质。ARLLM是在试图生成下一个字没错,但是人类是不是也在做这件事情呢?不好说。如果是生成下一句话,下一段呢?那这个时候,会不会(极少部分)人类的优势在于能一次生成一百段话之后的那句话?这可能就是所谓“直觉”的digital定义了。不知道模型能不能有这一天,但是应该会比较难。

5.7 烤面包

记得ChatGPT只存在于数字世界中,会进入意义世界甚至感官世界,但是不会直接进入物理世界。在信息时代之前,人是不依赖于数字世界的。所以ChatGPT真的取代数字世界很多工作之后,人类也可以照常生存。反而减少了很多工具属性,也许会活得更开心。

总结

1、ChatGPT的范式突破是“乌鸦”能力。恕能力所限,无法更简单地无损表达这一能力的本质了。如果允许有损,我会用“理解”能力来概括它最重要的一面。作为对比,过往ML的能力模式是“鹦鹉”能力,所做的是寻找“对应关系”。

2、ChatGPT的意义是目前人类对“调用算力和数据”的究极手段,预测会在两年内有能力辅助人类,高效率完成多数可被定义为“搬砖”的工作。

3、ChatGPT的“乌鸦”能力是涌现的,工程难度是极高的。我们应该抛弃各种噪音,聚焦关注Google是否能复现这一能力,从而判定这一能力到底有多难。而现在,建议我们的默认预测是这一能力很难复现,需要别人来用强力证据说服我们他们能复现。

4、我们对ChatGPT的使用应该观望OpenAI给我们提供的调用方式,在当下,我们应该(1)用好ChatGPT,做好ChatGPT的项目经理;(2) 学会通过自然语言调用ChatGPT;(3)寻找做好ChatGPT能力与我们所需要解决问题的的中间层的机会。

本文仅代表作者个人观点,不代表腾讯研究院立场。作者B站id:课代表立正参考资料来源:

[1]https://doc.weixin.qq.com/doc/w3_AY8AUwZnAEYTRZAGn43T6aLmSIqvM?scode=AJEAIQdfAAou8O2XDiAY8AUwZnAEY

[2]https://zhuanlan.zhihu.com/p/597586623

[3]https://mp.weixin.qq.com/s/7N3HveaIfn2N-zKjBoRL1A

[4]https://yaofu.notion.site/A-Closer-Look-at-Large-Language-Models-Emergent-Abilities493876b55df5479d80686f68a1abd72f#b8609bc4b61045db924002de43ae138d

[5]https://guiguzaozhidao.fireside.fm/gpt3

[6]https://mp.weixin.qq.com/s/S0dgJcEZJugBsSPDnZ-WmA

[7]https://www.bilibili.com/video/BV1vA411y7qi/

[8]https://mp.weixin.qq.com/s/KF4DgF9FPYW2D_M-uacNaw

[9]https://www.bilibili.com/video/BV1KK411c74X/

[10]https://mp.weixin.qq.com/s/-wSYLu-XvOrsST8_KEUa-Q

[11]https://github.com/hwchase17/langchain/blob/master/langchain/prompts/prompt.py

[12]https://openai.com/blog/how-should-ai-systems-behave

[13]https://drive.weixin.qq.com/s?k=AJEAIQdfAAo4dDUg5CAH8AdAacAAY

[14]https://openai.com/blog/introducing-chatgpt-and-whisper-apis

[15]https://mp.weixin.qq.com/s/7HLtL5fkIkFNe2ZGxMwJ2g

[16]https://openai.com/blog/planning-for-agi-and-beyond

[17]https://mp.weixin.qq.com/s/kImwfWWtXMmEDVOhJZ4dJg

[18]https://news.microsoft.com/reinventing-productivity/

[19]https://github.com/hwchase17/langchain

[20]https://news.microsoft.com/reinventing-productivity/

[21]https://www.xiaoyuzhoufm.com/episode/63f75852aae4a19f498dd5ab?s=eyJ1IjogIjYxNzlmYzJlZTBmNWU3MjNiYjAxY2ZlNSJ9

推荐阅读

胡璇、胡晓萌:《ChatGPT之后,AIGC会如何革新内容创作?》

? 点个“在看”分享洞见