揭秘!ChatGPT背后的廉价劳动力真相:只需1.32/小时,这工作你愿做吗?

文章主题:

ChatGPT如此强大

究竟是如何被训练出来的呢?

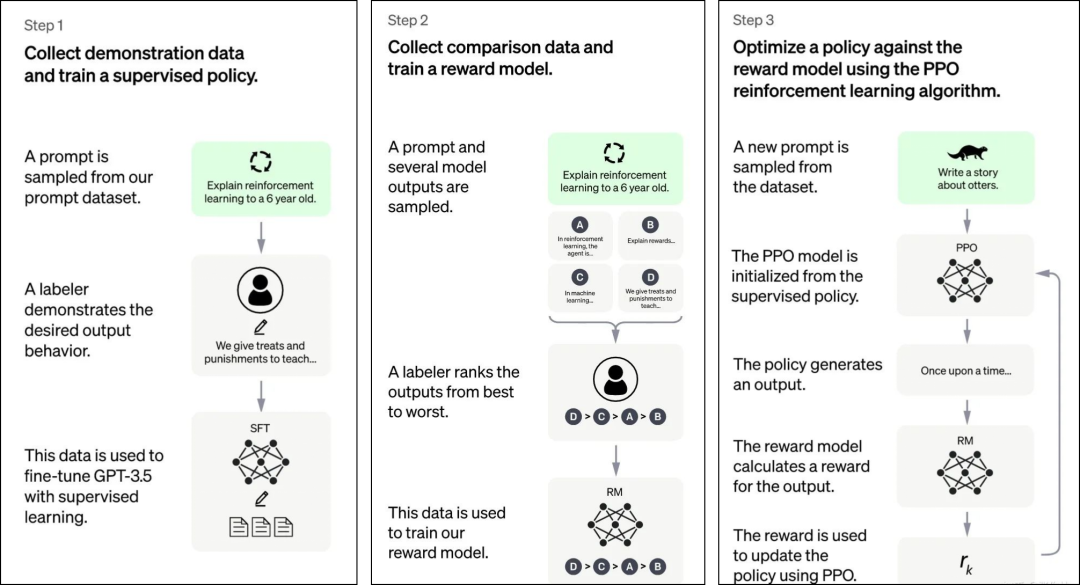

ChatGPT官网最新抛了一张图

告诉大家

“我是这么干的,分三步走”

第一步,教ChatGPT如何回答问题

最开始,ChatGPT其实像个小孩

智商并不高

比如你问它一个问题

↓

一个问题,可能出来A、B、C、D…个答案

其实GPT很难理解人类蕴含不同意图

也很难判断哪个答案质量更高

如何引导GPT输出更高质量的答案?

这个环节就需要一个“人类老师”入场了

这个岗位叫“人工标注”

找人类来思考这个问题该怎么答

并让人类提供高质量答案

就是让人类打个样,告诉GPT如何回答

回到刚才那个问题

“老婆和老妈掉进河里,我该救哪个?”

人类老师会告诉它

↓

🏆改写:🌟ChatGPT的背后:OpenAI如何通过廉价劳动力驱动技术革新🚀🔍据《时代周刊》月中旬披露的最新消息,这家全球领先的AI研究机构在训练其热门聊天机器人时,采取了一种独特且引人关注的策略——利用肯尼亚外包劳工的力量。他们的辛勤付出,以低廉的价格标注着海量数据,每小时薪酬仅1.32至2美元,相当于一杯咖啡的价值。📚在这个数字化时代的大背景下,这些年轻的劳动力在9小时的工作日内,默默处理着数十万个单词的标注任务,为ChatGPT的数据基础铺设砖石。他们的工作虽然看似简单,却是推动技术进步不可或缺的一环。👩💻这样的劳动模式不仅体现了OpenAI对成本效益的追求,也揭示了AI训练过程中的人力资源利用方式。尽管价格亲民,但这些廉价劳动力背后所蕴含的技术价值不容忽视。👀对于关注教育科技和人工智能伦理的读者来说,这无疑是一个值得深思的话题:在推动技术发展的同时,我们是否应确保公平的工作环境,以及对全球劳工权益的尊重?SEO优化提示:ChatGPT、OpenAI、肯尼亚外包、数据标注、AI训练、劳动价值、人力资源、教育科技、人工智能伦理

诸如此类

人类老师耐心地日复一日地

教导它人类的喜好

但是,世界问题是无尽的

不是所有的问题,都需要人工来答

只需要几万个问题足够了

人工提供答案的核心目的

不是为了答题而答题

而是让chatGPT知道人类的喜好

并让它后期进行模仿

人类老师把这些人工标注好的数据

喂给ChatGPT

进行监督学习(supervised learning)

监督学习的目的

是让GPT 从过去标注的数据中学习

并将学习的结果应用到新数据中

到了这里

GPT初步能够理解人类的真实意图

并根据这个意图给出相对高质量回答

最后形成各种语言策略(SFT模型)

Supervised Fine-Tuning Model

但是,这远远不够

第二步,训练奖励模型,教ChatGPT如何更高质量地回答问题

到了第二步

系统会随机抽取一批新问题

这些问题大部分和第一阶段类似

这时候,ChatGPT

会生成了N个不同的答案,比如

↓

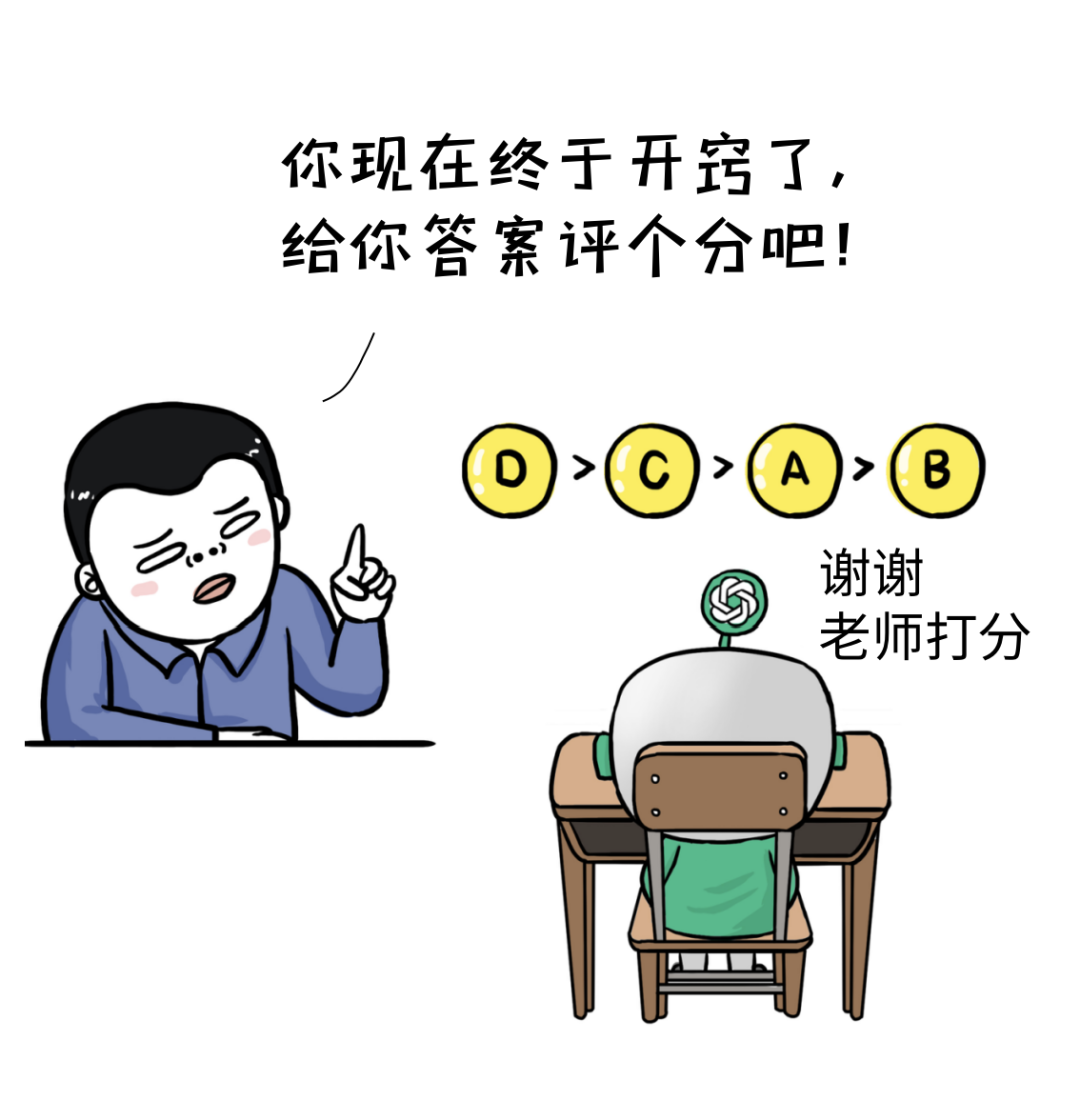

这时候,伟大的人类老师再次上场了

人类老师对N个输出答案质量

进行综合排序

排序的参考维度有很多

比如:关联性、法律法规、暴力、种族歧视等

然后利用人类老师的标注过的数据集

包括问题、答案、人类打分

来训练一个重要的模型

↓

【Reward Model-奖励模型】

即RM模型

这个模型有点像卡拉OK的打分系统

唱完一首歌,给你打分

RM模型对每个答案进行打分反馈

这让ChatGPT越来越能懂人类深层意思

不断打分,不断精进答案质量

到了这一步,其实还不够

如何让ChatGPT摆脱人类有限的指导

实现真正意义上的海量自我学习呢?

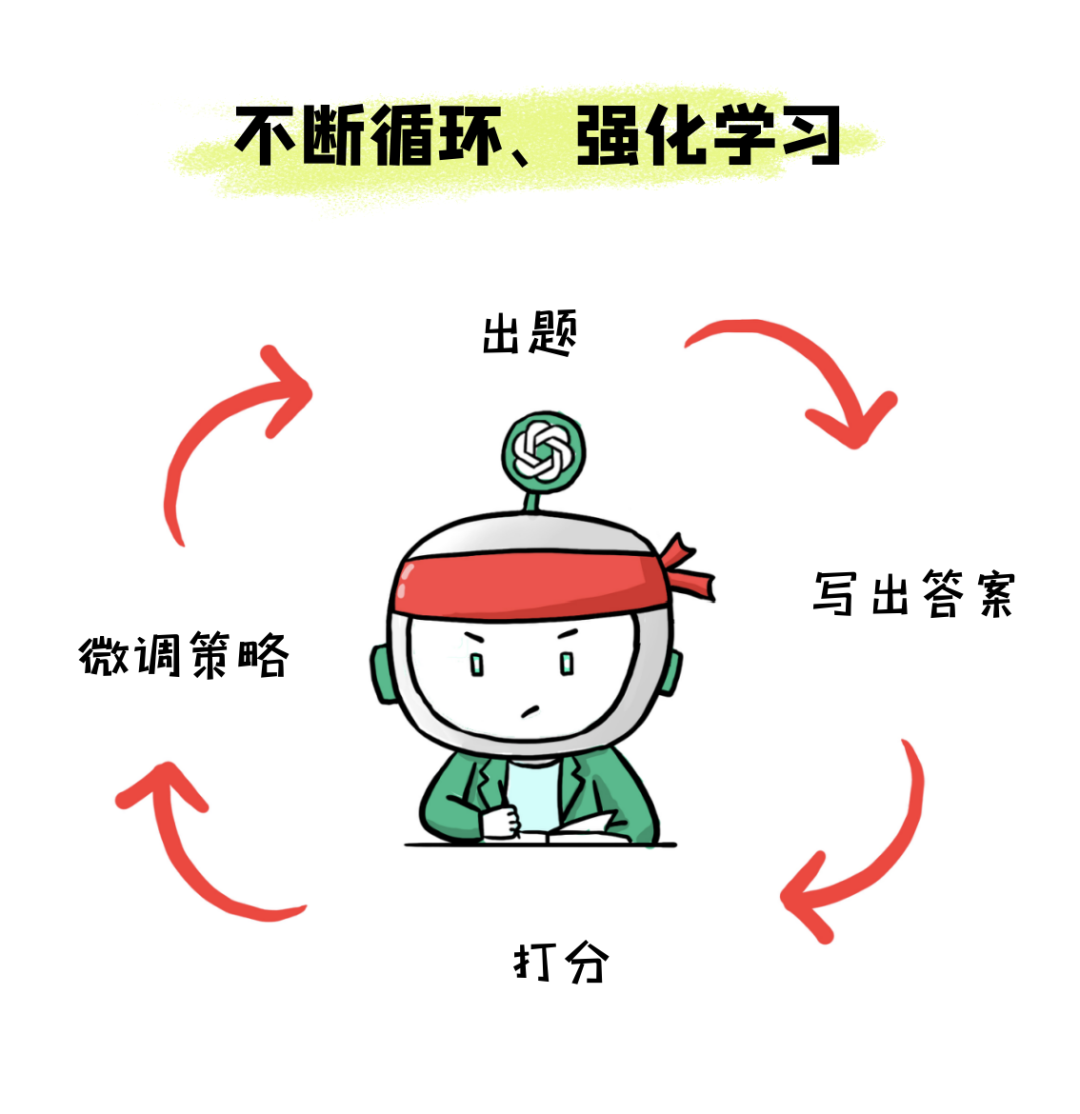

第三步,采用PPO强化学习算法,持续优化奖励模型,让ChatGPT持续自我进化

这个阶段不需要人类老师了

要脱离“人类老师”

由机器自动检查自己的学习成果

并不断做出SFT微调策略

如何自学呢?

具体这么来干

这时候,系统随机采样一批新的问题

一定是新的问题

喂给LLM(大型语言模型)

用于提高LLM的新知识的泛化能力

这时候,通过PPO模型生成答案

PPO(Proximal Policy Optimization)

是强化学习的核心算法

再把答案给到已训练好的RM奖励模型

让RM对答案质量进行评分score

这是标准的强化学习过程

这就相当于“自学”了

自己给自己出题,再对答案

根据答案,微调策略

鼓励LLM模型学习新知识并给出高质量答案

……

然后不断重复第二和第三阶段

每一轮迭代都使得LLM模型能力越来越强

通过以上三步

一个强大的ChatGPT就被训练出来了

嘿嘿,训练到最后,会是怎么样?

有人类大V说,怕它有“意识”了

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!