移动端AI应用的挑战与机遇

文章主题:工作, 移动端, 大模型, 计算资源

《科创板日报》4月18日讯(编辑 宋子乔) 上周,OpenAI创始人阿尔特曼(Sam Altman)确认,现阶段并没有在训练GPT-5,“只是在GPT-4的基础上进行更多的工作”。

“更多的工作”有哪些?布局移动端或是重要一环。

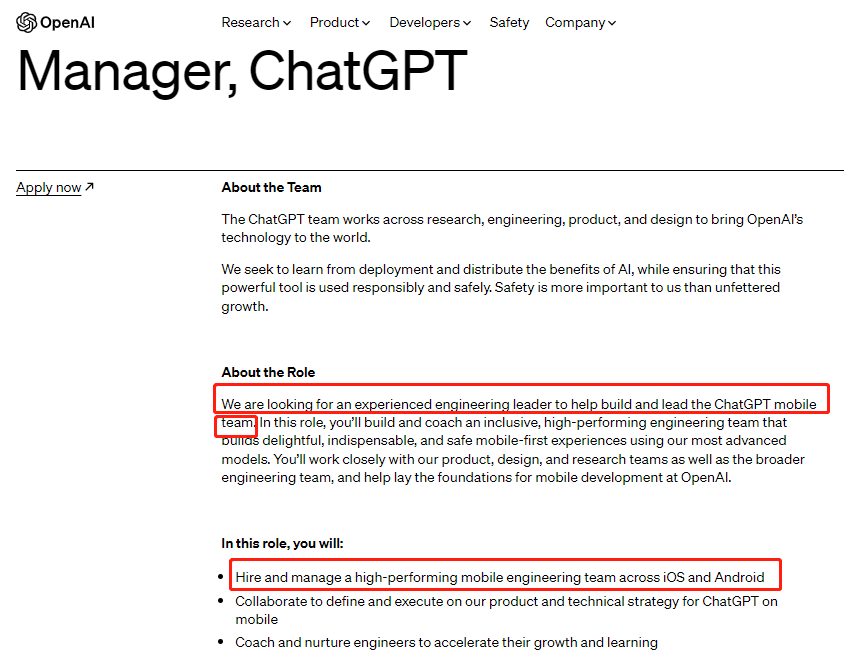

其公司招聘页显示,OpenAI正招募ChatGPT移动终端工程经理,“我们正在寻找一位经验丰富的工程师来帮助建立和领导ChatGPT移动团队。”该领导岗位的年薪在30万美元至50万美元间,还包括“慷慨”的股权赠与和员工福利。OpenAI的移动端布局跨iOS和安卓,将招募安卓软件工程师和iOS软件工程师等。

图源:OpenAI官网

此前,ChatGPT已经试水移动端。微软于2月份宣布,iOS和安卓端的必应搜索和Edge浏览器均已接入ChatGPT。

ChatGPT登陆移动端无疑有利于触达更多用户。正如微软所说,“如今有64%的搜索都发生在手机上。” 据调研机构Gartner统计,2022年全球电脑出货2.862亿台,手机出货12.8亿部。

另一方面,移动设备厂商也有意引入AI应用为硬件产品增加亮点。据纽约时报消息,三星电子考虑将其设备上的默认搜索引擎由谷歌改为必应。三星是目前全球出货量第一的手机厂商,据估计,谷歌与三星的合同关系到前者近30亿美元的年收入。

然而,对于大模型如ChatGPT而言,其在移动端的普及会遭遇诸多技术难题,主要表现在计算资源、网络资源、电量消耗、存储空间以及信息安全方面,这些都会对其在移动端的运用带来一定的阻碍。

在计算需求的场景下,例如GPT这类模型由于其庞大的计算量和高端的计算资源需求,很难在手机等移动设备上实现高效的运算。由于手机缺乏专业的GPU加速器,计算速度相对较慢,而且在移动端运行这类AI模型会消耗大量的电能,导致设备的续航能力受到较大影响。

产业端已着手解决这些技术难题,高通、华为致力于实现 AI 大模型在终端的轻量化部署,谷歌、腾讯、百度等已将模型压缩技术紧密结合移动端模型部署框架/工具。

在MWC2023大会上,高通于3月2日全球首发了首个在安卓手机上运行的Stable Diffusion终端侧演示。该模型的参数数量超过10亿,通过高通的AI软件栈进行量化、编译以及硬件加速优化,最终成功地运行在了搭载第二代骁龙8移动平台的手机上。

华为即将推出的新一代P60系列手机将搭载智慧搜图功能。此功能通过优化模型并将其小型化,实现了在设备端侧的轻量化应用,从而为用户带来更加便捷的使用体验。

在2018年,谷歌推出了一款名为MLKit的工具包,它融合了三种关键的技术:网络剪枝、量化以及知识蒸馏。这一创新性的工具可以帮助实现CIFAR-10图像分类测试任务中的模型压缩。具体来说,MLKit能够将原有的NASNet模型的尺寸缩小94倍,同时还保持了90%以上的准确性。这一突破性的技术成果,无疑为人工智能领域带来了巨大的影响。

在2018年,腾讯公司发布了一款具有创新性的产品——全球首款自动化深度学习模型压缩框架PocketFlow。到了2022年,百度团队开发的文心ERNIE-Tiny在线蒸馏方案,使得他们能够将模型参数规模压缩到原模型的0.02%,同时保持了相当的效果。这一成果展示了我国在深度学习领域的研究取得了显著进展。

华泰证券分析师黄乐平认为,模型压缩技术可在保有大模型原有性能和精度基本不变前提下降低对推理算力的需求,是实现AI大模型在边/端部署的核心技术。伴随模型压缩技术发展,AI将加速与终端设备融合应用。

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!