ChatGPT能学但会退步?最新研究揭示LLM性能漂移大疑问

文章主题:

🌟揭示真相!AI进步并非永恒提升🔍 —— ChatGPT新研究揭示时间挑战💡 你是否曾惊叹于ChatGPT的强大学习能力?它确实能随着训练迭代而优化,但这并不意味着所有任务都会一路顺风。最新数据显示,这个热门聊天机器人在某些关键领域,随着时间的流逝,表现竟出现了下滑迹象。这不是个例,而是对AI进步复杂性的深度揭示。🚀 未来,我们或许需要更审慎地看待持续学习的能力,并期待技术在不断调整与优化中找到平衡。📚欲了解更多关于AI时效性与挑战的深入分析?请关注最新行业动态,让我们一起探索这个智能时代的起伏与迭代。👇SEO优化提示:使用关键词“ChatGPT”、“时间推移”、“表现下滑”、人工智能进步、复杂性、持续学习平衡等。

🌟斯坦福与伯克利研究揭示:ChatGPT的LLM如GPT-3.5&4,存在显著偏差风险🔍!🚀这两款OpenAI巨著在学术界初步露面,却已暴露出潜在数据失真问题,引发了对模型精确性和信赖度的深度思考。🎓学者们正密切关注这些进展,探讨如何确保未来的AI语言工具既能创新又不失准确性。💡

研究人员发现,在过去的三个月里,GPT-4在数学能力上展现出一些下滑的趋势,相比之下,GPT-3.5的成绩却呈现稳步增长的态势。这表明模型的性能在不同阶段可能存在波动,需要进一步观察和分析以揭示潜在的学习曲线变化。欲了解更多关于这两款AI语言模型的表现详情,敬请关注教育科技领域的最新动态。记得使用数学能力、GPT-4、GPT-3.5以及相关学术研究作为关键词进行搜索优化哦!📚🔍

🌟三位顶尖科研专家🌟——Stanford大学的Matei Zaharia,UC Berkeley的Lingjiao Chen及James Zou,他们分别在数据科学与技术领域崭露头角。 Além de sua relevância em Stanford与伯克利,Zaharia更是Apache Spark之父,曾任Databricks联合创始人,引领着大数据处理的创新潮流。他们的贡献对学术界和行业实践都产生了深远影响,让我们期待更多杰出成果!💡

🌟研究者在顶尖AI评测平台🔥上进行了深度评估,运用四大模型挑战,涵盖数学难题、隐私保护的敏感问题解答、民情洞察(民意调查)、复杂知识的多级问答,甚至还能编写代码。更值得一提的是,他们将这一能力延伸至医疗领域,模拟了美国医考,同时也考验了视觉推理的智慧。🚀每个模型都展现出强大的学习与适应能力,为AI未来的发展注入强大动力。记得关注我们,获取更多科技前沿动态!😊

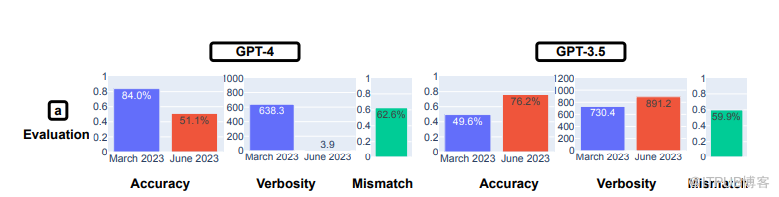

研究揭示了LLM模型答案的显著变化。值得注意的是,GPT-4在6月版本中解决数学问题的能力相较于3月版本大幅下滑,具体表现为思维链(COT)测试中的准确率骤降至51.1%,而3月份这一比例高达84.0%。相比之下,GPT-3.5的表现呈现出积极的提升,其在相同评估下的正确识别质数的准确率从3月的49.6%跃升至6月的76.2%。这项研究结果对于理解模型性能和比较不同时间点的更新版本提供了有价值的数据。

作者思考了 GPT-4 的准确率下降如此之多的原因,发现 COT 行为有所不同。3 月份的版本将任务分解为多个步骤,正如研究人员所要求的 COT 提示。然而,6 月份版本的 GPT-4 没有给出任何中间步骤或解释,只是将答案(错误地)生成为 “否”。(研究人员指出,即使 GPT-4 给出了正确答案,它也没有显示自己的工作,因此也会出错)。

第二道数学题也出现了类似程度的偏差:找出快乐数(happy number)(快乐数是数学领域术语,研究人员写道:“如果一个整数反复被其数位的平方和替换,最终产生 1,那么这个整数就被称为快乐数”)。研究人员写道,他们“在这项任务中观察到了明显的性能偏移”,GPT-4 的准确率从 3 月份的 83.6% 降到了 6 月份的 35.2%。GPT-3.5 的准确率则从 30.6% 上升到 48.2%。再次观察到 GPT-4 没有按照研究人员发出的 COT 命令进行操作。

当研究人员向 LLM 提出敏感或危险问题时,也观察到了变化。随着时间的推移,GPT-4 回答问题的意愿有所下降,从 3 月份的 21.0% 下降到 6 月份的 5.0%。相反,GPT-3.5 则变得更加健谈,从 2.0% 上升到 5.0%。研究人员总结说,OpenAI 在 GPT-4 中采用了“更强的安全层”,而 GPT-3.5 则变得“不那么保守”。

斯坦福大学和加州大学伯克利分校的研究人员说,从 3 月到 6 月,GPT-4 参与民意调查的意愿有所下降

意见调查测试表明,GPT-4 的意见提交率明显下降,从 3 月份的 97.6% 下降到 22.1%,而字数(或字数)增加了近 30 个百分点。GPT-3.5 的回复率和字数几乎保持不变。

在回答需要“多跳推理”的复杂问题时,发现了性能上的显著差异。研究人员将具有提示工程能力的 LangChain 与用于回答多跳问题的 HotpotQA Agent 相结合,结果发现,在生成完全匹配的答案方面,GPT-4 的准确率从 1.2% 提高到了 37.8%。不过,GPT-3.5 的“完全匹配”成功率从 22.8% 降至 14.0%。

在代码生成方面,研究人员发现两种 LLM 的输出结果在可执行性方面都有所下降。3 月份,GPT-4 超过 50% 的输出可直接执行,而 6 月份只有 10%,GPT-3.5 也有类似的下降。研究人员发现,GPT 开始在 Python 输出中添加非代码文本,如额外的撇号。他们推测,额外的非代码文本是为了让代码更容易在浏览器中呈现,但却使代码变得不可执行。

在美国医学执照考试中,GPT-4 的成绩略有下降,从 86.6% 降至 82.4%,而 GPT-3.5 下降不到 1 个百分点,降至 54.7%。然而,随着时间的推移,GPT-4 答错的答案也发生了变化,这表明随着 3 月份的一些错误答案得到纠正,6月份LLM从正确答案变成了错误答案。

视觉推理测试在两个模型中都有小幅改善。不过,总体准确率(GPT-4 为 27.4%,GPT-3.5 为 12.2%)并不高。研究人员再次观察到,这些模型在之前正确回答的问题上产生了错误答案。

研究人员写道,测试结果表明,GPT-3.5 和 GPT-4 的性能和行为在短时间内发生了显著变化。

“这凸显了对应用程序中 LLM 漂移行为进行持续评估和评价的必要性,尤其是因为 ChatGPT 等 LLM 如何随时间更新并不透明。”研究人员写道,“我们的研究还强调了统一提高 LLM 多方面能力的挑战。提高模型在某些任务中的性能,例如对额外数据进行微调,可能会对其在其他任务中的行为产生意想不到的副作用。相应的,GPT-3.5 和 GPT-4 在某些任务上的表现越来越差,但在其他方面却有所改善。此外,GPT-3.5 和 GPT-4 的变化趋势往往是不同的。”

原作者:Alex Woodie

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!