RLHF目标如何优化?PPO-ptx算法详解,价值最大化与模型稳定背后的策略!

文章主题:PPO-ptx, RLHF, 目标函数优化, 价值动作函数期望最大化

📚🚀掌握RLHF全貌!今日深入解析【RLHF目标优化】背后的黑科技——PPO-ptx算法!💡基于July CSdn博主深度洞察,带你领略这高效能算法的深层运作。🔍原博主已巧妙隐藏,但知识的火花仍在跃动!欲了解更多,只需轻轻一点链接,让我们一起探索AI的智慧之旅吧!🌐🚀#RLHF# #PPO-ptx# #CSdn学习

https://blog.csdn.net/v_JULY_v/article/details/128579457, 但是本文将简化相关阐述。

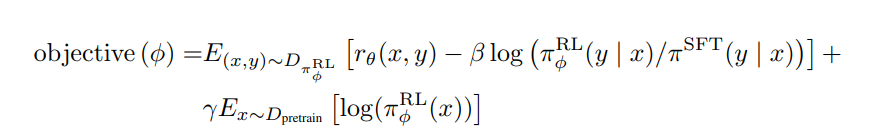

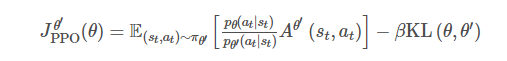

上篇帖子提到RLHF 优化目标函数:

RLHF优化目标函数

其中一共包含三个部分,下面依次进行解析.

🌟价值行动函数的优化之道 🚀在智能决策的旅程中,我们专注于探索【强化学习】的深度力量——以PPO算法为核心,这源自OpenAI在2017年发布的卓越论文《Proximal Policy Optimization Algorithms》。🚀这一章节,我们将深入解析如何通过【期望最大化】(Value Function Optimization)策略,引领智能体在复杂的环境中精准导航,实现高效的行为决策。🎯借助PPO的精巧设计,我们引导AI系统在动态奖励流中稳健学习,确保在面对变化时具备出色的适应性与鲁棒性。🛡️通过优化算法,我们不仅打造了强大的决策引擎,还为未来的探索留下了无尽可能。🚀欲了解更多关于如何运用这一强大工具来驱动智能成长的策略,请随时查阅我们的资源库或关注后续更新。📚💻

第二部分是一个KL 散度,期望学习到的最终模型参数和初始的SFT模型参数不要偏离太大,注意,这个KL散度和下文要讲的PPO已经没有关系了,只是一个KL散度约束的普通应用.

第三部分

和预训练模型输出结果不要差太大

这部分要求模型在RLHF 调优过程中,不至于和初始模型变化太大,太过拟合人类偏好.

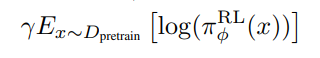

总体对损失函数进行变换推导,实际工程实现是基于如下式子进行优化:

PPO-ptx 算法

🌟🚀了解PPO算法背后的智慧吗?🔍在策略制定的复杂世界中,PPO以其独特的优势脱颖而出。💡面对直接学习策略值函数的挑战,它巧妙地通过强化学习,以数据驱动的方式迭代优化优势函数,减少不必要的采样误差。ppo算法就像一位聪明的教练,一步步引导智能体在环境中探索与适应,最大化奖励信号。🎯它的优化过程既稳定又高效,确保模型在面对变化时能迅速调整策略,实现稳定的性能提升。想要深入理解PPO并掌握其精髓?🚀跟随专家的脚步,探索强化学习的深度解析,让每一步都为你的AI项目注入强大动力!🏆SEO优化提示:#PPO算法 #强化学习 #稳定优化

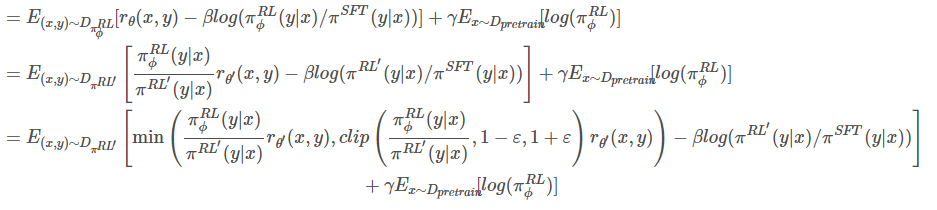

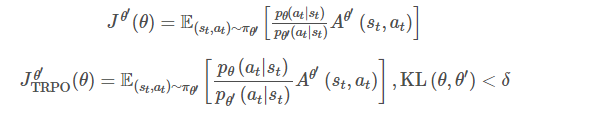

TRPO 算法

带条件的约束最优化,依据拉格朗日乘数算法可以转换为如下式子:

PPO 优化算法

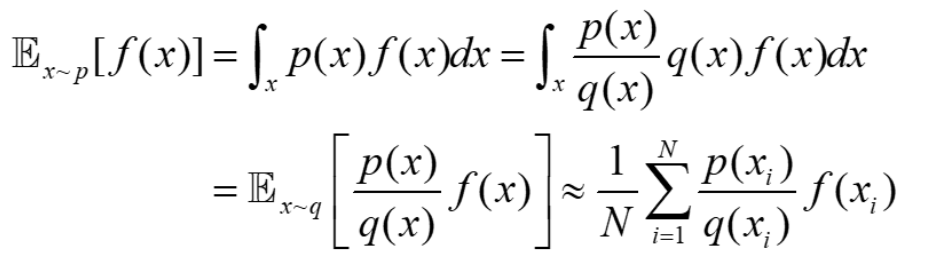

🌟了解KL散度在模型训练中的关键作用💡,源于重要性采样的挑战:直接采样往往困难重重,于是采用每分钟一个模拟样本来替代。但这会导致实际样本与目标学习结果间存在误差,为避免这种偏差,我们引入了 KL 散度作为控制手段。🎯通过这种方式,确保模型在学习过程中保持精准和一致性。

从q 中采样,代入后面的求和函数列中,计算f(x) 的期望

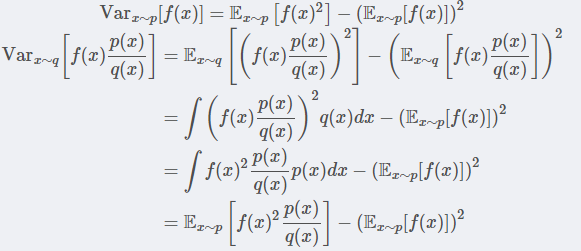

这里尽管这样做期望相等,但是方差是存在偏差的,具体推到如下:

重要性采样方差计算

第一项多了 ,只有两者相等的时候,才能保证两者的方差相等,因此实际数据优化过程中使用KL散度来限制来解决这个问题。

,只有两者相等的时候,才能保证两者的方差相等,因此实际数据优化过程中使用KL散度来限制来解决这个问题。

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!