AI淘金热:英伟达GPU的短缺与供需矛盾

文章主题:淘金热, 美国加州, 金矿, 旧金山

在1849年,美国加州金矿的发现引发了淘金热的浪潮。来自各个角落的人们纷纷涌向这个新兴地区,其中既有来自东海岸的美利坚合众国公民,也有来自欧洲大陆的寻金者,甚至有一些是第一代来到美国的华人移民。他们最初将这里称为「金山」,随后又称其为「旧金山」。

但不管如何,来到这片新土地的淘金者都需要衣食住行,当然最关键的还是淘金的装备——铲子。正所谓「工欲善其事,必先利其器」,为了更高效地淘金,人们开始疯狂地涌向卖铲人,连带着财富。

在一个世纪之后,位于美国旧金山向南不远的地区,一场新的淘金热正在悄然兴起。这次淘金的不再是金子,而是人工智能领域的“金矿”。其中,OpenAI 成为首个发现这一“金矿”的 company,而英伟达则成为了一批“卖铲人”,引领着人们进入这个新时代。就像过去一样,大量的人和公司纷纷涌向这片新的淘金之地,拿起新时代的“铲子”,开始了他们的淘金之旅。

不同的是,过去的铲子几乎不存在什么技术门槛,但今天英伟达的 GPU 却是所有人的选择。今年以来,仅字节跳动一家就向英伟达订购了超过 10 亿美元的 GPU,包括 10 万块 A100 和 H800 加速卡。百度、谷歌、特斯拉、亚马逊、微软……这些大公司今年至少都向英伟达订购了上万块 GPU。

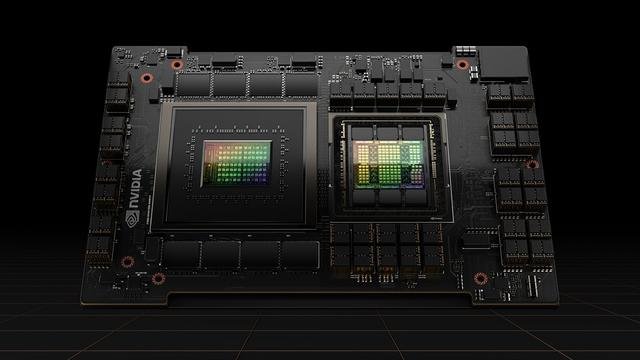

H100 GPU 图源:英伟达

然而,这样的情况仍然不足以满足需求。据旷视科技CEO印奇透露,我国目前可用于大型模型训练的AI芯片数量非常有限,仅有约4万片A100。随着AI技术的不断发展和普及,英伟达上一代高端GPU A100的定制版本在国内价格也一度上涨至每片10万元。

6 月的一场非公开会议上,OpenAI CEO Sam Altman 再次表示,GPU 的严重短缺,导致了很多优化 ChatGPT 的工作被迫推迟。按照技术咨询机构 TrendForce 的测算,OpenAI 需要大约 3 万块 A100 才能支持对 ChatGPT 的持续优化和商业化。

自今年1月ChatGPT引发新一轮繁荣以来,AI算力短缺问题已经持续近半年。尽管如此,诸多大型企业为何仍然对GPU和算力需求旺盛呢?

ChatGPT们缺显卡?缺的是英伟达

形象地表述如下:犹如一句广告诉求:并非所有的 GPU 都是英伟达所制造。 GPU 的供应紧张,实际上主要源于英伟达高端 GPU 的稀缺性。对于 AI 大模型的训练而言,用户可以选择英伟达的 A100、H100 GPU,或者是在去年禁令之后,英伟达特别推出的减配版的 A800、H800 GPU。

AI 的使用包括了训练和推理两个环节,前者可以理解为造出模型,后者可以理解为使用模型。而 AI 大模型的预训练和微调,尤其是预训练环节需要消耗大量的算力,特别看重单块 GPU 提供的性能和多卡间数据传输能力。但在今天能够提供大模型预训练计算效率的 AI 芯片(广义的 AI 芯片仅指面向 AI 使用的芯片):

不能说不多,只能说非常少。

大模型很重要的一个特征是至少千亿级别的参数,背后需要巨量的算力用来训练,多个 GPU 之间的数据传输、同步都会导致部分 GPU 算力闲置,所以单个 GPU 性能越高,数量越少,GPU 的利用效率就高,相应的成本则越低。

英伟达 DGX H100 AI 超级计算机 图源:英伟达

英伟达自2020年起推出的A100和H100芯片,在性能上表现出色。其中,A100的FP32算力达到了令人瞩目的19.5 TFLOPS(每秒万亿次浮点运算),而H100则更为强大,具有高达134 TFLOPS的算力。这不仅使得这两款芯片在处理复杂计算任务时游刃有余,同时也为它们在未来的高性能计算领域奠定了坚实的基础。

在通信协议技术方面,英伟达通过投入NVLink和NVS switch等技术,成功建立了更为深厚的护城河。在H100平台上,第四代NVLink能够支持高达18个NVLink连接,总带宽更是达到了惊人的900GB/s,这相当于PCIe 5.0带宽的7倍之巨。

面向中国市场定制的 A800 和 H800,算力几乎不变,主要是为了避开管制标准,带宽分别削减了四分之一和一半左右。按照彭博社的说法,同样的 AI 任务,H800 要花比 H100 多 10% -30% 的时间。

但即便如此,A800 和 H800 的计算效率依然超过其他 GPU 和 AI 芯片。这也是为什么在 AI 推理市场会出现「百花齐放」的想象,包括各大云计算公司自研的 AI 芯片和其他 GPU 公司都能占据一定的份额,到了对性能要求更高的 AI 训练市场却只有英伟达「一家独大」。

H800“刀”了带宽 图源:英伟达

当然,在「一家独大」的背后,软件生态也是英伟达最核心的技术护城河。这方面有很多文章都有提及,但简而言之,最重要的是英伟达从 2007 推出并坚持的 CUDA 统一计算平台,时至今日已经成为了 AI 世界的基础设施,绝大部分 AI 开发者都是以 CUDA 为基础进行开发,就如同 Android、iOS 之于移动应用开发者。

原内容主要描述了英伟达高端GPU的受欢迎程度以及其正在增加晶圆代工订单以满足市场需求的情况。以下是我对其进行的改写:英伟达作为一家技术领先的公司,其高端GPU产品的市场需求一直旺盛。据近期报道,随着春节后的市场需求的进一步增长,英伟达已经开始增加晶圆代工订单,以确保满足全球市场的热捧需求。预计在未来几个月里,随着这些订单的执行,英伟达的代工产能将得到显著提升,尽管这与台积电最先进的3nm工艺相比略有逊色。

然而问题恰恰出在了代工环节。

英伟达的高端 GPU,离不开台积电

众所周知,消费电子的低潮以及还在继续的去库存,导致晶圆代工大厂的产能利用率普遍下滑,但台积电的先进制程属于例外。

由于 ChatGPT 引发的 AI 热潮,基于台积电 7nm 工艺的 A100、4nm 的 H100 都在紧急追加订单,其中台积电 5/4nm 的产线已经接近满载。供应链人士也预估,英伟达大量涌向台积电的 SHR(最急件处理等级)订单将持续 1 年。

换言之,台积电的产能并不足以应付英伟达短期内的旺盛需求。不怪有分析师认为,由于 A100、H100 GPU 始终供不应求,不管从风险控制还是成本降低的角度,在台积电之外寻找三星乃至英特尔进行代工都是题中应有之义。

半导体硅片上造芯片 图源:台积电

但事实证明,英伟达至少在短期内没有这个想法,也没有办法离开台积电。就在 Sam Altman 抱怨英伟达 GPU 不够用之前,英伟达创始人兼 CEO 黄仁勋才在 COMPUTEX 上表示,英伟达下一代芯片还是会交由台积电代工。

技术上最核心的原因是,从 V100、A100 到 H100,英伟达的高端加速卡都采用台积电 CoWoS 先进封装技术,用来解决高算力 AI 背景下芯片的存算一体。而 CoWoS 先进封装核心技术:没有台积电不行。

2012 年,台积电推出了独家的 CoWoS 先进封装技术,实现了从晶圆代工到终端封装的一条龙服务,客户包括英伟达、苹果等多家芯片大厂在高端产品上都全线采用。为了满足英伟达的紧急需求,台积电甚至采用部分委外转包的方法,但其中并不包括 CoWoS 制程,台积电仍专注在最有价值的先进封装部分。

按照野村证券预估,2022 年底台积电 CoWoS 年化产能大概在 7-8 万片晶圆,到 2023 年底有望增至 14-15 万片晶圆,到 2024 年底有望挑战 20 万片产能。

但远水解不了近火,台积电先进 CoWoS 封装的产能严重供不应求,去年起台积电 CoWoS 的订单就在翻番,今年来自谷歌、AMD 的需求同样强劲。即便是英伟达,也要通过黄仁勋与台积电创始人张忠谋的私人关系,进一步争取更高的优先级。

台积电 图源:Wikimedia Commons

写在最后

过去几年由于疫情和地缘政治的变化,所有人都意识到了一种建立在沙子之上的尖端技术——芯片是如此重要。ChatGPT 之后,AI 再度举世瞩目,而连带对人工智能和加速算力的渴望,无数芯片订单也纷至沓来。

高端 GPU 的设计和制造都需要很长研发投入和积累,需要面对难以逾越的硬件和软件壁垒,这也导致了在这场「算力的盛宴」之中,英伟达和台积电可以拿到大部分的蛋糕以及话语权。

不管是今天关心生成式 AI,还是上一轮以图像识别为主的深度学习浪潮,中国公司在 AI 软件能力上的追赶速度都有目共睹。然而中国公司花费巨资,调转船头开向 AI 的时候,很少着眼于更底层的硬件。

但 AI 加速背后,最重要的四款 GPU 已经有两款在国内受限,另外两款阉割的 A800、H800 不仅拖慢了中国公司的追赶速度,同时也无法排除受限的风险。比起在大模型上的角逐,或许,我们更需要看到中国公司在更底层的竞争。

AI时代,拥有个人微信机器人AI助手!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

搜索微信号aigc666aigc999或上边扫码,即可拥有个人AI助手!