数学AI新方向?微软前研究员杨格探讨大模型黑箱与超参数优化之路

文章主题:数学AI, GPT-4, Tensor Programs

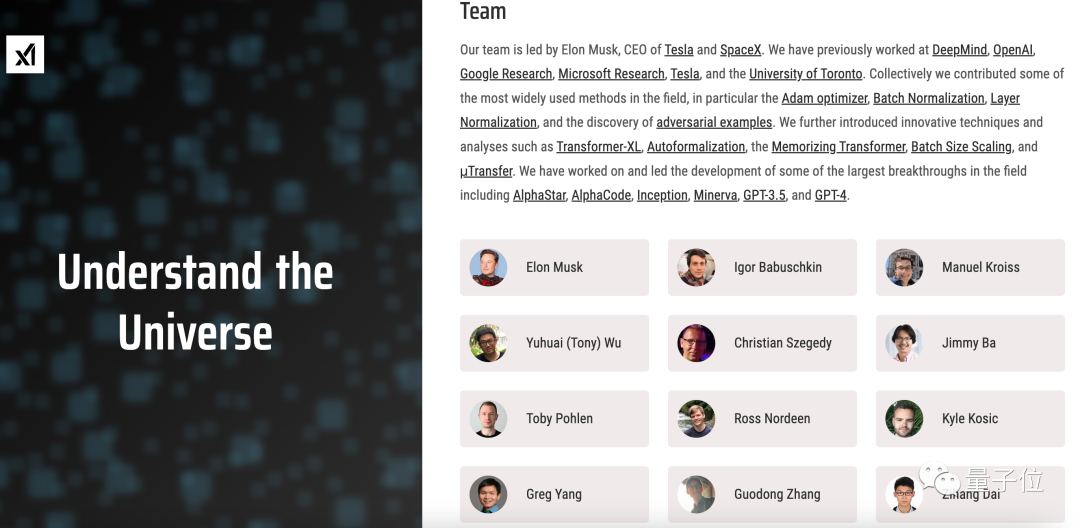

马斯克组局xAI“钻研宇宙本质”,创始成员高深又神秘。

相比专注于AI领域本身,这些成员大多具有基础学科背景,接触AI之前或是在研究基础数学,或是在搞物理。

这家公司究竟要做什么?

就在这两天,丘成桐弟子杨格(Greg Yang),成为第一个以“xAI创始成员”身份在国内会议上发言的人。

🌟💡在世界级的学术盛宴#国际基础科学大会#中,他聚焦于#数学AI#领域的前沿探索,分享了他对未来数学与人工智能交汇的独特见解。他的研究热情不减,将继续致力于推动这一领域的发展。对于当下大模型的迅速崛起,他表示既赞赏又关注,期待它们能为科技进步开辟新路径。🚀

而他的个人经历也再次浮出水面,为更多人所关注。

接下来要进行什么研究?

在国际基础科学大会上,杨格就自己正在研究的方向进行了一场演讲。

演讲主题,主要与AI和数学交叉学科有关——

从数学角度出发,建立一种描述神经网络架构的统一编程语言Tensor Programs。

🌟微软研究院深度耕耘的专业领地,这位专家持续专注并取得了显著成果。自2019年起,他已独立发表了两篇重量级论文,引领该领域的发展。至今,该项目已有令人瞩目的7篇论文接踵而至,展现出强大的研究影响力和持久的创新活力。SEO优化词汇:#微软研究# #领域专家# #连续发表# #项目成果# #论文里程碑

具体来说,Tensor Programs项目有一个“短期目标”和一个“长期目标”。

短期来看,这个编程语言能实现在设计新神经网络架构时,自动进行初始化条件分析,并给出其中最优的超参数初始化条件,从而让模型训练更顺利。毕竟此前,这一领域的初始化设置几乎“全靠经验”。

长期而言,Tensor Programs项目的目标是开发大规模深度学习的“万物理论”。

这也与杨格在推特说的、他在xAI要进行的研究方向一致:

🌟🚀人工智能领域的探索仍在深邃的迷雾中摸索,尽管大模型和新兴技术如火如荼,但AI的”透明度缺失”依然是一个未解之谜。🤔究竟哪种路径(参数量的无尽堆砌或是MoE的创新尝试)能带来更大的突破,目前仍是学术界争论的焦点。🔍不论是追求更大规模的模型以求数据的海量喂养,还是探索多模态解耦的MoE技术,每一步都承载着可能的答案,但确切的赢家尚未显现。🏆未来,期待科研的脚步能更深入地揭示AI的秘密,为我们的智能世界带来更为清晰和可靠的指引。🌍

因此,Tensor Programs最终目标是找到一种理论上的规则,可以真正理解AI大模型的行为。

🚀【最新科研突破】Microsoft & OpenAI联手大放异彩!💡论文”μTransfer”震撼发布,由业内顶尖团队成员楊格携手引领,展示了Tensor Programs的前沿技术实力。🔍此创新成果不仅打破了传统边界,更预示着未来AI领域的无限可能。欲了解更多详情,敬请关注我们的最新动态,一起探索科技的无限深度!🌐—Microsoft与OpenAI强强联合,共同推出了论文”μTransfer”, 由备受瞩目的杨格作为一员关键贡献者。这标志着Tensor Programs在人工智能领域的又一里程碑,展示了其卓越的创新能力和对未来技术趋势的敏锐洞察。欲获取更多关于这个革新项目的信息,敬请留意我们的深度解析,一起见证科技如何驱动进步!👩💻👨💻—Microsoft与OpenAI强强联合的科研硕果——”μTransfer”论文已震撼发布,杨格以其专业才能作为团队一员,为这一突破性进展添砖加瓦。Tensor Programs再次证明了其在人工智能领域的领导地位,引领着前沿技术的发展方向。欲获取更多关于这个创新项目的信息,敬请关注我们的SEO优化内容,一起探索科技的无限可能!🔍💻—微软与OpenAI携手打造的论文”μTransfer”, 杨格以其卓越贡献成为研究团队一员,展示了Tensor Programs在人工智能领域的最新突破。这一科研成果不仅提升了技术高度,也预示着AI领域未来的无限想象空间。欲获取更多关于此项目的信息,敬请关注我们的SEO优化内容更新,一起见证科技如何塑造未来!🌐🌟

🌟掌握关键!🔍研究旨在优化大模型的超参数调优,减少不必要的训练时间与计算资源消耗。对这些庞然大物而言,‘重复学习’确实是个昂贵的内存杀手。🎯通过精确调整,让每个模型都能高效运行,释放宝贵的计算力,为AI领域带来更绿色、智能的进步!🌍

🌟🚀科研新成果!🚀🔍杨格教授引领,一款创新的Tensor Programs项目——µTransfer,已震撼发布!🎉💡通过开源,让科技力量更广泛地惠及大众。📚📈在最近的演讲中,他深入剖析了该项目的最新进展,展示了其强大的转移学习潜力和对未来的深远影响。🌍💻探索未知,改变世界,只需关注Tensor Programs,让我们一起见证科技的力量!🌐🌟

从这几篇研究论文侧重的AI模型来看,大模型如今已经是杨格研究的重点方向之一。

一个值得关注的点就是,μTransfer已经用到GPT-4中了。

公众号“安迪的写作间”作者在杨格(Greg Yang)演讲结束后,和他聊了聊:

下台我问了他关于GPT-4用到μTransfer了吗,给出肯定回答。

所以,他究竟如何看待大模型的未来?

在这次论坛的圆桌对话上,杨格也提到了自己对大模型发展方向的看法。

他认为,继续堆叠大模型参数可以让模型效果越来越好,但这有个前提,即数据集的质量和数量必须要上升。

以前收集网络数据就行,如今训练集必须变得更偏向数学、科学、更有逻辑性,才能提高模型的科学和数学推理能力。

同时,杨格也给了如今拼搏在科研、交叉创新一线的AI研究人员一点建议,就是“Follow your dreams”:

这一阶段的很多杰出的搞AI的人,像工程师、研究人员,有几个都是像我这样没有读博士,只是就想去干,拼一下就拼出结果的,像Alec Radford,GPT-1、GPT-2都是他自己做的,后来OpenAI就开始砸钱了。

曹操说的“乱世出英雄”,这是个新世界,你不要想一些外部环境,直接去干,很有可能擦出火花,这就是要你自己有热情。

没错,当年的杨格,打破了微软研究院“只招博士生”的惯例,本科毕业就进入了这一机构工作。

他在学术经历上究竟有什么过人之处?

换而言之,为何他会成为马斯克选中的“12人”之一?

杨格是谁?

杨格出生于湖南省,在北京读完小学后,就去了美国,本科考上了哈佛数学系。

在哈佛的头两年,杨格参加了鼓手团、咨询团等众多活动。

大二结束时,有着音乐梦的他决定休学全身心投入音乐事业,成为一名电子舞曲音乐制作人和DJ,取艺名“Zeta”。

也是在此期间,杨格接触到了人工智能。

一年半后,杨格发现自己的“真爱”终归还是数学,于是又回到了哈佛。

读完春季学期的课程后,他又休学两年,这一次他没有执着于音乐,而是快速学习了数学和理论计算机科学,以及人工智能的前沿进展,此外还广泛涉猎物理学、生物学和神经科学。

此外,他还研究起了神经图灵机,并结合可微拓扑学中的思路,提出“Lie Access Neural Turing Machine”,发表于ICLR。

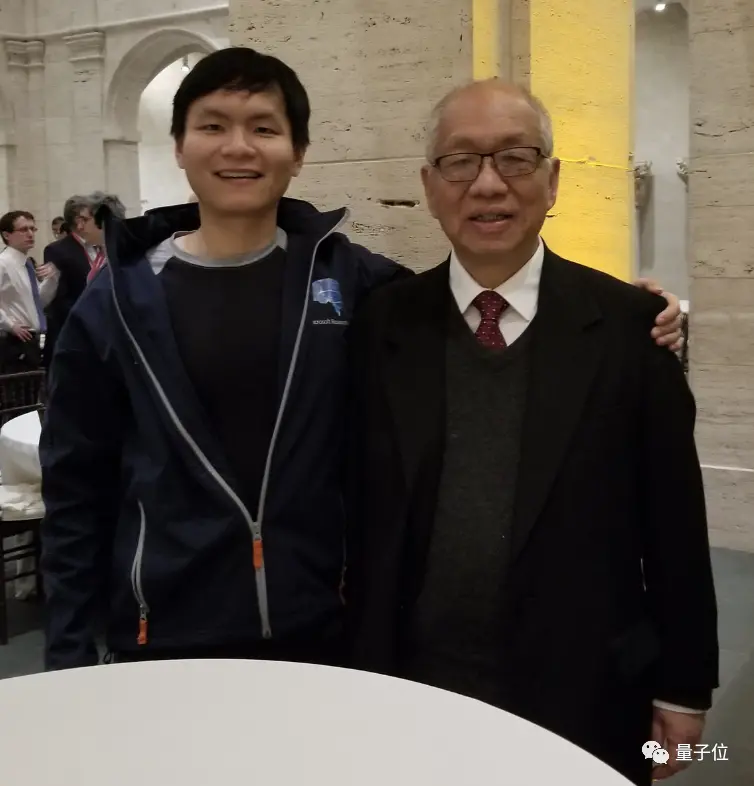

再次回哈佛,杨格师从丘成桐教授。

△ 杨格与丘成桐,图源:杨格推特

2017年,杨格顺利从哈佛毕业,拿到了数学学士学位和计算机科学硕士学位。并获得了2018年摩根奖荣誉提名(Honorable Mention for the 2018 Frank and Brennie Morgan Prize for Outstanding Research in Mathematics by an Undergraduate Student)。

毕业后,老师丘成桐曾问杨格“你毕业去哪儿”,他说“我要去谷歌”。

丘成桐说“谷歌这种很差的公司就不要去了,我有个朋友叫沈向洋,我马上给他打电话”。

后来,沈向洋让菲尔兹奖获得者Michael Freedman面试了杨格:

面试之后(Michael)说这个小孩不得了,那时候他才刚刚本科毕业,但在哈佛至少是前五名(的水平)。

我(沈向洋)当时就跟杨格讲,你把谷歌的Offer拿来给我看一看,我给你加一块钱,就来微软吧。

最后杨格选择了微软。而进入微软后杨格也获得了沈向洋的高度评价:

微软研究院平时只招博士生的,杨格作为一个本科毕业生进了微软研究院,不仅进了微软研究院,过去这五年还做得无比优秀,特别是在GPT发展过程中做了举足轻重的贡献。

进入微软后,杨格的重要成果之一就是持续开发上面提到的“Tensor Programs”框架,其中还用GPT-3对所提出的超参数迁移方法进行了验证,相关论文已收录于NeurIPS、ICML等顶会:

此外,谷歌学术数据显示,杨格从2015开始发布论文,至今已有34篇。

其中引用量最高为415,这也是他在微软的工作,杨格在这个项目中担任主要指导(Primary mentor)。

目前,杨格个人主页和推特主页等均已更新,已离开微软研究院,加入xAI,接下来将继续做数学工作。

杨格做出了新一轮的选择,但从第一次休学过后,他再也没有放弃对数学的热爱。

在这次的论坛上,杨格也被问到,当时去从事音乐后又转到数学研究,是怎样一直坚定走到现在的?

杨格回答道:

其实就是个人爱好,在我大二休学之前,我一直都是数学比较好的人,可能会觉得一辈子在这种(数学研究中)。之后虽然我去搞音乐,但有段时间自己思考后,发现其实我个人还是很热爱数学。

这里面可能有外在动机(motivation extrinsic)和内在动机(motivation intrinsic)。像数学答卷老师给你100分,你觉得很高兴,这是外在的。这种外在和内在混在一起,可能感觉不到自己真心的爱好,但是后来休息一段时间以后,感觉(对数学)是发自内心的热爱,之后就走了这么长的路。

One More Thing

还记得前段时间杨格给大伙儿推荐的300多本(大部分是数学)书吗?

不少网友看过之后,表示“书单实在太长了,不是普通人能看完的”,还有网友调侃“能不能用GPT帮我总结一下”……

论坛结束后,我们也和杨格聊了聊,了解了他对ChatGPT等大模型的一些看法。

提问:看到您前段时间推荐了大概300本多书,有很大一部分是数学书,您认为AI是否有可能把它直接总结成一个核心的要点给我们?平时在日常生活中,您是不是也会用GPT-4一样的模型,去帮助做一些数学的基础研究什么的?

杨格:我觉得AI的总结能力(summarization)现在应该挺好的了,做简单的总结应该没问题。但你要再深入理解它里面的道理,像是一些数学道理的话,可能AI现在的帮助还不是那么大。

日常生活的话,是会经常用到(大模型)。

提问:可以透露一下主要是用在哪些方面吗?

杨格:我觉得最有用的方法就是写程序吧。比如有些程序你确实可以自己写,但自己写的话,一是可能要花几个小时,二是觉得这种东西不是特别有趣,所以像这种工作你就可以用ChatGPT来帮你做。

提问:相当于您完成核心思考,然后ChatGPT帮您实现代码的工作。

杨格:其实就是实现它已经在网上看到很多很多遍、所以它能写得很好的一些程序。

但如果现在你想写一个复杂的程序、像是有什么逻辑性的程序的话,让ChatGPT来做可能还不一定做那么好。但如果是那种你写了几百遍的程序了,你不想再写,就可以用ChatGPT完成。

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!