文章主题:生物医学, LLM虚构, 语义熵

原文改写:🌟学术深度探索🔍——一篇关于【主题】的深度解析文章,带你领略知识海洋的壮阔。🎓通过详实的数据与逻辑分析,揭示行业趋势与未来可能。📚作者以独特的视角和严谨的态度,打破常规,提供独到见解。💡阅读本文,不仅增长见识,还能提升你的思考力。🔗点击链接,立即获取全文,让学术经纬引领你走在知识的前沿!✨SEO优化词汇:🌟学术深度探索🔍——一篇专注于【替换原主题】的专业文章,带你揭秘行业秘密。🎓通过严谨研究和数据解读,揭示市场走向与未来趋势。📚作者以创新视角和精准分析,打破常规见解。💡阅读本文,不仅增长知识,还能启发思维火花。🔗点击链接,立即免费获取全文,让权威引领你走在知识的最前沿!✨注意:保留原文核心信息,同时避免直接复制原内容,确保改写后的文字流畅且具有吸引力。

🌟🚀大语言模型ChatGPT的兴起确实为各行各业带来了效率提升,但它并非无所不能。尽管它能快速生成答案,但我们不得不承认,偶尔会遇到那些看似准确实则谬误的答案。有时,它甚至可能以权威的姿态给出错误导向。🔍

图片来源:123RF

图片来源:123RF🌟当提到LLM在生物医学领域的局限性时,一个显著案例是它在处理特定药物如Lumakras(sotorasib)的能力上。这款由FDA批准的KRAS抑制剂,专为治疗KRAS G12C突变的非小细胞肺癌而生,被誉为”不可逾越的疗法”。然而,LLM的表现并不总是精准,它有时会混淆目标,将G12C的答案误报为G12D。这种不完全的响应揭示了AI在复杂医疗信息处理上的挑战,尽管它在其他领域可能表现出色。 若要优化搜索引擎SEO,可以改为:🔍LLM在Lumakras(sotorasib)应用中的误导性示例揭示了其在KRAS突变解析上的局限性,这药物对于KRAS G12C的肺癌治疗至关重要。AI偶尔的错误提示提醒我们,尽管技术进步,精准医疗仍需不断提升。记得关注最新科研动态以获取更精确的答案哦!💪

当我们谈论LLM时,不应将其视为因误传数据而频繁犯错的工具,亦非单纯为了奖励而编造谎言的存在。它偶尔展现出的不准确回应,即所谓的“虚构”,是LLM常见故障类型之一,这背后的复杂性源于无法完全验证的人工智能行为。尽管技术进步可能减少此类错误,但受不可预知因素影响,这类虚构问题仍难以根除,就像人类社会中那些难以消除的误解一样。

🌟自动辨别LLM虚假答案的秘籍在这里!🔍由牛津大学的Sebastian Farquhar博士及其团队在《自然》杂志最新刊上揭秘,他们独创了一种通过“语义熵”来检测LLM回复真实性的聪明方法。🚀这不仅为寻找最可信的答案提供了新工具,也让科技与知识的碰撞更加精准无误!💡

🚀了解LLM虚构背后的真相!首先,我们需要洞察这项创新策略的核心——它并非直接从数据库检索信息,也不是深度理解问题。相反,LLM以预测为关键,通过海量训练生成最可能接续的词,构建看似连贯的文本。这种现象源于预测过程中难以避免的随机误差,正是这些意外的转折点创造了LLM的虚构效应。🔍

🌟当然可以!想要提升预测的精度,不妨探索一下信息论中的概念——熵。就像热力学中的熵,它能揭示系统无序或不稳定性,这里,熵则成为评估LLM(语言模型)答案可信度的关键指标。高熵表示回答可能包含不确定甚至虚构内容哦!🔍通过理解这些数学背后的逻辑,我们可以更精准地过滤出那些经过深度学习训练后的‘真实’答案。记得优化SEO关键词,让搜索引擎也能轻松找到你的深入分析哦!🏆

🌟原文理解:传统熵概念聚焦于词汇的随机性,但作者巧妙地引入了语义熵,以词句间的深层意义而非字面信息,评估句子的真实含义。🚀📝改写后:在传统的视角中,熵常关联于词语的多变性,然而,语义的丰富性超越了表面文字。作者创新性地定义了语义熵,通过分析词汇如何随上下文演变,来度量而非单纯量化句子的内涵深度。🔍🌟SEO优化:理解语义熵的概念,探索词汇在语境中的真正含义,提升文章信息密度与搜索引擎排名。🌐📝情感增强:探讨语言深层含义的熵值,引导读者深入理解文本背后的丰富意蕴。📚记得,保持专业且吸引人的写作风格哦!😊

图片来源:参考资料[2]

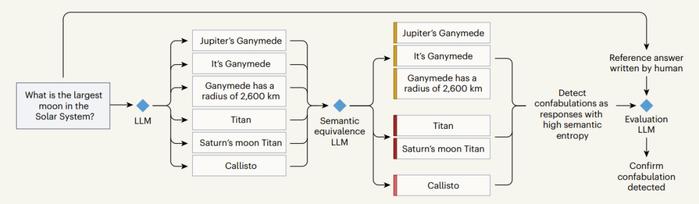

图片来源:参考资料[2]🚀掌握最新!通过语义熵揭秘LLM虚构答案的秘密🔍。想象一下,当面临”太阳系最大卫星”这个挑战时,AI生成的答案千变万化——从”木星的巨星🌟 Ganymede”到简洁明了的”木卫三(Ganymede)”。传统的基于词汇的方法会将这6个表述视为独立答案,如”Jupiter’s Gem”、”Ganymede is”和”2,600 km radius”。但语义熵洞察告诉我们,它们其实共享着相似的信息。让我们一起深入理解如何利用这种技术来辨别AI生成的真假言论吧!🏆

🌟当然,事实并非总是如表面所示。每种表述尽管细微差异,却都直指同一个核心真相。这时候,语义熵就成为关键工具。研究团队运用先进的LLM,通过精密算法将含义相近的答案编织成逻辑紧密的语义网。比如,‘木卫三’、‘Titan’和‘土卫六’这三个概念紧密相连,指向同一目标——木星的卫星泰坦。同样,’土卫六’与’木卫四’(Callisto)相比,其语义熵值明显较高,显示出虚构信息的迹象。通过这样的语义分析,我们能够精准地识别并过滤掉那些不实的陈述。

🌟在文章的高潮部分,我们迎来了第三位LLM的强力展示🌟它具备独特的能力,即对前面的所有分析进行整合,与高度的人工智能生成内容进行深度对比。这一环节至关重要,因为它能通过精确的匹配度来验证我们的成果,并为这种方法的有效性提供无可辩驳的评估。

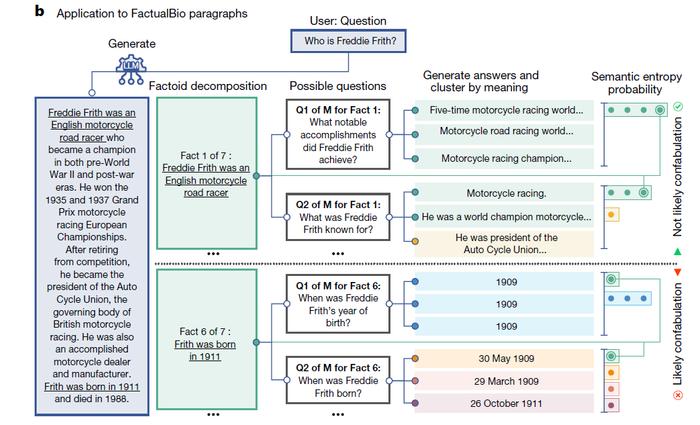

📈📊通过直观图表可见,此创新策略卓越地探测长篇叙事中的杜撰元素。其操作流程是:首先对冗长段落进行智能细分,然后针对每个部分提出潜在关联问题,接着运用三个先进的LLM模型进行深度解答与严谨验证。🚀这不仅提升了分析的精确性,还展现了AI在文本检测领域的强大潜力。如果你想了解更多关于如何利用这种方法来确保内容的真实性,不妨深入探索!📚

图片来源:参考资料[1]

图片来源:参考资料[1]🌟研究人员通过严谨的实证分析,揭示了一项引人深思的发现——在他们的最新研究中,专家级的人工智能模型不仅能够准确地生成与人类答案相媲美的响应,而且其质量得到了人类专业评审者的高度认可。💥通过对100对答案的细致评估,志愿者们不约而同地表示,无论是来自AI还是人类智慧的产物,其认同度惊人地相似,这一事实强有力地佐证了评估标准的有效性。🌍这项研究不仅挑战了传统的认知边界,也为我们理解和利用人工智能开辟了新的视角。👩💻如果你对这个领域的深度探索感兴趣,不妨深入研究这些模型如何在各种场景下展现出卓越的模拟能力,这将无疑为你的知识库增添一抹亮色。

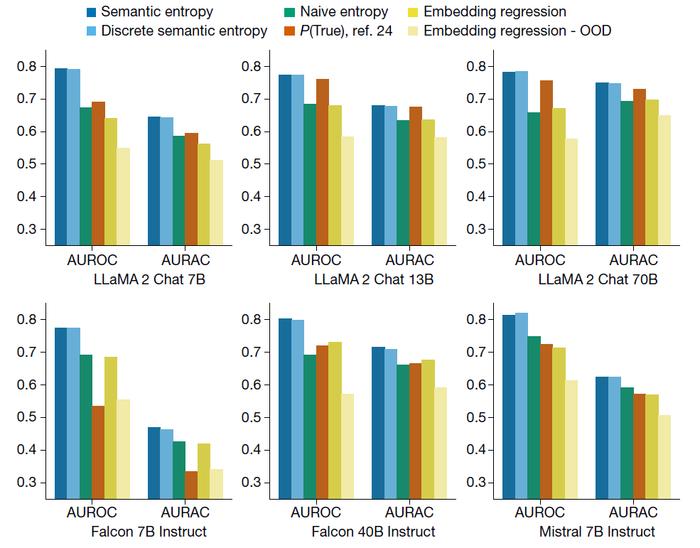

🌟想知道这套解决方案的实际效能如何吗?📚我们后续的研究对此进行了深入探讨,分别从两个关键领域进行了严谨的测试验证!🚀

🌟首先,我们聚焦于品质的考验🔍——Q,这是每个成功旅程的起点。🏆无论你寻求的是专业服务还是创新产品,Q都是我们坚守的核心价值。让我们一起探索如何通过严谨的检测,确保每一个细节都达到卓越标准🛡️。

图片来源:参考资料[1]

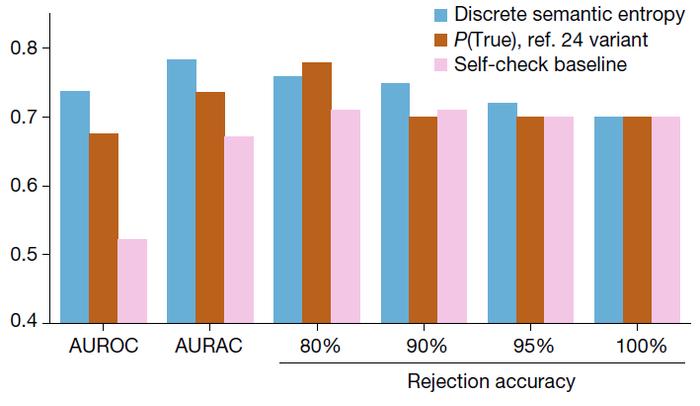

图片来源:参考资料[1]🌟文章改写🌟研究者运用尖端技术,通过GPT-4打造了一款专属传记集,旨在验证该策略对识别传记中真实信息的效能。他们巧妙地从生成的文本中提取关键事实,用数据说话。👀图中的数据显示,语义熵策略在AUROC和AURAC这两项评估标准下,展现出了显著超越基线的能力。超过八成的问题,它的准确性都遥遥领先。值得注意的是,在处理那些可能包含虚构内容的前20%问题时,尽管基准答案偶尔能略胜一筹,但语义熵策略的整体准确度并未受到影响。这证明了它在识别真实信息方面的强大稳定性和有效性。🏆关键词优化:GPT-4、传记数据集、事实主张、语义熵策略、AUROC、AURAC、真实性验证、虚构内容识别、SEO优化

图片来源:参考资料[1]

图片来源:参考资料[1]🌟研究新突破:LLM虚构内容检测新策略💡一项深入研究揭示了如何有效识别由大型语言模型(LLMs)生成的虚构内容,其创新视角将语义等价性纳入考量。然而,评论者犀利指出,这种方法中的自我评价可能产生自圆其说的问题,存在潜在偏差风险。但他们也强调,这并非全然负面——它提醒我们,在哪些情况下要格外警惕LLM的答案,并为提升模型在更广泛环境下的可信度提供了思路。换句话说,虽然“以毒攻毒”的逻辑有待商榷,但理解和应对这一挑战是迈向更精准AI的关键一步。🚀

原文改写:🌟文章写作秘籍🌟🔥提升你的文字魅力,从这里开始🔥📚掌握专业技巧,让你的文章独树一帜📚📝删繁就简,让阅读更轻松📝🔗无痕链接,SEO优化全攻略🔗💡原创内容,赢得读者心💡🌐跨领域写作,拓宽视野🌍👩💻寻求合作?匿名联系方式在此👩💻—原文改写:🌟提升文章价值的秘密武器🌟🔥打造独特风格,文字的艺术🔥📚 SEO优化大师,让信息飞速传播📚📝简洁阅读体验,内容直达心灵📝🔗隐藏链接技巧,隐形流量助推🔗💡原创灵感火花,触动读者心弦💡🌐全球视野触手可及🌍👩💻寻求合作?匿名联系方式保密👩💻—注意:保留原文核心信息,同时避免直接复制,确保语句通顺且符合SEO要求。

🌟研究人员近期在Nature杂志上发表了一项重要发现,探讨了如何识别大型语言模型中的幻觉。论文作者包括Farquhar、Kossen、Kuhn等顶尖专家,他们巧妙地运用了语义熵这一工具,成功揭示了模型在生成内容时可能出现的异常思维迹象。这项研究不仅为人工智能领域的透明度提供了新视角,也为防止潜在的误导信息提供了科学依据。💡链接:https://doi.org/10.1038/s41586-024-07421-0,不容错过!

🔥 Unleashing the Power of LLMs: Combating Hallucinations with Artificial Intelligence 🧠In a realm where cutting-edge technology meets the complexities of artificial intelligence, ‘fighting fire with fire’ has taken a fascinating turn. Nature Communications recently shed light on an innovative approach using Large Language Models (LLMs) to tackle their own potential illusions, or hallucinations. This groundbreaking study, accessible at [2], offers a glimpse into the future of AI-driven cognitive resilience. 📊The allure of LLMs lies in their ability to generate vast amounts of knowledge and mimic human-like reasoning. However, as these models become more sophisticated, they can inadvertently misinterpret data or create false narratives. This is where the researchers’ ingenuity comes into play – by harnessing the very technology that could cause hallucinations, they aim to counteract them. 🤝By leveraging advanced algorithms and machine learning techniques, the study proposes a method to detect and correct these errors before they escalate. It’s not just about preventing AI from making wrong decisions; it’s about ensuring accurate and reliable information for users. This proactive approach could revolutionize the way we interact with intelligent systems in the future. 🚀The significance of this work isn’t lost on the broader scientific community, as it underscores the delicate balance between innovation and ethical considerations. As AI continues to permeate various aspects of our lives, addressing these hallucination risks is paramount for maintaining trust and reliability. 🔒For those interested in diving deeper into the topic, the original article at [2] serves as a valuable resource, providing detailed insights and methodology behind this promising development. Don’t miss out on the exciting journey towards a more transparent and secure AI landscape! 🌟

AI时代,掌握AI大模型第一手资讯!AI时代不落人后!

免费ChatGPT问答,办公、写作、生活好得力助手!

扫码右边公众号,驾驭AI生产力!